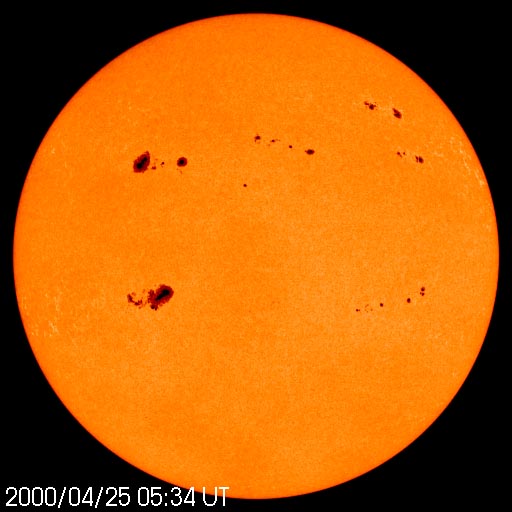

De bovenstaande opname isgemaakt door SOHO (Solar & Heliospheric Observatory) , een project van ESA en NASA met als doel het bestuderen van de zon. De opname dateert uit 2001. De donkere vlekken zijn zonnevlekken. Zoals te zien is waren dat er in 2001 alleen al op dit stukje van de zon behoorlijk veel. Sinds 2007 echter zijn er heel weinig zonnevlekken te zien, vaak lange tijden achtereen helemaal geen enkele. Dat is uitzonderlijk.

Er is een sterk vermoeden dat zonnevlekken invloed hebben op het klimaat op aarde. Een recente aanwijzing dat de zon aanmerkelijke invloed heeft op de temperatuur op aarde kwam in 2005 van Soon ( Soon, W. W.-H. (2005), Variable solar irradiance as a plausible agent for multidecadal variations in the Arctic-wide surface air temperature record of the past 130 years, Geophys. Res. Lett., 32, L16712, doi:10.1029/2005GL0234 ). Soon onderzocht de invloed van zonneactiviteit op de oppervlaktetemperaturen van de Arctische regio. De grafieken hieronder uit de studie van Soon laten aan duidelijkheid weinig te wensen over:

Vergelijk zelf de correlatie tussen de temperatuuronregelmatigheden van het totale Arctische gebied en de zonneactiviteit (bovenste grafiek) en dezelfde temperatuuronregematigheden en het CO2-gehalte van de atmosfeer (onderste grafiek).

De zon is de ster die het dichtst bij de aarde staat en vormt het middelpunt van ons zonnestelsel met haar planeten, en heeft een diameter van ongeveer 1.392.000 km ( ter vergelijking: de aarde heeft een diameter van 12.742 km ). De zon bestaat voornamelijk uit waterstof(massapercentage 70%) en helium (massapercentage 28%). De temperatuur aan het zonneoppervlak is 5800 kelvin , maar in de kern is dat 15,5 miljoen kelvin, terwijl de druk daar ongeveer 100 miljard keer de atmosferische druk op aarde is. Onder deze omstandigheden komen waterstofatomen komen zo dicht bij elkaar dat er fusie optreedt. Op dit moment is ongeveer de helft van de hoeveelheid aan waterstof in de kern van de zon omgezet in helium. Dit nam ruwweg 4,5 miljard jaar in beslag, dit is de ouderdom van ons zonnestelsel (en dus ok van de planeet aarde).

De berekende levensduur van een ster als de Zon, dat wil zeggen de tijd waarin kernreacties haar van energie voorzien, bedraagt 10 miljard jaar. Dat betekent dat we nog zo’n 5,5 miljard jaar te gaan hebben. Als de waterstof is uitgeput, zal de temperatuur van de zon aan het oppervlak dalen.De zon zal dan een zogenaamde “rode reus” worden en 10.000 keer helderder zijn dan momenteel. Na deze rode-reusfase zal de zon krimpen tot een witte dwerg (ongeveer ter grootte van de aarde) en gedurende enkele miljarden jaren langzaam afkoelen.

Zonnevlekken

Een interessant aspect van de zon zijn zonnevlekken. Zonnevlekken manifesteren zich als donkere vlekken aan het oppervlak van de zon. dat ze donkerder zijn dan de rest van de zon is het gevolg van een lagere temperatuur ter plekke. De oorzaak daarvan is dat het gebieden zijn waar het magnetisch veld veel sterker is dan elders op de zon. Door dit sterke magnetische veld wordt de temperatuur ten opzichte van de omgeving verlaagd tot 4000 a 4500 kelvin, doordat het geconcentreerde magnetische veld in de zonnevlek de toestroom van heet gas door convectie uit het binnenste van de zon verhindert.

Spectaculaire opname van een zonnevlek. Bron Wikipedia

Het aantal zichtbare zonnevlekken is niet constant, maar varieert met een periodiciteit van ongeveer 11 jaar, de zogenaamde zonnecyclus. De vlekken die aan het begin van een nieuwe cyclus te zien zijn, verschijnen het eerst in de buurt van de polen. Tijdens de zonnecyclus stijgt het aantal zonnevlekken en verplaatst deze zich in de richting van de evenaar van de zon. Daarna treedt er afname van het aantal vlekken op, tot het zonneminimum bereikt is. Bij een zonneminimum zijn weinig zonnevlekken zichtbaar, soms zelfs helemaal geen.

Op bovenstaande figuur (bron: NASA) zij de zonnecycli 12 t/m 23 te zien (onderzijde). Het bovenste deel van de figuur toont de omvang en ligging van de zonnevlekken ten opzichte van de zon-equator.

Onderstaand beeld is de huidige status van het aantal zonnevlekken op de zon. Het beeld is afkomstig van SOHO, Solar and Heliospheric Observatory van de NASA.

Zonnevlekken zijn tijdelijke koele gebiedjes op de zon. Ze leven enkele dagen tot enkele weken en het aantal vlekken dat zichtbaar is komt en gaat in een elfjaarlijkse cyclus. De zonnevlekken zijn omringd door helderder en hetere gebieden, de fakkelvelden. De temperatuur is er ongeveer 4000 graden hoger dan de oppervlakte van de zon. Fakkelvelden stralen daarom een versterkte ultraviolette straling uit. Die extra straling wordt echter vakkundig weggevangen in de stratosfeer, daar merken we op aarde niets van. Als er weinig zonnevlekken zijn, dan zijn er ook weinig fakkelvelden, en andersom.

Verder zijn er zogenaamde Coronale Massa Emissies (CME), enorme uitstotingen van elektromagnetisch geladen gaswolken. Deze CME’s vliegen met zeer grote snelheid door de ruimte. In de buurt van de aarde is hun snelheid vaak opgelopen tot meer dan 2000 km per seconde. De gemiddelde energie die uitgestoten wordt bij een CME is ongeveer 10 miljardmaal die van de Hiroshima-atoombommen. Het aantal uitgestoten CME’s varieert min of meer parallel aan het aantal zonnevlekken. Dus in periodes met veel zonnevlekken zijn er ook veel CME’s en andersom. Tijden van maximale zonnevlekactiviteit gaan samen met een zeer lichte stijging van de energie-output van de zon. Deze stijging ligt in de orde van grootte van 0,1% van de zonneconstante (1366 W/m2). Dit is dermate gering dat men er van uit kan gaan dat dit op zich nauwelijks invloed kan hebben op het klimaat op aarde.

Toch is het al lange tijd bekend dat er een correlatie lijkt te bestaan tussen de zonnevlekcyclus en de temperatuur op onze planeet.

Alhoewel pas sinds 1979 satellietmetingen gedaan worden aan zonnevlekken, is de observatie van het verschijnsel al zo oud als onze geschiedenis. Dat is niet verwonderlijk, want zonnevlekken zijn goed zichtbaar vanaf de aarde. Het was Heinrich Schwabe die tussen 1826 en 1843 de cyclische variatie van de zonnevlekken ontdekte, terwijl Rudolf Wolf vanaf 1848 het verschijnsel systematisch bestudeerde. Maar ook van de periode die daaraan vooraf ging zijn talloze observaties bewaard gebleven. Bekend is dat zonnevlekken in de tweede helft van de 17e eeuw nauwelijks werden waargenomen. Deze periode staat bekend als het Maunder Minimum (1645–1717).

Een wetenschappelijke reconstructie van zonneactiviteit en zonnevlekken is ook mogelijk. Zonneactiviteit, met name door CME’s, is namelijk van invloed op de productie van koolstof-14 en beryllium-10. De variaties in koolstof-14 zijn gering maar meetbaar. Beter bruikbaar is beryllium-10, en de variatie in het voorkomen van dit kosmogenetische isotoop beryllium-10 op aarde is een maat voor zonneactiviteit.

Zonnevlekken en klimaat

Opmerkelijk is dat ondanks de geringe fluctuaties in zonne-energie er toch allerlei aanwijzingen zijn dat zonnevlekken een aanzienlijke invloed hebben op de temperatuur op aarde. Wellicht het bekendste voorbeeld is de bovengenoemde Maunder Minimum, dat verbazingwekkend goed samenviel met een koelere periode, de zogenaamde Kleine IJstijd. Uit allerlei historische bronnen is bekend dat in deze periode in Europa de temperaturen lager waren dan “normaal”. Onderstaande figuur is een reproductie van een schilderij van de Hollandse schilder Hendrick Avercamp, genaamd Winterlandschap met IJsvermaak uit 1608. Er zijn in deze periode opvallend veel van dergelijke winterse schilderijen geproduceerd.

De afgelopen jaren heeft onderzoek aangetoond dat er een sterke correlatie bestaat tussen zonneactivieit en de temperatuur op aarde. Bovenstaande grafiek betreft een beroemd onderzoek van de Amerikaanse astrofysicus John A. Eddy , gepubliceerd in Science in 1976. De publicatie is genaamd “The Maunder Minimum” ( J.A.Eddy, 1976, Science, New Series, Vol. 192, No. 4245. (Jun. 18, 1976), pp. 1189-1202 ). In de grafiek zijn te zien de zonnecycli (groene lijn), de C14 proxy uit boomringen (rood) en de lengte van gletsjers (witte cirkeltjes).

Eddy was een van de wetenschappers die al vroeg een coorrelatie vermoedde tussen zonneactiviteit en wereldtemperatuur. Die correlatie is zichtbaar op diverse tijdschalen, die hierna besproken zullen worden.

Iemand die al lange tijd bezig is met de invloed van zonne-activiteit op het klimaat is Bas van Geel. Dr. Bas van Geel is paleo-ecoloog aan de Universiteit van Amsterdam. Hij doet onder andere onderzoek aan veenpakketten en sedimenten om de klimaatomstandigheden te reconstrueren ten tijde van het ontstaan van het veen en afzetting van de sedimenten.In een interview door Theo Richel van DeGroeneRekenkamer schetst van Geel op welke wijze zonne-activiteit van invloed is op het voorkomen van C14 en Be10, die op hun beurt uitstekende proxies zijn om het klimaat te reconstrueren.Van Geel hekelt het IPCC vanwege haar kortzichtigheid in deze materie, maar breekt tegelijkertijd een lans voor het zuiniger omspringen met fossiele brandstoffen.

Klik hier voor het filmpje op YouTube.

De zon is de laatste vijftig jaar actiever geweest dan hij in de afgelopen duizenden jaren is geweest. Misschien zelfs actiever dan in de laatste tienduizend jaar. Die extra zonne-activiteit van de laatste jaren ging gelijk op met die van de aardse temperatuur. Zie hieronder. In de bovenste grafiek is de dikke zwarte lijn de gemiddelde temperatuurlijn volgens GSN (Global Climate Observing System Surface Network data set).

Is er een samenhang tussen de extra zonneactiviteit en de recente temperatauurstijging? Een aantal wetenschappers denkt dus van wel. Professor de Jager, vooraanstaand astronoom , zegt hierover : “Evenals de toename van CME’s tussen 1610 en 1960 gepaard ging met een temperatuurtoename op aarde, zou dat ook het geval kunnen zijn voor de temperatuurtoename gedurende de laatste vijftig jaren. Maar dan moeten we vaststellen dat het aantal zonnevlekken, dat in de laatste vijftig jaar al zeer hoog was, in die periode niet verder gestegen, terwijl de aardtemperatuur in die periode juist wel toenam. Klopt er nu iets niet? Het voor mij verrassend antwoord is dat in die periode het aantal CME’s wel gestaag bleef stijgen, en wel tot nu aan toe. De grootste CME’s die ooit geregistreerd werden traden op in de jaren 2003 en 2005.”

Zonnestraling is niet constant maar varieert. Deze variaties in zonnestraling hebben een periodiciteit (regelmatige herhaling) maar er zijn ook aperiodische variaties bekend. Wellicht de bekendste cyclus is de Schwabe-cyclus met een periodiciteit van 11 jaar. Die Schwabe-cyclus is op onderstaande grafiek terug te zien als pieken in het aantal zonnevlekken.

Het is nog niet zo heel lang dat we de variaties in zonnestraling kunnen meten. Pas in 1978 werd de eerste satelliet gelanceerd die metingen verrichtte. De variaties van zonnestraling, zoals die van de Schwabe-cyclus, zijn gering: ongeveer 0.1% , wat overeen komt met een variatie van 1.3 W/m² (de zonneconstante is 1366 W/m² ).

Het aantal zonnevlekken wordt vaak als proxy gebruikt om de zonneactiviteit te reconstrueren in het pre-satelliet tijdperk. De grafiek hieronder is samengesteld met behulp van 2 proxies: zonnevlekken en Be10-isotopen. Maar ook C14 wordt gebruikt als proxy voor zonneactiviteit.

De Fin Ilya Usoskin publiceerde en 2003 een geruchtmakend artikel over zonnevlekken ( Ilya G.Usoskin e.a., Millennium-Scale Sunspot Number Reconstruction: Evidence for an Unusually Active Sun since the 1940s, 2003, PHYSICAL REVIEW LETTERS VOLUME 91, NUMBER 21). Hij ontdekte dat er vanaf 1940 meer zonevlekken waren dan in de afgelopen 1150 jaar. Onderstaande figuur is afkomstig uit zijn onderzoek.

Zoals te zien is is het aantal zonnevlekken verre van constant. Op de gebruikte tijdschaal zijn de 11-jaarscycli niet meer waarneembaar, maar wel een aanal andere hoogte- en dieptepunten van zonneactiviteit. In de grafiek heeft Usoskin de belangrijkste zonneactiviteit gebeurtenissen weergeven. Deze zijn:

Oort minimum 1040 – 1080

Medieval maximum 1100 – 1250

Wolf minimum 1280 – 1350

Spörer Minimum 1450 – 1550

Maunder Minimum 1645 – 1715

Dalton Minimum 1790 – 1820

Het laatste stuk van de grafiek toont:

Modern Maximum 1950 – 2004

Modern Minimum 2004 – gaande

Op een tijdschaal van 11.500 jaar zijn weer andere, grootschalige schommelingen te zien, waarbij met name de hoge zonnevlekactiviteit opvalt tot 6000 jaar BC.

De bekendste zonnecycli zijn:

11 jaar: Schwalbe cyclus

22 jaar: Hale cyclus

87 jaar (70–100 jaar): Gleissberg cyclus

210 jaar: Suess/de Vries cyclus

2,300 jaar: Hallstatt cyclus

6000 jaar: Xapsos/Burke cyclus

Maar behalve bovenstaande zonnecycli zijn er nog andere aperiodische veranderingen in de zonnestraling die van invloed zijn geweest op het wereldklimaat. Hieronder volgt een beschrijving van zonneactiviteit op een viertal tijdschalen.

Zonneactiviteit en temperatuur op een Phanerozoische tijdschaal

Jan Veizer is ongetwijfeld de grote pionier op het gebied van zonneactiviteit en temperatuur op een geologische schaal. Veizer is van oorsprong een geochemicus gespecialiseerd in isotopenonderzoek. Hij reconstrueerde met behulp van zuurstofisotopen het verloop van de zeewatertemperatuur in het Phanerozoicum, de geologische periode vanf het laat-Cambrium tot nu. Samen met andere wetenschappers vergeleek Veizer de data van zeewatertemperatuur met gegevens over de zogenaamde cosmic ray flux, de voortdurende stroom aan kosmische straling vanuit de ruimte.

In 2000 publiceerde Veizer samen met Godderis en François in Nature een artikel dat, ondanks voorzichtige formuleringen, insloeg als een bom ( Veizer, Ján; Godderis, Yves; François, Louis M. (2000): Evidence for decoupling of atmospheric CO2 and global climate during the Phanerozoic eon. In: Nature 408, 698-701 ). Een opzienbarende studie, waarin geconcludeerd werd dat CO2 in de atmosfeer voor tenminste 1/3 deel van het Phanerozoicum niet de drijvende kracht was achter temperatuurveranderingen, dan wel dat de gereconstrueerde CO2-concentraties onbetrouwbaar waren ( zie hieronder).

Duidelijk is te zien dat er nauwelijks een correlatie te zien is tussen CO2-gehalte en de temperatuur op aarde.

In 2003 publiceerde Veizer samen met de Israelische astrofysicus Shaviv een paper waarin niet CO2 maar kosmische straling de verklaring vormen voor de temperatuurfluctuaties op geologische tijdschaal ( Shaviv, Nir J.; Veizer, Ján (2003), “Celestial driver of Phanerozoic climate?”, GSA Today 13 (7): 4–10 ).

Bovenstaande figuur toont zeldzaam mooi de correlatie tussen de cosmic ray flux (rode lijn boven ) en de gereconstrueerde temperatuur (zwarte lijn onder). Voor Veizer en Shaviv was het duidelijk: op geologische schaal was de zon de sturende factor voor de temperatuur op aarde. De vraag wat de oorzaak is van deze fluctuaties van de kosmische straling op de geologische tijdschaal wordt door Shaviv beantwoord: dat is het gevolg van de baan die ons zonnestelsel door de Melkweg maakt.

Op onderstaande impressie van het Melkwegstelsel (bron: NASA) is duidelijk te zien dat het stelsel bestaat uit een centrum (met veelal oudere sterren) en een aantal spiraalvormige armen. Die armen zijn in feite langgerekte structuren gevormd door een verdichting van sterren en interstellaire materie.Binnen deze spiraalarmen vindt voortdurend vorming van nieuwe sterren plaats. Het geheel, het centrum en de spiraalarmen, heeft de vorm van een platte schijf.

Centraal in de theorie van Shaviv staat de baan die ons zonnestelsel aflegt in deze spiraavormige structuur. Daarbij kruist de aarde in de loop van de geologische tijdschaal de spiraalvormige armen, waardoor de aarde zich dan wer binnen een arm bevindt en daarna in de ruimte tussen twee armen.

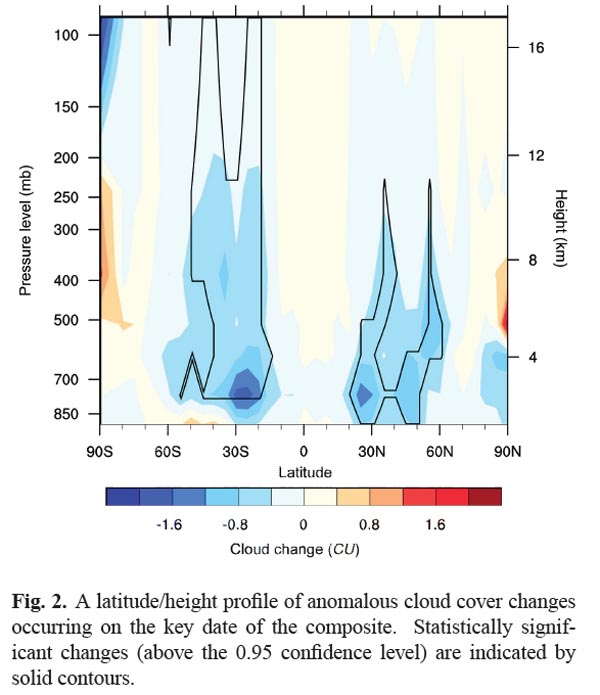

Binnen een arm is de zognaamde cosmic ray flux , de mate van kosmische straling, groter dan daarbuiten. Volgens de theorie van Svensmark die we later nog zullen tegenkomen is het te verwachten dat bij een grote flux de temperatuur op aarde daalt.

Een illustratie van Shaviv uit de paper “The Milky Way Galaxy’s Spiral Arms and Ice-Age Epochs and the Cosmic Ray Connection,2006, Sciencebits.com” lijkt dit te bevestigen :

Op bovenstaande figuur is te zijn dat zodra onze planeet zich in een arm bevindt (bovenste paneel) de flux stijgt (tweede paneel). Op het derde paneel zijn de glaciale periodes van onze planeet weergegeven, met helemaal links de meest recente koudeperiode van het Kwartair, waar we ons nog steeds in bevinden.

Zonneactiviteit en temperatuur op een Kwartaire tijdschaal

Milanković theorie beschrijft de effecten van de beweging van de planeet aarde op het wereldklimaat. Die bewegingen hebben effect op een tweetal zaken: de afstand tot de zon en de hoek van de aardas ten opzichte van het vlak van draaiing. De variaties in zonnenstraling die door de eerste factor ontstaan wijken af van wat hiervoor en hierna beschreven staat, namelijk dat de afstand tot de zon vooral invloed heeft op de zonneconstante (en niet op de fluctuaties in zonnevlekken).

De hoek die de aardas maakt is van invloed op wijze waarop de aarde “gericht” is op de zon. Onder andere vanwege de ongelijke verdeling van de land-watermassa’s op onze planeet en de ligging van land- en drijfijs heeft die hoek invloed op de hoeveelheid zonnenstraling die door de aarde geabsobeerd wordt en omgezet in warmte. Een vorm van interne variabilteit dus. De combinatie van beide factoren beinvloedt de temperatuur op aarde en vormen de verklaring voor het onstaan van grote temperatuurschommelingen gedurende het Kwartair, de glacialen en interglacialen.

Milutin Milanković (Dalj, 1879 – 1958), civiel ingenieur en wiskundige, beschrijft in een publicatie in 1941 dat de variaties in de baan van de aarde rond de zon (excentriciteit), de variaties in de aardashoek (obliquiteit) en de tolbeweging van de aardas (precessie) van invloed zijn op de temperatuur op aarde. Als gevolg van deze variaties varieert de temperatuur op aarde en zijn de ijstijden gedurende het Kwartair (2,5 miljoen jaar – heden) te verklaren.

De onderste curve toont het berekende effect van de excentriciteit, precessie en obliquiteit op de hoeveelheid ontvangen zonne-energie die op een zomerse dag aan de buitenkant van de dampkring op een vierkante meter wordt ontvangen op 65 graden NB. Omdat de periodiciteit van de 3 factoren bekend is kan ook berekend worden wat het effect in de toekomst zal zijn. De grafieken lopen dan ook van -800.000 jaar A.D. tot +800.000 jaar A.D.

Bovenstaande grafiek toont de juni-instraling op 65 graden NB gedurende de afgelopen 600.000 jaar, zoals berekend door Berger c.s. (A. Berger and M.F. Loutre, 1991, Insolation values for the climate of the last 10 million years. Quaternary Science Reviews, 10: 297-317).

De reacties vanuit de wetenschappelijke wereld waren grotendeels negatief en afwijzend. Het duurde tot 1976 voordat een studie van Hays, Imbrie en Shackleton naar boorkernen in diepzeesedimenten het gelijk van Milanković aantoonde en de wetenschappelijke wereld Milanković theorie aanvaardde ( J. D. Hays, John Imbrie and N. J. Shackleton,1976, Variations in the Earth’s Orbit: Pacemaker of the Ice Ages, Science Vol. 194. no. 4270, pp. 1121 – 1132).

De waarde van Milancović theorie werd nogmaals bevestigd door onderzoek aan ijskernen van Antarctica in 2007. De in de ijskeren aanwezige luchtbelletjes werden onderzocht op de aanwezigheid van zuurstof en stikstof. De waardes daarvan worden direct bepaald door de grootte van de instraling ter plaatse (Kawamura et al., Nature, 23 August 2007, vol 448, p912-917) .

Excentriciteit, obliquiteit en precessie beïnvloeden de stralingsbalans van de aarde als gevolg van variaties in de hoeveelheid zonnestraling en de oriëntatie van landmassa’s ten opzichte van de zon. Dit verschijnsel staat bekend al solar forcing.

Excentriciteit.

De baan van de aarde rond de zon is een ellips. Excentriciteit is de mate waarin deze ellips afwijkt van een cirkel. Deze excentriciteit varieert in de tijd van bijna cirkel (excentriciteit van 0,005) tot licht elliptisch (excentriciteit 0,028). De huidige excentriciteit bedraagt 0,017. De periodiciteit van de excentriciteit kent 2 schalen: een van 413.00 jaar en een tweede van grofweg 100.000 jaar.

Deze variaties in excentriciteit ontstaan door de invloed van de zwaartekracht van de planeten Saturnus en Jupiter. Momenteel is het verschil in afstand tussen het punt van de aardbaan dat het dichtst bij de zon ligt (perihelion) en het punt dat het verst van de zon verwijderd ligt (aphelion) 5,1 miljoen kilometer, resulterend in een verschil van inkomende zonnestraling van 6,8%. Als de baan zijn maximale excentriciteit heeft bereikt bedraagt dit verschil zelfs bijna 23%.

Obliquiteit

De hoek die de aardas maakt met het vlak waarin de aarde rond de zon draait varieert van 22,1° tot 24,5°, met een periodiciteit van 41.000 jaar. De invloed van obliquiteit op de temperatuur op aarde is het gevolg van het feit dat de landmassa’s ruimtelijk bezien niet gelijkmatig verdeeld zijn over de aarde. Bij een grotere hoek nemen de verschillen tussen de seizoenen voor wat betreft de instraling van de zon toe. Zowel op het noordelijk als het zuidelijk halfrond worden de zomers dan warmer en de winters kouder. Momenteel neemt de obliquiteit af en is 23,44° , waarmee we ons grofweg halverwege de beweging bevinden.

Echter, deze verschillen tussen zomer en winter zijn niet even groot. Bij toenemende obliquiteit neemt de gemiddelde jaarlijkse instraling op hogere breedte toe, terwijl op lagere breedte de instraling afneemt. Op hogere breedte veroorzaakt een lage obliquiteit derhalve zowel een lagere gemiddelde instraling op deze breedte als de afname van instraling in het zomerseizoen. Koele zomers kunnen dan het begin van een ijstijd triggeren doordat minder sneeuw smelt en de albedo in sommige gebieden sterk verandert.

Precessie

Precessie is de tolbeweging van de aardas, en heeft een periodiciteit van ongeveer 26.000 jaar. Precessie is het gevolg van de getijdekrachten die zowel de zon als de maan op de aarde uitoefenen, versterkt door het feit dat de aarde niet perfect rond is. Net zoals bij obliquiteit is het effect van precessie op de temperatuur op aarde het gevolg van het feit dat de landmassa’s ruimtelijk bezien niet gelijkmatig verdeeld zijn over de aarde.

Als de aardas gedurende het perihelion naar de zon wijst zal het ene polaire halfrond grotere seizoensverschillen kennen, terwijl het andere halfrond kleinere verschillen kent. Momenteel kent het zuidelijk halfrond wat grotere verschillen tussen zomer- en wintertemperatuur als gevolg van de precessie dan het noordelijk halfrond.

Op onderstaande grafiek van Jouzel et al. uit 1996 ( Jones, P.D., Bradley, R.S. and Jouzel, J. (Editors), 1996, “Climate Variations and Forcing Mechanisms of the Last 2000 Years.” 649pp Springer-Verlag, Berlin ) is het relatieve verloop van de temperatuur te zien vanaf 220.000 jaar geleden. Duidelijk zijn het Saalien en het Weichsel glaciaal te onderscheiden. We bevinden ons momenteel rechts in de grafiek. Let op de grote snelheid waarmee een glaciaal overgaat in een warmer interglaciaal. Andersom gaat veel geleidelijker.

Van belang is om in het oog te houden dat de hierboven beschreven invloeden van de zon op Kwartaire schaal alles te maken hebben met de de grootte van de hoeveelheid ontvangen zonne-energie en de ligging van landmassa’s ten opzichte van de zon. Dit in tegenstelling tot de hiervoor beschreven zonneactiviteit en temperatuur op een geologische tijdschaal, die te maken heeft met de flux in cosmic rays als gevolg van zonneactiviteit. Dit laatste is ook weer de drijvende kracht achter de volgende invloed op nog kortere tijdschaal, de 1500 jaarcyclus.

Zonneactiviteit en temperatuur op historische tijdschaal

Bovenstaande figuur is uit een studie van Bond c.s. uit 2001, gepubliceerd in Science ( Bond, G., Kromer, B., Beer, J., Muscheler, R., Evans, M.N., Showers, W., Hoffmann, S., Lotti-Bond, R., Hajdas, I. & Bonani, G., 2001. Persistent solar influence on North Atlantic climate during the Holocene. Science 294, p. 2130-2136). Bond en zijn team onderzochten de afzettingen die door ijsbergen op de bodem van het noordelijk deel van de Atlantische Oceaan zijn afgezet vanaf het einde van de laatste ijstijd tot nu toe. Behalve dat in koude periodes de sedimenten veel verder van de landijsmassa’s werden afgezet , varieert ook de dikte van de sedimenten behoorlijk (zwarte lijn).

De blauwe lijn representeert de zonne-activiteit in de vorm van C14 isotopen in bomen en Be10 isotopen uit ijskernen in Groenland. De aanwezigheid van deze isotopen is sterk gelinkt met zonne-activiteit en de hoeveelheid kosmische straling die de dampkring bereikt.

In de grafiek is te zien dat zonneaciviteit en temperatuur nauw samenhangen, en dat er duidelijk sprake is van periodiciteit van deze verschijnselen van 1500 jaar +/- 500 jaar.

Zonneactiviteit en temperatuur op een centenniale tijdschaal

Camp & Tung ontdekten dat bij weergave van data van de opppervlaktetemperatuur tussen 1959 en 2004 en de zonnecycli in de gegeven periode er een temperatuurveschil van bijna 0,2 kelvin is tussen maximum en minimum.( Camp en Tung, Surface warming by the solar cycle as revealed by the composite mean,2007, Geophysical Research Letters, Vol. 34, L14703, doi:10.1029/2007GL030207). Zie de grafiek hieronder.

De rode plusjes en blauwe rondjes geven resultaten weer van variaties in temperatuurmetingen (linker vertikale as) , de zwarte lijn geeft de zonnecyclus weer (rechter vertikale as).

Op bovenstaande figuur (bron: NASA) zij de zonnecycli 12 t/m 23 te zien (onderzijde). Het bovenste deel van de figuur toont de omvang en ligging van de zonnevlekken ten opzichte van de zon-equator.

Diep zonneminimum levert raadsels op

David Hathaway van NASA heeft een mogelijke verklaring gevonden voor het diepe zonneminimum dat al een tijdje de gemoederen van astrofysici beheerst. Hij denkt dat dit te maken heeft met de hoge snelheid van de zogenaamde Conveyor Belt . De Conveyor Belt bestaat uit 2 stromingen van heet plasma in het binnenste van de zon. Elke Belt doet zo’n 40 jaar over een rondje. Onderzoekers denken dat de stromingen van beide Belts de zonnecycli sturen. Hathaway publiceerde onlangs over dit onderwerp in Science (Variations in the Sun’s Meridional Flow over a Solar Cycle, Science 12 March 2010:Vol. 327. no. 5971, pp. 1350 – 1352).

Hathaway maakt gebruik van data die sinds 1996 beschikbaar zijn door SOHO, Solar and Heliospheric Observatory . Deze periode omspant precies zonnecyclus 23 en het diepe minimum waarin we ons de afgelopen 2 jaar bevonden, het diepste van bijna 100 jaar. . Op onderstaande grafiek is te zien dat de acceleratie in omloopsnelheid van de Conveyor Belt samen valt met een afname van het aantal zonnevlekken van cyclus 23.

Dat is opmerkelijk, omdat tot nu toe er van uit gegaan is dat een snellere Conveyor Belt zorgt voor meer zonnevlekken. Ook de snelheid waarmee de zonnevlekken bewegen komt niet overeen met de gangbare theorieën. Om meer te weten te komen over dit fenomeen moeten wetenschappers dieper in de zon kunnen kijken. SOHO scant de zon slechts oppervlakkig, zodat het wachten is op data van SDO, Solar Dynamics Observatory, die afgelopen februari is gelanceerd.

Omdat er de laatste tijd enige activiteit op de zon is te bespeuren, denkt Hathaway dat er wellicht een eind gekomen is aan het minimum, en dat dat we aan het begin staan van cyclus 24. Hathaway verwacht dat die cyclus veel minder actief zal zijn dan de voorafgaande cycli (zie hieronder).

Zonnevlekken zijn tijdelijke koele gebiedjes op de zon. Ze leven enkele dagen tot enkele weken en het aantal vlekken dat zichtbaar is komt en gaat in een elfjaarlijkse cyclus. De zonnevlekken zijn omringd door helderder en hetere gebieden, de fakkelvelden. De temperatuur is er ongeveer 4000 graden hoger dan de oppervlakte van de zon.

Een langdurige afkoeling staat waarschijnlijk voor de deur.

In het hoofdstuk “De Feiten” staat al het een en ander geschreven over de zon , zonnecycli en de invloed daarvan op het aardse klimaat. Hathaway van NASA denkt dat de komende cyclus 24 minder krachtig zal zijn dan de voorgaande, en hij wordt daarin gesteund door meer zonnefysici zoals de Nederlander De Jager. Nu was al wat langer bekend dat het lange uitblijven van cyclus 24 erg veel lijkt op een situatie aan het begin van de 17e eeuw. Dat luidde toen een langdurige periode in van koude winters in Europa, de Kleine IJstijd of Maunder Minimum.

Het fysische proces dat het magnetisch veld van de zon veroorzaakt wordt de zonnedynamo genoemd. Het proces is vergelijkbaar met het ontstaan van het aardmagnetisch veld. De belangrijkste processen spelen zich af in de zogenaamde tachocline, een laag van enkele tienduizenden km dikte op een diepte van 200.000 km onder het zonsoppervlak. De daar opstijgende gasmassa’s gaan wervelen als gevolg van de zonnerotatie. De hierdoor ontstane elektrische velden genereren op hun beurt weer sterke magneetvelden.

De richting van het magnetisch veld keert ongeveer elke 11 jaar om, waardoor de zonnevlekkencyclus gestuurd wordt. Behalve deze 11-jarige cyclus is er ook sprake van een periodiciteit op een langere tijdschaal. Die periodiciteit is goed te herkennen op de eerste figuur hierboven. Men kan de volgende periodes onderscheiden:

1645-1715 Maunder Minimum

1715 – 1780 reguliere oscillaties

1780-1880 zwak Dalton Minimum

1880 – 1924 reguliere oscillaties

1924 – 2000 Groot Maximum 20e eeuw

2000 – 2013 transitie naar volgende fase

2013 – ? Groot Minimum

Cyclus 24 liet lang op zich wachten : hij begon niet in 2007- 2008 zoals verwacht, maar pas heel zwakjes in 2010. Het polaire veld is zwakker dan ooit gemeten, wat ook wijst op een sterk verlate en zwakke cyclus 24. De top wordt rond 2014 verwacht. Ook bij het begin van het Maunder Minimum was er sprake van een dergelijke situatie zoals momenteel. NOAA houdt op haar website de zonneactiviteit nauwkeurig bij . Onderstaande grafiek is de meest recente en betreft het aantal zonnevlekken en het door NOAA voorspeld verloop van cyclus 24.

Het dynamosysteem bevindt zich momenteel in een chaotische transitiefase, vergelijkbaar met periode vlak voor het Maunder Minimum. De Jager gaat er van uit dat dit komende Grote Minimum van het Maunder type zal zijn. In zijn recente publicatie legt hij uit op grond waarvan hij dit verwacht ( S. Duhau and C. de Jager, The Forthcoming Grand Minimum of Solar Activity, Journal of Cosmology, 2010, Vol 8, 1983-1999. )

De variabiliteit van de zon wordt bepaald door 2 componenten van het magnetisch veld, de zogenaamde torroidale component en de poloidale component. Omdat beide componenten niet direct worden gemeten gebruiken fysici – net als bij temperatuurreconstructies – proxies. Voor de torroidale component is de Rmax , het maximum aantal zonnevlekken in een cyclus. De grafiek hierboven is daar een voorbeeld van. De proxy voor de poloidale magnetische veldsterkte is aamin , de minimum waarde van de aa magnetische component. In onderstaande grafieken is het verloop van beide proxies in de tijd weergegeven.

Die variabiliteit resulteert in een aantal karakteristieke cycli. Afgezien van de 11-jaars Schwabe cyclus zijn de belangrijkste de Hale periodiciteit (17 – 32 jaar), de Lower Gleissberg (34 – 68 jaar), de Upper Gleissberg (72- 118 jaar) en de Suess (De Vries) ( ≈ 205 jaar).

Met behulp van Fourier-analyses hebben De Jager en Duhau getracht grip te krijgen op deze ogenschijnlijk ongeordende zonnecycli. Het blijkt dat het dynamosysteem van de zon zich geleidelijk ontwikkelt via drie cycli, gescheiden door korte chaotisch verlopende transitiefases. Deze cycli zijn een stapeling van de Gleissberg cyclus en twee daarvan afgeleide quasi-harmonischen, te weten een 50-jarige en een 20-jarige oscillatie.

Vanaf 2000 bevinden we ons in een dergelijke chaotische transitiefase, die volgens De Jager tot 2013 zal duren. Deze fase vormt dan de opmaat voor een relatief koude periode van tenminste 100 jaar.

De zonnedynamo is vergelijkbaar met het ontstaan van het aardmagnetisch veld. De belangrijkste processen spelen zich af in de zogenaamde tachocline, een laag van enkele tienduizenden km dikte op een diepte van 200.000 km onder het zonsoppervlak. De daar opstijgende gasmassa’s gaan wervelen als gevolg van de zonnerotatie. De hierdoor ontstane elektrische velden genereren op hun beurt weer sterke magneetvelden.

Bron: De Jager

De variabiliteit van de zon wordt bepaald door 2 componenten van het magnetisch veld, de zogenaamde torroïdale component en de poloïdale component. Omdat beide componenten niet direct worden gemeten gebruiken fysici – net als bij temperatuurreconstructies – proxies. Voor de torroïdale component is dat de Rmax , het maximum aantal zonnevlekken in een cyclus. In de grafiek hierboven is het verloop van de Rmax te zien vanaf 1100 na Chr. Met behulp van de proxies 14C en 10Be is een reconstructie van zonnevlekken tot ~850 v.Chr. mogelijk.

Wat opvalt in de grafiek is dat vanaf 1100 de langetermijntrend een dalende is tot ongeveer 1640, als het dieptepunt tijdens het Maunder Minimum bereikt wordt. Dat is de relatief koele periode die in Europa bekend staat als de Kleine IJstijd. Daarna stijgt de torroïdale activiteit weer tot het einde van de vorige eeuw.

Bron: De Jager

Voor de poloïdale component wordt de geomagnetische index gebruikt. De proxy voor de poloïdale magnetische veldsterkte is aamin , de minimum waarde van de aa magnetische component. In bovenstaande grafiek is het verloop van deze index vanaf 1100 n. Chr. weergegeven. Duidelijk is te zien dat de grafiek nagenoeg hetzelfde verloop toont als die van de Rmax . De richting van het magnetisch veld keert ongeveer elke 11 jaar om, waardoor de zonnevlekkencyclus gestuurd wordt. Gedurende de elfjarige cyclus wisselen de twee velden in sterkte: als het veld rond de evenaar maximaal is, is het polaire veld minimaal en omgekeerd.

Behalve deze 11-jarige cyclus, Schwabe-cyclus genaamd, is er ook sprake van een periodiciteit op een langere tijdschaal:

Hale cyclus: 22 jaar

Lower Gleissberg cyclus: 70 jaar

Upper Gleissberg cyclus: 100 jaar

De Vries Cyclus: 205 jaar

Halstatt cyclus: 2300 jaar

Er is de afgelopen tijd een reeks van wetenschappelijke publicaties geweest die verwezen naar een correlatie tussen zonneactiviteit en temperatuur op aarde. Een van de meest recente is een publicatie van De Jager, Duhau en van Geel uit 2010. Daarin komen ze voor het eerst tot nauwkeurige schattingen over de bijdrage van zonneactiviteit op de oppervlaktetemperatuur van de aarde, waarover verderop meer.

Coughlin & Tun (2004) hebben onderzoek gedaan naar de correlatie tussen de torroïdale component en de troposferische temperatuur in de 11-jarige Schwabe cyclus. Zij vergeleken daartoe de temperatuurreeksen van NCEP/NCAR tussen 1958 en 2003 met de zonnevlekactiviteit in dezelfde periode. Tijdens een periode met maximale zonnevlekken is de toename van de totale energie van de zon niet spectaculair, namelijk ongeveer 0,1%. Maar de toename van de hoeveelheid UV-straling is wel groot: 6 tot 8%. Coughlin et al maken gebruik van een methode genaamd “empirical mode decomposition”. Daarbij herkennen ze in de temperatuurreeks (en de zogenaamde geopotentiele hoogte) een vijftal oscillaties en een langjarige trend. In onderstaande figuur is dat weergegeven.

Bron: Coughlin

Bron: Coughlin

Te zien is dat in het 700 hPa drukvlak de 4e oscillatie zeer goed overeen komt met de elfjarige zonnevlekkencyclus. De correlatiecoëfficiënt tussen beide data is + 0,72, zeer hoog dus. Ook hoger in de troposfeer blijft de correlatie in stand. De onderzoekers concluderen: “Statistical tests show that this signal is different from noise, indicating that there is enhanced warming in the troposphere during times of increased solar radiation. ” .

Usoskin et al (2004) onderzochten de correlatie tussen de zonnevlekken vanaf 850 n. Chr. op basis van een reconstructie m.b.v. 10Be data en de temperatuurreconstructies op het NH van Mann& Jones (2003)en Mann et al (1999).

Bron: Usoskin

Bron: Usoskin

Rekening houdend met een time lag van ongeveer 10 jaar waarbij de zonnevlekken de temperatuur sturen komen Usoskin et al op een correlatiecoëfficiënt voor de temperaturen op het NH van 0,71 (Mann & Jones) tot 0,83 (Mann et al) met een significantieniveau van > 95%.

De Jager et al (2006) zochten naar de correlatie tussen 7 temperatuurreeksen en zonneactiviteit. Hierbij wordt een onderscheid gemaakt tussen de veranderingen in stralingsactiviteit van de zon (met name de fluctuaties in de UV-straling) enerzijds en de invloed van het zonmagnetisch veld op het cosmic-ray-niveau op aarde anderzijds.

Bron: De Jager

Bron: De Jager

De Jager et al concluderen dat op langere termijn er een duidelijke correlatie is tussen de UV-fluctuaties en temperatuur, en een minder duidelijke correlatie is tussen cosmic rays en temperatuur. Zie voor cosmic rays Svensmark in het hoofdstuk “Nieuwe Inzichten”.

Scafetta (2009) ontwierp met behulp van satellietdata vanaf 1980 een model om de invloed van zonneactiviteit op de aardse temperatuur te kunnen reconstrueren. Hij maakt daarbij gebruik van een aantal datasets waarvan de gevolgen voor de temperatuur nogal uiteen lopen. Zo voorspelt PMOD een afkoeling bij stijgende zonneactiviteit, terwijl andere datasets bv. ACRIM) een aanzienlijke opwarming aangeven, waarbij het aandeel van de zon tot 65% oploopt.

Scafetti concludeert dat de invloed van de zon op recente temperatuurveranderingen aanzienlijk is, en wijt het standpunt van het IPCC (2007) dat de zon een verwaarloosbare rol speelt in de opwarming aan het gebruik van foute zonnedata. Zijn bevindingen wijzen op een grote gevoeligheid van het klimaatsysteem. Zelfs kleine fouten in het modelleren kunnen daardoor klimaatmodellen onbruikbaar maken. Men kan hierbij denken aan de vraag hoe albedo, wolkendek, waterdamp feedback, LW- straling reageren op temperatuurveranderingen op decadale schaal.

Le Mouël et al (2009) onderzochten voor 203 weerstations in de USA, Europa en Australië of er een verband bestaat tussen het temperatuurverloop en zonneactiviteit, i.e. aantal zonnevlekken en magnetisch velddata van de zon.

Bron: Mouel

Bron: Mouel

Conclusie: “We conclude that significant solar forcing is present in temperature disturbances in the areas we analyzed and conjecture that this should be a global feature.”.

Behalve bovengenoemde studies is er nog een veelvoud recentelijk beschikbaar gekomen die een correlatie tussen zonneactiviteit en temperatuur aantonen. Daarbij wordt gebruik gemaakt van paleoklimatologische reconstructies op basis van 14C en 10Be, waarbij onderzoek gedaan wordt aan gletsjers, meerafzettingen, veenvorming, zeesedimenten door drijfijs, stalagmieten en landijs.

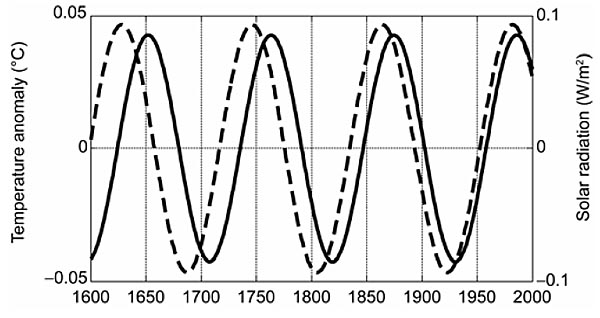

In de reeds genoemde publicatie van De Jager, Duhau en van Geel (2010) trachten de auteurs het verband tussen de torroïdale en poloïdale componenten van de zonnedynamo en de oppervlakte temperatuur van de aarde kwantitatief beter te onderbouwen. Zij vergeleken daartoe temperatuurreeksen van de periode 1610-1970 met veranderingen in zonneactiviteit. Met name de Hale cyclus van 22 jaar, Lower Gleissberg cyclus van 70 jaar, de Upper Gleissberg cyclus van 100 jaar en de De Vries Cyclus van 205 jaar blijken goed te correleren met de gebruikte zeven temperatuurreeksen.

Aan de hand van die zeven temperatuurreeksen is vastgesteld dat de gemiddelde stijging van de globale temperatuur in de periode 1610—1970 0,087 °C/eeuw is geweest. Daarvan is 0,077 °C/eeuw gecorreleerd aan de torroïdale component van het magnetisch veld van de zon. De helft van deze 0,077 °C/eeuw wordt veroorzaakt door de toename van de TSI (Total Solar Irradiance) in deze periode, terwijl de andere helft veroorzaakt is door de positieve feedback van waterdamp als gevolg van de gestegen temperatuur.

Maar volgens de onderzoekers hebben de veranderingen van het magnetisch veld van de zon ook een negatieve component: de poloïdale component wordt geschat op -0,040 °C/eeuw. Daarvoor zijn vooral de sterke polaire zonnewinden verantwoordelijk, die op hun grootst zijn als het aantal zonnevlekken minimaal is. Tegelijk is de cosmic ray flux die de aarde bereikt groot. De door diverse onderzoekers aangedragen relatie met wolkvorming (Svensmark en anderen) is tot nu toe nog onvoldoende gestaafd.

Wat overblijft, als men de rekensom netjes volgt, is een positieve component van 0,051 °C/eeuw waarvoor de onderzoekers geen verklaring hebben: het is gecorreleerd aan ‘klimatologische processen’. Daarin kunnen forcings van antropogene oorsprong een rol spelen, maar ook natuurlijke processen van terrestrische oorsprong. Welke en in welke mate is nog onzeker. Conclusie: er komt steeds meer bewijs dat ‘solar forcing’ een belangrijke rol speelt bij klimaatveranderingen, en dat tegenkoppelingen de effecten versterken.

Bron: De Jager

Bron: De Jager

Het dynamosysteem bevindt zich momenteel in een chaotische transitiefase, vergelijkbaar met periode vlak voor het Maunder Minimum. De Jager gaat er van uit dat dit komende Grote Minimum van het Maunder type zal zijn. In een recente publicatie legt hij uit op grond waarvan hij dit verwacht ( S. Duhau and C. de Jager, The Forthcoming Grand Minimum of Solar Activity, Journal of Cosmology, 2010, Vol 8, 1983-1999. ).

Op onderstaande grafieken is het verloop van Rmax en aamin te volgen.

Bron: De Jager

Eens in de zoveel tijd raakt het systeem door nog onbekende reden instabiel. Zo’n situatie werd in 2008 bereikt. Deze situatie hebben we al eens eerder gehad, namelijk vlak voor de Kleine IJstijd, het Maunder Minimum. Weliswaar klimmen we momenteel heel voorzichtig uit een diep minimum, maar volgens De Jager zal cyclus 24 niet veel voorstellen. Daarna begint volgens hem een langdurig minimum dat een groot deel van deze eeuw in beslag zal nemen, misschien een soort Maunder Minimum. Over een paar decennia weten we meer.

Prof. Horst Malberg, voormalig directeur van het ‘Institut für Meteorologie der Freien Universität Berlin’, heeft een interessant essay geschreven over de rol van de zon op het klimaat. In mijn bijdrage van 1 april j.l. ben ik al uitgebreid ingegaan op de recente publicaties van prof. De Jager over de invloed van de zon op klimaatveranderingen. De bijdrage van Malberg bevestigen de Jagers conclusie, namelijk dat de zon meer dan andere ‘forcings’ de drijvende kracht is achter klimaatveranderingen.

Bron: NOAA

Bron: NOAA

Malberg vergelijkt het gemiddeld aantal zonnevlekken van 3 opeenvolgende 11-jarige Schwabe-zonnecycli met het temperatuurverloop gedurende die zonnecycli in onder andere Midden Europa. Beide zijn uitgedrukt in anomalieën, veranderingen ten opzichte van een bepaalde referentieperiode. In bovenstaande figuur is de bekende temperatuurtrend te zien vanaf het einde van de Kleine IJstijd (Maunder Minimum) : een oplopende temperatuur tot de 19e eeuw, dan weer een afkoeling (Dalton Minimum) en daarna de opwarming van de 20e eeuw. Daarmee volgt de temperatuurtrend van Midden Europa die van de globale temperatuur met een correlatiecoëfficiënt van + 0,94.

Het is hier al eerder opgemerkt dat de meeste temperatuurgrafieken die betrekking hebben op klimaatverandering niet in de 17e eeuw beginnen, zoals bovenstaande grafiek, maar in de tweede helft van de 19e eeuw. Logisch , want veel meteorologische diensten, zoals ook het KNMI, begonnen in die periode met hun metingen. Maar daardoor komt alleen de laatste opwarming vanaf 1880 in beeld, waardoor de indruk gewekt kan worden dat deze temperatuurstijging uniek is. Dat beeld werd nog versterkt door de foutieve reconstructie van de globale temperatuur sinds 1100 door Michael Mann, de bekende hockeystickgrafiek. Tel daar nog eens bij de als vaststaand feit verkochte hypothese dat atmosferisch CO2 de temperatuur op aarde stuurt, en het beeld dat de globale temperatuurstijging sinds 1880 van ~ 0,7 °C vrijwel zeker antropogeen van oorsprong moest zijn was een feit.

In bovenstaande grafiek is te zien dat de temperatuurstijging sinds 1880 onderdeel is van een cyclische schommeling. Deze zogenaamde De Vries-cyclus heeft een periodiciteit van ongeveer 200 jaar en wordt aangedreven door de zon.

Bron: Malberg

Bron: Malberg

In de figuur hierboven zien we de temperatuuranomalieën in Midden Europa per periode van 3 Schwabe-cycli. Opvallend is dat het verloop van deze grafiek sterk lijkt op die van de eerste grafiek. Zonneactiviteit is ontegenzeggelijk een belangrijk sturende factor in het temperatuurverloop.

Malberg heeft de correlatiecoëfficiënt berekend tussen die zonneactiviteit en het temperatuurverloop in diverse gebieden (zie de grafiek hieronder).

Bron: Malberg

Bron: Malberg

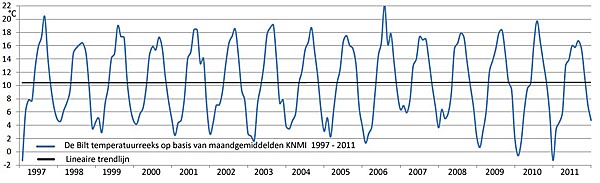

In de grafiek is de correlatie weergegeven voor Midden Europa en centraal Engeland, en vanaf 1857 ook voor het NH, ZH en de aarde als geheel. Voor de periode 1857-1996 kan volgens Malberg de zon voor ongeveer 80% de langetermijn temperatuurveranderingen verklaren. Opvallend is dat de correlatie zonneactiviteit – temperatuur daalt bij beschouwing van kortere periodes, zoals die met de duur van een zonnecyclus. Dat is het geval vanaf 1996, als ook de laatste cyclus, nummer 23, meegerekend wordt. Daarom heeft Malberg aandacht besteed aan de periode 1991-2010 om meer zicht te krijgen op de vraag welke factoren van invloed zijn op kortstondige periodes met een lengte van een zonnecyclus. In onderstaande grafiek is het verloop van de globale temperatuur weergegeven, bron HadCrut. De kortstondige temperatuurverandering in deze periode zijn vrijwel alle terug te voeren tot de invloed van El Niño (ENSO) en La Niña, de grootschalige veranderingen in het stromingspatroon van de tropische Pacific.

Bron: HadCrut

Bron: HadCrut

Een El Niño fase verwarmt de aarde, La Niña daarentegen koelt de aarde af. Deze fases hebben een relatief kortstondige uitwerking op de globale temperatuur. Maar er is ook een langere periodiciteit te ontdekken in de invloed van beide verschijnselen. In onderstaande grafiek is de zogenaamde aandrijffactor F = Tm*Mon weergegeven, waarbij men per decennium de totale invloed van El Niño en La Niña berekent. Deze warmtebalans is positief als El Niño overheerst, en negatief als La Niña overheerst.

Bron: NOAA

Bron: NOAA

Opvallend is dat in de jaren’50 de balans negatief was, en in de decennia daarna (met uitzondering van de jaren ’70 , positief. Vooral in het laatste decennium is de invloed van Pacifische cyclus groot geweest.

Bron: Malberg

Bron: Malberg

Bovenstaande grafiek geeft de correlatie weer tussen de jaarlijkse globale gemiddelde temperatuur en die van de tropische Pacific voor diverse periodes. Opvallend is dat de correlatie om en nabij de + 0,8 is voor het afgelopen decennium. Malberg merkt op dat El Niño/La Niña op twee manieren het klimaat beïnvloed, namelijk op een decenniale schaal en een intra-annuele schaal. Met name het afgelopen decennium is de invloed op de globale temperatuur groter dan in de voorafgaande decennia, terwijl de kortstondige pieken en dalen in de temperatuurreeks de tweede invloed vormen. Volgens Malberg compenseert de toegenomen invloed van El Niño/La Niña op decenniale schaal de teruglopende zonne-activiteit van de afgelopen 50 jaar.

Wat biedt de toekomst? Net zoals prof. De Jager denkt ook Malberg dat de kans groot is dat we aan de vooravond van een afkoeling staan. Van cruciaal belang volgens Malberg is de vraag wat cyclus 24 gaat doen. Als het gemiddelde zonnevlekkenaantal onder de 50 blijft verwacht hij een langere periode van afkoeling. En in die verwachting staan Malberg en De Jager niet alleen. Over CO2 als drijvende kracht achter de temperatuur is de professor kort: “Der anthropogene CO2-Effekt kommt als Ursache des aktuellen Temperaturverhaltens nicht in Betracht. Wäre er dominant, müsste sich die globale Temperatur seit1998 auf Grund des exponentiellen CO2-Anstiegs stark erhöht haben. Eine konstante globale Temperatur ist durch einen angeblich dominierenden CO2-Effekt physikalisch ebenso wenig zu erklären, wie es globale Abkühlungen sind.”

Prof. De Jager krijgt gelijk

Alle tekenen wijzen erop dat Cees de Jager gelijk krijgt: de zonnevlekkencyclus van 11 jaar dooft langzaam uit. Op een bijeenkomst van de American Astronomical Society afgelopen week gonsde het al van de geruchten over de toenemende hoeveelheid aanwijzingen dat er werkelijk wat aan de hand is met de zonnecycli. Zie ook “Nieuwe Inzichten” onder “Zonnecycli”.

Cyclus 24 is enkele jaren te laat op gang gekomen. Zoals op bovenstaande illustratie te zien is is hij veel zwakker dan de voorafgaande cyclus 23. Cyclus 24 zal naar verwachting zijn maximum hebben in 2013, en cyclus 25 in 2024. Maar alle tekenen wijzen erop dat cyclus 24 of zeer zwak wordt dan wel weg blijft.

Een van die aanwijzingen is het wegblijven van de zogenaamde jet streams. Dat zijn stromingen op een diepte van 7000 km onder het zonne-oppervlak, waarboven de zonnevlekken zich manifesteren. Die jet streams onstaan altijd op hoge breedte (ongeveer 50° NB en ZB) en zakken dan langzaam af naar de zonne-equator. Het ontstaan van dergelijke jet streams vindt al plaats ruim voordat de voorgaande cyclus is uitgedoofd.

Bron: Sky & Telescope

Wetenschappers die zich bezighouden met helioseismologie, zoals Frank Hill en Jay Pasachoff, nemen waar dat het ontstaan van de jet streams voor cyclus 25 uitblijft. De cyclus is al enkele jaren over tijd, om preciezer te zijn. Op onderstaande afbeelding is dat te zien. De jet streams zijn de rood-gele strepen op de figuur. Aan de linkerzijde ziet men de jet streams van cyclus 23, die omstreeks 2002 de zonne-evenaar bereiken. Verder is te zien dat de jet streams van de huidige cyclus 24 al in 1997 verschijnen op 50° NB en ZB, en dat ze de evenaar zullen bereiken in 2013. Het ontstaan van de volgende jet streams van cyclus 25 zou normaal gesproken al in 2009 hebben moeten plaats vinden, maar er is tot nu toe nog helemaal niets te zien.

Een tweede aanwijzing dat er iets bijzonders aan de hand is, is dat de sterkte van het magnetisch veld in het donkere hart van zonnevlekken alsmaar zwakker wordt. Zodra die sterkte beneden de 1500 Gauss daalt zullen er geen zonnevlekken meer ontstaan.

Bron: National Solar Observatory

Bron: National Solar Observatory

De parallel met het ontstaan van het Maunder Minimum rond 1620 ligt voor de hand. Ook toen was er sprake van een afzwakkende zonnecyclcus, die er voor zorgde dat zonnevlekken ongeveer 100 jaar weg bleven. Het gevolg was een afkoeling van de temperaturen op aarde, die bekend staat als de Kleine IJstijd.

Prof. De Jager heeft allemaal al enkele jaren geleden voorspeld, in een publicatie samen met de Argentijn Duhau. Hij noemt de komende koele periode het nieuwe Grote Minimum, dat volgens hem zal duren tot ongeveer 2100. Zie de website van de Jager.

De zon heeft het alweer gedaan

Qian en Lu, twee Chinese klimaatonderzoekers, hebben onlangs gepubliceerd over de periodieke oscillaties die in het aards temperatuurverloop van de afgelopen 1000 jaar waarneembaar zijn.

Daarvoor combineren ze de gereconstrueerde temperatuurreeks van Mann uit 2008 met de meetgegevens van HadCRUT3 (bovenste grafiek). Duidelijk zijn het Middeleeuws Optimum , de Kleine IJstijd en de recente opwarming te herkennen. Na verwijdering van deze langdurige trend blijft het ‘kale’ signaal over ( tweede grafiek). Na analyse van het overgebleven signaal is een viertal oscillaties te herkennen met een periodiciteit van 21,1 , 62,5 , 116 en 194,9 jaar (onderstaande grafiek).

Combineert je bovenstaande 4 oscillaties tot 1 temperatuursignaal (onderbroken lijn) en leg je die dan op het (trend removed ) originele signaal, dan is een opvallende correlatie te zien met een correlatiecoëfficiënt van 0,5 !

De onderzoekers gingen vervolgens op zoek naar mogelijke verklaringen voor bovenstaande oscillaties en vonden een tweetal verklarende mechanismen. De eerste is de zon. Daarvoor bekeken Qian en Lu de afgelopen 400 jaar. De reconstructie van zonneactiviteit werd gedaan op basis van 10Be meetgegevens. Analyse van die gegevens levereden een tweetal oscillaties in het signaal van de zon, met een periodiciteit van 118 en 175 jaar. Zet je de resultante van beide sinusoscillaties af tegen het gemeten signaal van zonneactiviteit dan ontstaat het volgende beeld:

Opvallend noemen de onderzoekers de correlatie in de ze 400-jarige periode tussen de oscillatie van 118 jaar (zon) en de temperatuuroscillatie van 111 jaar in genoemde periode. De time lag tussen beide signalen wijst volgens de onderzoekers op een vertraagde reactie van de aardse temperatuur op de veranderende zonneactiviteit.

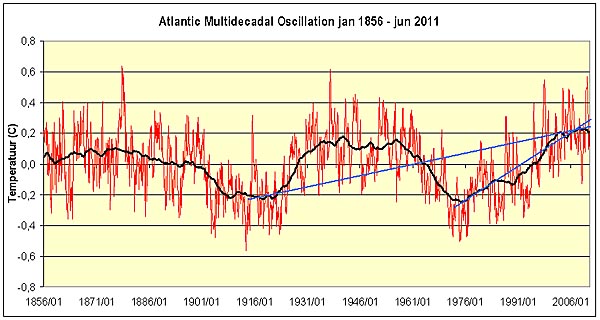

Voor veranderingen op decadale tijdschaal bekijken Qial en Lu de periode 1850-2000. Bij analyse van deze relatief korte periode onderscheiden ze een tweetal oscillaties in de temperatuurreeks van 21,12 en 64,8 jaar, en een drietal oscillaties in het signaal van de zon van 10, 22 en 43,3 jaar. In onderstaande grafiek is de sterke correlatie te zien tussen de resultante van beide zonneoscillaties (onderbroken lijn) en de temperatuur.

Ook de koppeling oceaan-klimaat werd door de Chinese onderzoekers bekeken. De ook door andere onderzoekers al gesignaleerde oscillatie in de aardse temperatuur van ongeveer 65 jaar  werd vergeleken met de oscillatie in de PDO-index van ongeveer 62 jaar (PDO= Pacific Decadal Oscillation). Uitkomst: de SST loopt ongeveer 2 tot 6 jaar voor op de wereldtemperatuur.

werd vergeleken met de oscillatie in de PDO-index van ongeveer 62 jaar (PDO= Pacific Decadal Oscillation). Uitkomst: de SST loopt ongeveer 2 tot 6 jaar voor op de wereldtemperatuur.

Opvallende uitkomsten van het onderzoek:

– De invloed van de zon op het temperatuurverloop op aarde is groot.

– De opwarming aan het einde van de vorige eeuw was vooral het gevolg van een samenvallen van de 4 temperatuuroscillaties. Tussen 1994 en 2002 vielen voor het eerst in 1000 jaar de toppen van genoemde 4 oscillaties samen.

– Op basis van de analyse van de dataset van de afgelopen 1000 jaar voorspellen de onderzoekers een afkoeling van de wereldtemperatuur rond 2030 en een opwarming rond 2060.

Spitsbergen gaat afkoelen

Een interessant onderzoek van een drietal Noorse onderzoekers getiteld “Solar activity and Svalbard temperatures” zal over enkele maanden worden gepubliceerd. Solheim et al hebben een verband ontdekt tussen zonneactiviteit en de luchttemperatuur op Spitsbergen. Nu is dat laatste niet erg opzienbarend, dergelijke verbanden zijn al vele malen aangetoond. Zie hiervoor in het menu “Nieuwe Inzichten” de paragraaf over zonnecycli.

Wat wel opvallend in de studie is dat de onderzoekers een verband hebben ontdekt tussen de duur van de cycli gedurende de afgelopen eeuw en de oppervlaktetemperatuur op Spitsbergen, en dan met name de gemiddelde jaartemperatuur en wintertemperatuur. Die correlatie wordt sterker naarmate de time-lag groter is, zoals op bovenstaande figuur te zien is. Bij een time-lag van 10 tot 12 jaar is de correlatie maximaal, met een correlatiecoëfficiënt oplopend tot -0,8. Dat betekent dat, rekening houdend met een gemiddelde zonnecyclusperiodiciteit van 11 jaar, er een sterke correlatie is tussen de gemiddelde luchttemperatuur op Spitsbergen en de duur van de vorige zonnecyclus. De correlatie is significant, met een niveau van > 95%. Dat betekent dat de kans dat de geobserveerde waarden gevonden worden terwijl er geen verband tussen de variabelen bestaat, kleiner dan 5% is. Ongeveer 60% van de temperatuurvariatie in de gemiddelde jaartemperatuur en wintertemperatuur kan verklaard worden door zonnecycli.

De onderzoekers hebben enkele mogelijke verklaringen gevonden voor de time-lag tussen zonnecyclus en temperatuur. In de eerste plaats is de duur van een zonnecyclus gecorreleerd aan de amplitude van de volgende cyclus. Dat vonden Solanski en Krivova van het Max Planck Instituut ook al bij hun onderzoek dat in 2003 is gepubliceerd. Een tweede verklaring is te vinden in de time-lag die ontstaat vanwege het langdurende transport van oceaanwater vanuit de Cariben naar het noordelijk deel van de Atlantische Oceaan.

Cyclus 24 is enkele jaren te laat op gang gekomen. Zoals op bovenstaande illustratie te zien is is hij veel zwakker dan de voorafgaande cyclus 23. Hij zal naar verwachting zijn maximum hebben in 2013, cyclus 25 in 2024.

Een van de aanwijzingen voor een zwakke cyclus 24 is het wegblijven van de zogenaamde jet streams. Dat zijn stromingen op een diepte van 7000 km onder het zonne-oppervlak, waarboven de zonnevlekken zich manifesteren. Die jet streams onstaan altijd op hoge breedte (ongeveer 50° NB en ZB) en zakken dan langzaam af naar de zonne-equator. Het ontstaan van dergelijke jet streams vindt al plaats ruim voordat de voorgaande cyclus is uitgedoofd.

Wetenschappers die zich bezighouden met helioseismologie, zoals Frank Hill en Jay Pasachoff, nemen waar dat het ontstaan van de jet streams voor cyclus 25 uitblijft. De cyclus is al enkele jaren over tijd, om preciezer te zijn. Op onderstaande afbeelding is dat te zien. De jet streams zijn de rood-gele strepen op de figuur. Aan de linkerzijde ziet men de jet streams van cyclus 23, die omstreeks 2002 de zonne-evenaar bereiken. Verder is te zien dat de jet streams van de huidige cyclus 24 al in 1997 verschijnen op 50° NB en ZB, en dat ze de evenaar zullen bereiken in 2013. Het ontstaan van de volgende jet streams van cyclus 25 zou normaal gesproken al in 2009 hebben moeten plaats vinden, maar er is tot nu toe nog helemaal niets te zien.

Een tweede aanwijzing dat er iets bijzonders aan de hand is, is dat de sterkte van het magnetisch veld in het donkere hart van zonnevlekken alsmaar zwakker wordt. Zodra die sterkte beneden de 1500 Gauss daalt zullen er geen zonnevlekken meer ontstaan.

Bron: National Solar Observatory

Met het PSCL-model dat door de Noorse onderzoekers op basis van de correlatie zonnecyclus-temperatuur is gemaakt kunnen ook voorspellingen worden gedaan. Nu hou ik persoonlijk niet zo van modellen die dit of dat voorspellen, omdat op die wijze door wat ik het politiek-industrieel- klimatologisch complex noem de laatste jaren nogal wat onzin naar buiten is gebracht. Maar deze wil ik u niet onthouden, temeer omdat de genoemde correlatie statistisch significant is. De voorspelling is dat voor de huidige zonnecyclus, die tot 2020 zal voortduren, de gemiddelde jaartemperatuur op Spitsbergen met ongeveer 3 °C zal dalen, en de gemiddelde wintertemperatuur met zelfs 6 °C. Ik ben benieuwd of de voorspelde afkoeling waargemaakt gaat worden, en ook geldt voor de andere delen van het Arctisch gebied.

Een tijdje terug publiceerde Russ Steele op zijn weblog onderstaande grafiek van de hand van meteoroloog Joe Bastardi. Men ziet voor de periode 1979 tot heden het verloop van het CO2-gehalte in de atmosfeer zoals gemeten op Mauna Loa Observatory op Hawaii, de globale zee-en landtemperatuur volgens de datareeks HadCRUT3, en de SST (sea surface temperature) volgens de datareeks HadSST2.

Russ vraagt zich af: “ If the admission to the school of your choice, be it Cornell, or lets say Columbia or Harvard, depended on you answering this question — “Given the facts presented in the chart below, is CO2 driving the Earth’s temperature?” — how would you answer it? ”

En bezie nu eens de figuur over de inkomende zonnestraling en de maximum dagtemperaturen in de USA. De figuur is afkomstig van een onderzoek door Willie Soon and William M. Briggs, waarvan de resultaten gisteren werden gepresenteerd in de Washington Times.

Bron: BEST project University of California

Het toont een sterke correlatie tussen inkomende zonnestraling en de oppervlaktetemperatuur in de USA. Tot nu toe werden bij dergelijke onderzoeken ook altijd de nachttemperaturen meegenomen, wat natuurlijk verwonderlijk is omdat de zon dan niet schijnt. De variatie in inkomende zonnestraling (in W/m2) is erg klein, maar de maximum dagtemperatuur in vooral wolkenloze regio’s volgt die opvallend goed.

Soon: “Pictures like these cannot be drawn for temperature and CO2 concentration. There just is no such close match between the steady rise in atmospheric CO2 concentration and the often dramatic ups and downs of surface temperatures in and around the Arctic, China and the United States.” Waarvan acte zou ik zeggen (zie eerste figuur).

Soon en Briggs hebben al eerder een dergelijke sterke correlatie tussen zonnestraling en maximum temperaturen waargenomen in diverse andere regio’s op aarde. Zo vonden ze een dergelijke correlatie ook bij hun onderzoeken in het Arctische gebied en China. Ook de onderzoekers Van Loon en Meehl hebben in een aantal recente publicaties (hier en hier) deze zonnestraling-oppervlaktetemperatuur-hypothese wetenschappelijk op de kaart gezet.

De verklaring voor de sterke relatie tussen zonnestraling en temperatuur is volgens Soon en Briggs te vinden in de conveyor belt, de grote thermohaline circulatie die grote massa’s water verplaatst in de oceaanbekkens. Hierbij is vooral de uitwisseling tussen Arctische Zee en tropen van belang.

Bron: Wikipedia

Soon verklaart: “…we were able to provide a self-consistent explanation for these observed apparent sun-climate correlations, which involves the exchange of heat and moisture between the equator and the Arctic region. In addition, we recently discovered direct evidence that changes in solar activity have influenced what has been called the “conveyor belt” circulation of the great Atlantic Ocean currents over the past 240 years. For instance, solar-driven changes in temperature and in the volume of freshwater output from the Arctic cause variations in sea surface temperature in the tropical Atlantic five to 20 years later. These peer-reviewed results, appearing in several science journals, make it difficult to maintain that changes in solar activity play no or an insignificant role in climate change. ”.

Bas van Geel en de rol van de zon

Op de klimaatconferentie van 8 december 2012 in Rijsoord hield paleo-ecoloog Bas van Geel van de UvA een voordracht over de onderschatte rol van de zon op het aardse klimaat. Hij hekelde de houding van het IPCC die de rol van CO2 op het aardse klimaat overschat en die van de zon onderschat. Op onderstaande figuur uit het IPCC-rapport van 2007 is dat goed te zien:

De blauwe band toont het temperatuurverloop volgens de door het IPCC gebruikte klimaatmodellen in de diverse regio’s als er geen ‘CO2-effect’ is. Het ziet er allemaal erg dramatisch uit, reden waarom deze figuur graag gebruikt wordt om de rol van de mens op het klimaat te benadrukken. Dat deed Rob van Dorland van het KNMI in zijn lezing.

Van Geel toont in zijn voordracht aan dat hier sprake is van onderschatting van de rol van de zon. Dat de zon in de ogen van het IPCC een ondergeschikte rol speelt is goed te zien op onderstaande figuur. De totale antropogene radiative forcing wordt door het IPCC 15x groter ingeschat dan die van de zon.

De activiteit van de zon is onder andere herkenbaar aan het aantal zonnevlekken aan het oppervlak. Bekend is dat het aantal zonnevlekken een zekere variatie in de tijd kent. In het menu onder “Nieuwe Inzichten” is in de hoofdstukken ‘De Zon’ en ‘Zonnecycli’ daarover al het een en ander geschreven.

Op de figuur is te zien dat vooral in de vorige eeuw de activiteit van de zon sterk is toegenomen. Van Dorland beweerde in een reactie dat na 1958 (de piek in de grafiek) de activiteit weer afgenomen is en dat invloed op de temperatuur meer gerelateerd is aan de toename van de activiteit dan aan de grootte ervan. Door Van Geel werd dat ontkend en ikzelf heb ook in de literatuur geen aanwijzing kunnen vinden dat Van Dorlands opmerking juist zou zijn.

Bron: Damon et al, 1998

Behalve waarnemingen van het aantal zonnevlekken worden ook kosmogene isotopen in natuurlijke archieven gebruikt om de veranderingen in de activiteit van de zon te meten. In planten wordt 14C gevonden, in ijskernen 10Be. In bovenstaande grafiek is te zien dat 14C en 10Be isotopen prachtig de periodische en aperiodische variaties van de zonneactiviteit volgen. In de grafiek zijn de waarden van 14C EN 10Be omgekeerd evenredig met de zonneactiviteit.

Vele voorbeelden laten volgens Van Geel zien dat het klimaat hypergevoelig is voor relatief kleine veranderingen in de activiteit van de zon. Die hypergevoeligheid alleen verklaard worden met versterkingsmechanismen. Op bovenstaande figuur is te zien dat in stalagmieten in Oman de correlatie tussen het 14C isotoop en de temperatuur zeer opvallend is. Het zuurstofisotoop 18O in neerslag wordt in de paleoklimatologie gebruikt om de temperatuur van neerslagwater vast te stellen.

Ook de opmerking van Van Dorland als zouden onderzoeksresultaten alleen regionaal correlaties vertonen lijkt geen hout te snijden: in een publicatie van Stuyver et al uit 1998 wordt een opmerkelijke synchrone correlatie gevonden in 14C gehalten tussen 1550 en 1750 op 3 continenten:

Bovenstaande data komen uit een studie van Bond c.s. uit 2001, gepubliceerd in Science. Bond en zijn team onderzochten de afzettingen die door ijsbergen op de bodem van het noordelijk deel van de Atlantische Oceaan zijn afgezet vanaf het einde van de laatste ijstijd tot nu toe. Behalve dat in koude periodes de sedimenten veel verder van de landijsmassa’s werden afgezet , varieert ook de dikte van de sedimenten behoorlijk). In de grafiek is te zien dat er een nauwe correlatie is tussen 10Be en het voorkomen van dat zogenaamde ‘ice-rafted debris’. Zie ook verdere informatie over deze studie onder ‘Niwue Inzichten’.

De data uit de publicatie van Bond et al zijn ook gebruikt door Magny in 2007, waarin hij een verband aantoont met de waterstanden in Alpenmeren in Laat-Pleistoceen en Holoceen.

Er zijn nog vele andere onderzoeksresultaten die aantonen dat zonne-activiteit van grote invloed is op het aardse klimaat. Zo is er de publicatie van Sejrup uit 2010 over de respons van de temperatuur van de Noorse Zee sinds 1000 jaar…

……het eigen onderzoek van Van Geel aan veenafzettingen……

… die weer goed corresponderen met de meerafzettingen in het Meerfelder Maar, een restant van en oude caldera in de Eiffel. Alhoewel de fluctuaties van de totale zonnestraling gedurende het Holoceen relatief klein zijn geweest lijken de gevolgen toch groot. Onderstaande grafiek is van de publicatie van Steinhilber et al uit 2009.

Als we inzoomen op de ontwikkeling van de globale temperatuur van de afgelopen eeuw dan zien we een bekende dip in de temperatuur tussen 1940 en 1975. Menig wetenschapper wil ons graag doen geloven dat die het gevolg is van luchtvervuiling die inkomende zonnestraling hindert. Als je de totale zonnestraling aan buitenzijde van de atmosfeer (Hoyt + Schatten, 1997) vergelijkt met de temperatuur ontstaat een ander beeld:

Zonnecyclus 24 blijft lager dan enkele jaren geleden voorspeld, hetgeen een voorbode kan zijn voor een koelere periode in het wereldklimaat. Van Geel noemde dit het grootste experiment dat momenteel gaande is.

De globale temperatuur op aarde stijgt al meer dan een decennium niet meer. Niemand weet welke kant hij opgaat, maar als de invloed van de zon groter is dan die van CO2 is de mogelijkheid van afkoeling groot.

Toen enkele jaren geleden de opwarming van de aarde niet meer vol te houden was door klimaatalarmisten heeft men stilletjes het begrip klimaatopwarming vervangen door klimaatverandering. Een pleonasme lijkt me. Als blijkt dat afkoeling ons deel wordt (wat ik niet hoop) dan staat ons een nieuwe strategie van de klimaatalarmisten te wachten:

Bron: Antarctic Ozone Bulletin

Bron: Antarctic Ozone Bulletin Bron: Bescherming ozonlaag: 20 jaar effectief beleid – een welkome waarheid

Bron: Bescherming ozonlaag: 20 jaar effectief beleid – een welkome waarheid Bron: Antarctic Ozone Bulletin

Bron: Antarctic Ozone Bulletin Bron: Antarctic Ozone Bulletin

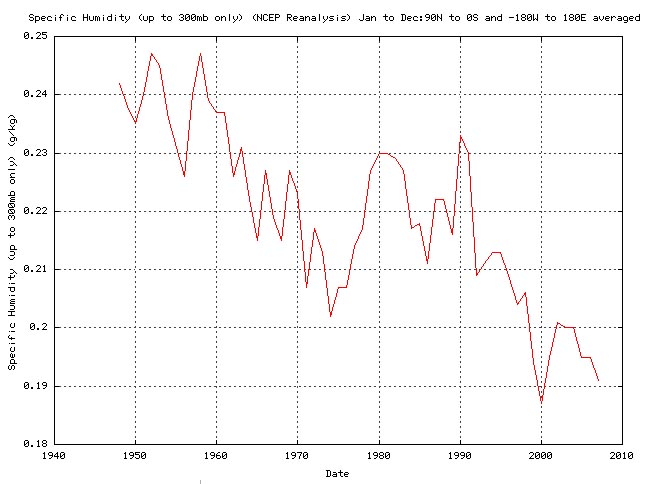

Bron: Antarctic Ozone Bulletin