Met Office in Groot Brittannië geeft toe dat de globale temperatuur al 15 jaar lang niet meer gestegen is, en dat we zelfs toe lijken te gaan naar een koelere periode als gevolg van afnemende zonne-activiteit. Voor de lezers van deze site geen nieuws, voor het grote publiek wel. Hieronder het bericht uit de Mail Online :

Forget global warming – it’s Cycle 25 we need to worry about (and if NASA scientists are right the Thames will be freezing over again)

• Met Office releases new figures which show no warming in 15 years

By David Rose

The supposed ‘consensus’ on man-made global warming is facing an inconvenient challenge after the release of new temperature data showing the planet has not warmed for the past 15 years. The figures suggest that we could even be heading for a mini ice age to rival the 70-year temperature drop that saw frost fairs held on the Thames in the 17th Century.

Based on readings from more than 30,000 measuring stations, the data was issued last week without fanfare by the Met Office and the University of East Anglia Climatic Research Unit. It confirms that the rising trend in world temperatures ended in 1997.

A painting, dated 1684, by Abraham Hondius depicts one of many frost fairs on the River Thames during the mini ice age

Meanwhile, leading climate scientists yesterday told The Mail on Sunday that, after emitting unusually high levels of energy throughout the 20th Century, the sun is now heading towards a ‘grand minimum’ in its output, threatening cold summers, bitter winters and a shortening of the season available for growing food.

Solar output goes through 11-year cycles, with high numbers of sunspots seen at their peak. We are now at what should be the peak of what scientists call ‘Cycle 24’ – which is why last week’s solar storm resulted in sightings of the aurora borealis further south than usual. But sunspot numbers are running at less than half those seen during cycle peaks in the 20th Century. Analysis by experts at NASA and the University of Arizona – derived from magnetic-field measurements 120,000 miles beneath the sun’s surface – suggest that Cycle 25, whose peak is due in 2022, will be a great deal weaker still.

According to a paper issued last week by the Met Office, there is a 92 per cent chance that both Cycle 25 and those taking place in the following decades will be as weak as, or weaker than, the ‘Dalton minimum’ of 1790 to 1830. In this period, named after the meteorologist John Dalton, average temperatures in parts of Europe fell by 2C. However, it is also possible that the new solar energy slump could be as deep as the ‘Maunder minimum’ (after astronomer Edward Maunder), between 1645 and 1715 in the coldest part of the ‘Little Ice Age’ when, as well as the Thames frost fairs, the canals of Holland froze solid.

Yet, in its paper, the Met Office claimed that the consequences now would be negligible – because the impact of the sun on climate is far less than man-made carbon dioxide. Although the sun’s output is likely to decrease until 2100, ‘ This would only cause a reduction in global temperatures of 0.08C.’ Peter Stott, one of the authors, said: ‘Our findings suggest a reduction of solar activity to levels not seen in hundreds of years would be insufficient to offset the dominant influence of greenhouse gases.’

These findings are fiercely disputed by other solar experts. ‘ World temperatures may end up a lot cooler than now for 50 years or more,’ said Henrik Svensmark, director of the Center for Sun-Climate Research at Denmark’s National Space Institute. ‘ It will take a long battle to convince some climate scientists that the sun is important. It may well be that the sun is going to demonstrate this on its own, without the need for their help.’

He pointed out that, in claiming the effect of the solar minimum would be small, the Met Office was relying on the same computer models that are being undermined by the current pause in global-warming.

CO2 levels have continued to rise without interruption and, in 2007, the Met Office claimed that global warming was about to ‘come roaring back’. It said that between 2004 and 2014 there would be an overall increase of 0.3C. In 2009, it predicted that at least three of the years 2009 to 2014 would break the previous temperature record set in 1998.

So far there is no sign of any of this happening. But yesterday a Met Office spokesman insisted its models were still valid. ‘ The ten-year projection remains groundbreaking science. The period for the original projection is not over yet,’ he said. Dr Nicola Scafetta, of Duke University in North Carolina, is the author of several papers that argue the Met Office climate models show there should have been ‘steady warming from 2000 until now’. ‘ If temperatures continue to stay flat or start to cool again, the divergence between the models and recorded data will eventually become so great that the whole scientific community will question the current theories,’ he said.

He believes that as the Met Office model attaches much greater significance to CO2 than to the sun, it was bound to conclude that there would not be cooling. ‘ The real issue is whether the model itself is accurate,’ Dr Scafetta said. Meanwhile, one of America’s most eminent climate experts, Professor Judith Curry of the Georgia Institute of Technology, said she found the Met Office’s confident prediction of a ‘negligible’ impact difficult to understand.

‘ The responsible thing to do would be to accept the fact that the models may have severe shortcomings when it comes to the influence of the sun,’ said Professor Curry. As for the warming pause, she said that many scientists ‘are not surprised’.

She argued it is becoming evident that factors other than CO2 play an important role in rising or falling warmth, such as the 60-year water temperature cycles in the Pacific and Atlantic oceans. ‘ They have insufficiently been appreciated in terms of global climate,’ said Prof Curry. When both oceans were cold in the past, such as from 1940 to 1970, the climate cooled. The Pacific cycle ‘flipped’ back from warm to cold mode in 2008 and the Atlantic is also thought likely to flip in the next few years .

Pal Brekke, senior adviser at the Norwegian Space Centre, said some scientists found the importance of water cycles difficult to accept, because doing so means admitting that the oceans – not CO2 – caused much of the global warming between 1970 and 1997. The same goes for the impact of the sun – which was highly active for much of the 20th Century. ‘ Nature is about to carry out a very interesting experiment,’ he said. ‘ Ten or 15 years from now, we will be able to determine much better whether the warming of the late 20th Century really was caused by man-made CO2, or by natural variability.’ Meanwhile, since the end of last year, world temperatures have fallen by more than half a degree, as the cold ‘La Nina’ effect has re-emerged in the South Pacific.

‘ We’re now well into the second decade of the pause,’ said Benny Peiser, director of the Global Warming Policy Foundation. ‘ If we don’t see convincing evidence of global warming by 2015, it will start to become clear whether the models are bunk. And, if they are, the implications for some scientists could be very serious.’

Read more here.

Globale temperatuur afgelopen 15 jaar.

In de paragraaf over De Bilt toonde ik het verloop van de gemiddelde maandelijkse temperatuur in De Bilt gedurende de afgelopen 15 jaar. Er is in die periode geen sprake van opwarming. Alarmisten hebben er een handje van om deze informatie te negeren en liever gewag te maken van een of andere record dat gebroken dan wel bijna gebroken is. In een min of meer vlak verlopende temperatuurtrend zoals die van de afgelopen 15 jaar is elk piekje naar boven natuurlijk al snel een ‘record’.

Een ongepland ‘voordeel’ van de periode 1997-2011 is dat het super-El Niñojaar 1998 in de reeks zit. Zou de reeks begonnen zijn op het hoogtepunt van genoemde El Niño dan zou ik al gauw beschuldigd worden van cherry-picking. Maar is het bekijken van slechts 1 meetstation ook niet een vorm van cherry-picking? Natuurlijk wel als je daarmee algemene opmerkingen over bijvoorbeeld het verloop van de globale temperatuur zou maken, dat mag uiteraard niet.

Nieuwsgierig geworden naar het globale verloop sinds 1997 ging ik op zoek in de onvolprezen KNMI Climate Explorer. Bovenstaande grafiek geeft het verloop weer van die globale temperatuur sinds 1997 volgens HadCRUTv3 (anomalie). De zwarte lijn is de lineaire trendlijn voor de gegeven periode januari 1997 – oktober 2011. Die trendlijn stijgt in 15 jaar 0,02 °C, een te verwaarlozen afwijking.

Omdat 71% van het aardoppervlak uit water bestaat is de zogenaamde SST , sea surface temperature, van groot belang voor de temperatuur van de onderste troposfeer. Bob Tisdale houdt al sinds jaar en dag de SST bij.

Zoals te zien is lijkt de SST erg veel op de temperatuurreeks van HadCRUTv3. In beide reeksen zijn de El Niño en La Niñafasen erg duidelijk te herkennen.

Conclusie: er is de afgelopen 15 jaar sprake van een steady state voor wat betreft de temperatuur aan het aardoppervlak. Als we de meest recente grafiek van Roy Spencer erbij halen zien we die afvlakking ook mooi. Het betreft de temperatuur in de onderste troposfeer, op basis van satellietmetingen en bewerkt door de Universiteit van Alabama Huntsville.

Spencer wijst er overigens op dat de door hem ingevoerde ‘trendlijn’ niet mag worden gebruikt om te voorspellen wat de temperatuur de komende jaren gaat doen.

Hoe heeft de gemiddelde temperatuur op aarde zich het afgelopen decennium ontwikkeld?

Een interessante vraag, zeker gezien de alarmerende voorspellingen van het IPCC enkele jaren geleden. Op 28 december 2010 heb ik het volgende statement uit een persbericht van MeteoVista/weeronline.nl aan de orde gesteld: “Nederland warmt ongeveer twee keer zo snel op als het mondiale gemiddelde. Het is in 10 jaar tijd gemiddeld 0,42 graden warmer geworden.”

Trouwe lezers hebben toen met eigen ogen kunnen aanschouwen dat van die vermeende 0,42 °C opwarming van ons land in het afgelopen decennium helemaal niets overbleef. De Bilt vertoont zelfs al 14 jaar lang geen opwarming meer. Een schokkend amateuristische interpretatie van klimaatgegevens door 2 medewerkers van MeteoVista was de oorzaak. Maar hoe zit het nu met de opwarming van de aarde als geheel? Volgens diezelfde onderzoekers is de aarde tussen 1 januari 2001 en 31 december 2010 ongeveer 0,2 °C opgewarmd. Klopt dat? Nu alle grote klimaatorganisaties die zich bezighouden met het berekenen van de globale temperatuur hun rekenwerk gedaan hebben kunnen we de resultaten bekijken:

Bron: GISS NASA base period: 1951-1980 temp.tendens: + 0,152 °C

Bron: GISS NASA base period: 1951-1980 temp.tendens: + 0,152 °C Bron: NCDC NOAA base period: 1901-2000 temp.tendens: + 0,013 °C

Bron: NCDC NOAA base period: 1901-2000 temp.tendens: + 0,013 °C

Bron: HadCRUT3v base period: 1961-1990 temp.tendens: – 0,052 °C

Bron: HadCRUT3v base period: 1961-1990 temp.tendens: – 0,052 °C  Bron: RSS MSU base period: 1979-1998 temp.tendens: + 0,032 °C

Bron: RSS MSU base period: 1979-1998 temp.tendens: + 0,032 °C

Bron: UAH base period: 1981-2010 temp.tendens: + 0,089 °C

Bron: UAH base period: 1981-2010 temp.tendens: + 0,089 °C

In alle grafieken gaat het niet om absolute temperaturen, maar om anomalieën, afwijkingen in °C ten opzichte van een bepaalde referentieperiode. Die betreffende periode is onder elke grafiek aangegeven als “base period”. De blauwe lijn geeft het verloop van de maandgemiddelden weer in de periode 1 januari 2001 t/m 31 december 2010. De zwarte lijn is de zogenaamde lineaire trendlijn, de lijn die aangeeft in welke mate de temperatuur in de aangegeven periode van 10 jaar is veranderd, dus wat de temperatuurtendens is in dit decennium.

Wat direct opvalt is dat er geen enkele grafiek de 0,2 °C stijging haalt die MeteoVista gebruikt in haar persbericht. Zelfs GISS NASA, die van de betrokken organisaties veruit de sterkste opwarming vertoont, haalt net een stijging van 0,15 °C. De andere organisaties halen waarden die net boven 0 zitten, HadCRUT berekent zelfs een hele lichte afkoeling het afgelopen decennium. Kortom: de afwezigheid van enige opwarming in Nederland wijkt nauwelijks af van wat de meeste van de organisaties voor de wereldtemperatuur hebben berekend.

De eerste 3 grafieken zijn gebaseerd op thermometermetingen, de laatste 2 op satellietgegevens. Hoe zijn nu de verschillen tussen de diverse grafieken te verklaren? Allereerst omdat de referentieperiodes van de orgasnisaties onderling verschillen. Maar er zijn nog meer factoren. Om met de satellietgegevens te beginnen: Zowel RSS als UAH maken gebruik van dezelfde data van dezelfde satelliet. Een gemiddelde wereldtemperatuur per tijdseenheid levert zo’n satelliet echter niet, die moet berekend worden uit een enorme hoeveelheid cijfers. En die wijze van berekenen verschilt tussen beide organisaties, en daarmee ook de uitkomsten van de temperatuurreeksen.

Voor wat betreft de eerste 3 grafieken, die gebaseerd zijn op thermometermetingen, ontstaan merkwaardigerwijs ook verschillen. Hoe kan dat? In de eerste plaats zijn de meetnetten niet helemaal gelijk. Er zijn veel meer meetstations dan die gebruikt worden voor het berekenen van de globale temperatuur. De keuze welke meetstations wel gebruikt worden en welke niet heeft invloed op de uitkomst. Daar is al veel over geschreven de afgelopen jaren.

Bovendien dekken de meetstations slechts een deel van de aarde. Zo zijn de meeste stations te vinden in de rijkere landen, in gebieden met een hoge bevolkingsdichtheid. Andere gebieden leveren daarentegen nauwelijks data. Oceanen zijn daar een goed voorbeeld van , maar ook de poolgebieden, berggebieden en woestijnen leveren zeer spaarzaam data. Elke organisatie heeft zijn eigen methode om de “gaten” in het meetnet te vullen met geschatte temperaturen. Met name GISS NASA gebruikt daarvoor een methode die niet onomstreden is.

Tenslotte is er de homogenisatie van de ruwe meetgegevens, die tot doel heeft meetfouten als gevolg van bijvoorbeeld meetpuntverplaatsing en UHI-effect te neutraliseren. Niet elke organisatie doet dat op even doorzichtige wijze. Al diverse malen heb ik over de bizarre homogenisatiemethode van GISS NASA geschreven. Zie hiervoor het hoofdstuk “De Feiten”, en dan de paragraaf “Meten is Weten” over de merkwaardige wijze waarop GISS bijvoorbeeld de temperatuurreeks van De Bilt homogeniseert.

Op de gegevens van GISS NASA na liggen alle trendlijnen nagenoeg op 0, dus geen verdere opwarming van de aarde de afgelopen 10 jaar. Dat is voor de ontwikkelingen van de temperatuur in de nabije toekomst veel interessanter dan de veel gelezen constatering dat het afgelopen decennium “het warmste sinds 1880” was.

Braziliaanse meetstations

Zoals bekend hebben stadsklimaten temperaturen die soms wel 3 °C boven die van de direkte omgeving liggen. Oorzaken zijn de vele warmtebronnen (ook metabolische) en de fysische eigenschappen van de bebouwde omgeving.

Hieronder de temperatuurgrafieken van de enige (!) 6 meetstations in Brazilie die meetgegevens hebben vanaf begin vorige eeuw tot na 2004. Kunt U het meetstation er uit halen dat door het Global Historical Climatology Network als enige als “ruraal” (landelijk gelegen) gekenmerkt wordt? Over de uitslag kan niet gecorrespondeerd worden….

Ook Nieuw-Zeeland heeft zijn klimaatschandaal

Aan de andere zijde van de aardbol is een stevig schandaal ontstaan over de wijze waarop de New Zealand’s National Institute of Water & Atmospheric Research (NIWA) omgaat met temperatuurdata. Daardoor is directeur David Wratt van het NIWA in de problemen geraakt. Wratt was vice-voorzitter van het AR4 rapport 2007 van het IPCC.

Hieronder is de officiële grafiek te zien van het NIWA van het temperatuurverloop in Nieuw-Zeeland vanaf 1850. De grafiek lijkt sterk op de grafiek van CRU die de gang van de globale temperatuur vanaf 1850 weergeeft (zie “Dogma’s” onder “Het wordt steeds warmer”).

De opwarming in Nieuw-Zeeland was de afgelopen eeuw zelfs 0,92° C, opmerkelijk meer dan de 0,6° a 0,7° C die voor de gehele wereld wordt aangehouden door het IPCC.

The New Zealand Climate Science Coalition, in 2006 opgericht door een aantal verontruste wetenschappers, heeft met behulp van de raw data van de Nieuw-Zeelandse meetstations een grafiek gemaakt die er heel wat anders uitziet:

Opmerkelijk, niet? Er is nauwelijks sprake van opwarming. De officiële cijfers blijken te zijn “aangepast” door het NIWA. Oudere data blijken veelal naar beneden te zijn bijgesteld, terwijl de jongere data omhoog zijn gekrikt. De tabel hieronder geeft de afwijkingen weer. Bij slechts 1 station zijn de data licht naar beneden bijgesteld, de andere zijn flink opgeschroefd.

Gevraagd naar het hoe en waarom van de sterke afwijking die de grafiek van het NIVA te zien geeft ten opzichte van de raw data, verklaarde een woordvoerder van NIWA dat de aanpassingen zijn gedaan voor bijvoorbeeld de verplaatsing van een meetpunt. Als voorbeeld gaf hij een verplaatsing van het Wellington meetpunt in 1928 naar een plaats die 122 m hoger ligt dan de oude.

Woordvoerder van NIWA, David Wratt, vice-voorzitter van het AR4 rapport 2007 van het IPCC, weigert tot nu toe gegevens te verstrekken over de wijze waarop de “aanpassingen ” van de andere stations zijn gedaan. De New Zealand Climate Science Coalition merkt op: “While such an adjustment is valid, it needs to be fully explained so other scientists can test the reasonableness of the adjustment.”

Maar ook over de gegevens van het station Wellington die het NIWA verstrekte, is men erg ontevreden. Het lijkt er sterk op dat het NIWA niet de noodzakelijke parallelmetingen heeft verricht om de verplaatsing zonder fouten te kunnen verrichten.

Lees de lopende discussie op de site TBR.cc .

Maart 2010: alweer een warmterecord, of toch niet?

De Volkskrantsite berichtte dat de afgelopen maart de warmste maand op aarde was sinds 1880. Dat had de krant van de website van NOAA, de National Oceanic and Atmospheric Administration van de Verenigde Staten van Amerika.

Pikant detail van het Volkskrantbericht was dat het bijgevoegde plaatje van de zon was, inclusief een prachtige plasma-eruptie (zie bovenstaande foto, overigens geleend van NASA).

NOAA schreef: “The world’s combined global land and ocean surface temperature made last month the warmest March on record, according to NOAA. Taken separately, average ocean temperatures were the warmest for any March and the global land surface was the fourth warmest for any March on record. Additionally, the planet has seen the fourth warmest January – March period on record.” Onderstaand plaatje werd er bij afgedrukt.

NOAA beheert data zoals temperatuuranomalieën in het archief van de GHCN, de Global Historical Climatology Network, dat haar data betrekt van een netwerk van meetpunten over de hele wereld. Althans wat betreft de data op het vasteland. De data van de rest van de wereld (2/3 van het totale opppervlak, verkrijgt NOAA van ERSST, Extended Reconstruction Sea Surface Temperature. Een andere verstrekker van globale temperaturen, NASA/GISS, haalt haar data binnen via NOAA. Het zijn dus dezelfde data, maar de NASA/GISS gebruikt wel haar eigen grafische weergave. Het is even schrikken: maart 2010 de warmste sinds 1880?

Maar dan komt er op 15-4 een bijzonder bericht binnen via de site van luis-in-de-pels Steven McIntyre, van climateaudit.com. Een opmerkzame lezer heeft ontdekt dat de temperatuurdata van Finland op de kaart van NOAA niet kloppen met de in Finland geregistreerde data: “Well, according to the Finnish Meteorological Institute, March 2010 was colder than usual all over Finland, especially in the northern part. For instance, the mean temperature in Sodankylä was -10.3 °C, which is almost three degrees below the base period 1971-2000 average (-7.5 °C). So the GISS March value for Sodankylä is off by amazing 11.8 °C! Some quality control, please!” .

In Finland was het namelijk afgelopen maart bijzonder koud, zelfs voor Finse begrippen. Hoe kon dat? Het antwoord liet niet lang op zich wachten. Dezelfde dag nog verschijnt er op de site van NASA/GISS een berichtje dat de data voor Finland niet klopten. Die data waren overgenomen van NOAA, en bij vergissing was het minteken verdwenen, zodat de Finse temperaturen veel hoger uitkwamen op de kaarten van NOAA en NASA/GISS dan ze in werkelijkheid waren. NASA/GISS schreef: “The data shown between 4/13 and 4/15 were based on data downloaded on 4/12 and included some station reports from Finland in which the minus sign may have been dropped. NOAA updated GHCN on 4/13 by removing those data and we updated our displays today. The March 2010 global mean temperature was affected by about 2/100 of a degree Celsius, well below the margin of error (about 15/100 of a degree for monthly global means).” .

Gelukkig, voor de opmerkelijke warmte van maart 2010 maakte het allemaal niet veel uit schrijft men. Men kan zich evenwel afvragen of de gebruikte data niet andere fouten bevat dan de Finse data, die niet opgemerkt worden door oplettende lezertjes. En de onjuiste data zijn “removed” en blijkbaar niet gecorrigeerd. Hoe heeft men dan de grids boven Finland opnieuw in kunnen kleuren? Het antwoord is te vinden in de manier waarop dergelijke kaartjes worden gemaakt.

Op bovenstaand NASA/GISS-kaartje van de temperatuuranomalieën maart 2010 is de correctie van de “Finland”-fout uitgevoerd met behulp van de statistische methode waarmee dit soort kaarten wordt geproduceerd. Vanwege het feit dat de hoeveelheid meetpunten beperkt is en ruimtelijk ongelijk verspreid, past men een zogenaamde “smoothing radius” toe. Daarbij gaat men ervan uit dat binnen een afstand van 1200 km van een meetpunt de temperatuur kan worden bepaald op basis van de data van het betreffende meetpunt, met een afnemende betrouwbaarheid met de afstand. Hanssen heeft in 1999 deze werkwijze beschreven (Hansen et al: GISS analyses of surface temperature change, 1999, NASA, New York).

Hij schrijft over deze methode: “ … the resulting data set is used to estimate regional temperature change on a grid with 2° x 2° resolution. Stations located within 1200 km of the grid point are employed with a weight that decreases linearly to zero at the distance 1200 km (HL87). We employ all stations for which the length of the combined records is at least 20 years; there is no requirement that an individual contributing station have any data within our 1951-1980 reference period. As a final step, after all station records within 1200 km of a given grid point have been averaged, we subtract the 1951-1980 mean temperature for the grid point to obtain the estimated temperature anomaly time series of that grid point. Although an anomaly is defined only for grid points with a defined 1951-1980 mean, because of the smoothing over 1200 km, most places with data have a defined 1951-1980 mean. ”

Intussen is die referentieperiode verschoven van 1951-1980 naar 1971-2000. Men kan dus – zeker in Europa met zijn relatief dichte net van meetpunten – met behulp van deze smoothing-methode toch een volledig “ingekleurd” kaartje produceren, ook al ontbreken gegevens van een aantal meetpunten. Dat is dus gebeurd met de ontbrekende (lees: foute) Finse data. De kaart die door NOAA is geproduceerd (zie begin artikel) heeft dezelfde smoothing-radius als de bovenstaande kaart van NASA/GISS, namelijk 1200 km.

Op het NASA-kaartje hierboven zijn ook de maart- anomalieën weergegeven , maar dan met een smoothing-radius van 250 km. Wat dat voor gevolgen heeft voor gebieden met een ruimtelijk wijdmazig meetnet is goed te zien. Grote delen van Canada, Groenland, Noordelijke IJszee, Afrika, Zuid-Amerika en Antarctica zijn grijs gekleurd: no data available.

Deze methode van smoothing, die uit statistisch oogpunt bezien niet onomstreden is, krijgt een extra dimensie als men beziet wat er de afgelopen decennia met het meetnet gebeurd is. Joseph D’Aleo en Anthony Watts schreven daar in 2009 een geruchtmakend artikel over (Joseph D’Aleo and Anthony Watts: Surface temperature records: policy-driven deception?, 2009, SPPI).

Tussen ongeveer 1970 en 2010 is het aantal meetpunten in het Global Historical Climatology Network teruggevallen van ruim 6000 tot ongeveer 1500. Op bovenstaande grafiek is die terugval goed te zien. D’Aleo en Watts hebben die sterke vermindering van meetpunten geanalyseerd en kwamen tot de ontdekking dat met name rurale meetpunten en meetpunten op hogere breedte het moesten ontgelden. Op de kaartjes hieronder is te zien hoe het netwerk in Canada is uitgedund, vooral op hogere breedten. Vandaar het ontbreken van data op het kaartje met de smoothing-radius van 250 km.

En dan is er nog de kwestie van de betrouwbaarheid van oude data. Rond 1900 was het aantal meetpunten in het meetnet van GHCN ongeveer zo groot als momenteel, ongeveer 1500. Maar de geografische spreiding was destijds een stuk onregelmatiger, zoals onderstaande kaartjes laten zien. Grote delen van continenten werden nauwelijks bemeten. Het is daarom uiterst twijfelachtig of op basis van een dergelijk wijdmazig netwerk een “global temperature” te destilleren valt.

Conclusie: het lijkt me niet onverstandig om het nieuwe “record” (en de records die de komende jaren nog gaan komen) met de nodige scepsis te bekijken. In ieder geval staat één ding vast: de gemiddelde wereldtemperatuur bestaat niet, en is hoogstens een schatting. En aan de wijze waarop die schatting tot stand komt kleven statistische onvolkomenheden en menselijke fouten. Enige terughoudendheid bij harde conclusies over de globale temperatuuranomalieën van maart is dus op zijn plaats, zeker omdat allerlei factoren van invloed zijn op dergelijke cijfers. Een daarvan noemt NOAA zelf al op haar site: “El Niño weakened to moderate strength in March, but it contributed significantly to the warmth in the tropical belt and the overall ocean temperature. According to NOAA’s Climate Prediction Center, El Niño is expected to continue its influence in the Northern Hemisphere at least through the spring.”. April kan dus ook nog gaan pieken, u bent gewaarschuwd!

Het warmste decennium ooit

Dat was het eerste decennium van deze eeuw volgens NASA-GISS. Althans in de zogenaamde “modern record”, de metingen vanaf 1880. In het hoofdstuk “De Dogma’s” is onder “Unieke Temperatuurstijging” al het een en ander geschreven over de temperaturen van vóór 1880. Zoals reeds hiervoor beschreven is NASA-GISS een van de organisaties die trachten de “globale temperatuur” vast te stellen. Ik schreef op 22-1-2010 al een stukje over de GISS-benadering van de raw data van meetstation De Bilt. GISS gebruikt daar een bijzonder rare manier van homogenisatie en heeft dezelfde werkwijze ook toegepast bij een aantal andere Europese meetstations (wellicht bij alle meetstations, maar dat heb ik niet geverifieerd). Over het homogeniseren van GISS en de wijze waarop men de meetstations heeft geselecteerd later zeker meer.

De vraag is: is de strekking van het persbericht waar? Als je de GISS-data betrouwbaar acht, en je ook het GISS-netwerk van meetpunten representatief acht voor het vaststellen van de “globale temperatuur”, en je akkoord gaat met de methode die GISS hanteert om de data te “globaliseren”, dan kun je na het bekijken van bovenstaande grafiek niet anders concluderen dan dat het de laatste decennia warmer was dan de periode daarvoor. Over die homogenisatie die GISS toepast is al het een en ander geschreven. Conclusie voor de GISS-meetreeks van De Bilt van 1880-2010: broddelwerk en onbruikbaar (zie Opmerkelijk 22-1-2010). Over het meetnetwerk van GISS zijn op diverse klimaatsites al harde noten gekraakt (zie ook het verschil NH-ZH op bovenstaande grafiek), evenals de methode die GISS toepast om van een beperkt aantal meetpunten een “dekkende” temperatuur te verkrijgen. Laten we eens naar de GISS-data van de laatste 2 decennia kijken:

Wat valt op? De trendlijn van het laatste decennium ligt iets vlakker dan die van het voorgaande decennium, maar er is volgens GISS nog steeds sprake van een stijgende globale temperatuur. Interessant wordt het als we de satellietdata van MSU-AMSU erbij pakken (zie hieronder). Niet alleen liggen de satellietmetingen lager dan die van GISS, maar er is ook duidelijk sprake van een trendbreuk. De trendlijn 2000-2010 stijgt nauwelijks meer, in tegensteling tot die van 1990-2000.

Op onderstaande grafiek zijn beide meetreeksen weergegeven.

Wat is betrouwbaar? Vooralsnog heb ik de neiging om die van GISS minder betrouwbaar te achten, vanwege het homogenisatie-broddelwerk, het beperkte meetnetwerk en nog wat andere zaken. Laat ik er eens van uitgaan dat de grafiek van MSU-AMSU juist is (ik heb er althans meer vertrouwen in dan in de GISS-grafiek) , is dan de kop van het persbericht van NASA-GISS (nog) juist? De satellietmetingen startten in 1979, en van deze periode is het afgelopen decennium zeker de warmste geweest. Ook andere meetreeksen, die redelijk betrouwbaar geacht worden, geven vanaf 1880 een gemiddeld stijgende trend. En van 1980 tot 2000 steeg de gemiddelde temperatuur op aarde. Als de periode 1990-2000 een stijgende trend laat zien, en de periode 2000-2010 een vlakke trend, dan is het logisch dat de gemiddelde temperatuur van het laatste decennium hoger ligt dan die van het voorafgaande decennium. Maar is het interessant dat het jongste decennium de warmste was? Is het niet veel interessanter om je te verwonderen over de trendbreuk rond 2000?

Collega Jan Ruis uit Delft heeft onlangs een interessante presentatie van zijn hand opgestuurd, waarvan ik u de uitkomsten niet wil onthouden. Het betreft een analyse van het verloop van de globale temperatuur sinds het midden van de 19e eeuw tot heden. U herkent de grafiek wel. Hij is gebaseerd op de dataset HadCRUT3. Het betreft maandelijkse anomalieën (afwijkingen) ten opzichte van een bepaalde referentieperiode.

Deze grafiek werd in het laatste (4e) rapport van het IPCC ‘gebruikt’ om te bewijzen dat er sprake is van een versnelling in de opwarming op aarde:

Het ziet er inderdaad indrukwekkend uit, maar is het juist? Om dat nader te kunnen analyseren moet je de grafiek enigszins manipuleren. Ik bedoel daar uiteraard niet mee op de manier “hide the decline”, maar door de grafiek uiteen te rafelen. In de periode 1856-2011 is een tweetal bewegingen te herkennen, namelijk een oscillerende (golvende) en een stijgende (trend).

We gaan ons eerst richten op de oscillerende beweging in het signaal. Om die goed te kunnen onderscheiden van de trend moet je de grafiek ‘detrenden’, de trendlijn horizontaal leggen. Dat doe je door de waarden van de trendlijn af te trekken van de waarden van het signaal. De grafiek komt er dan zo uit te zien:

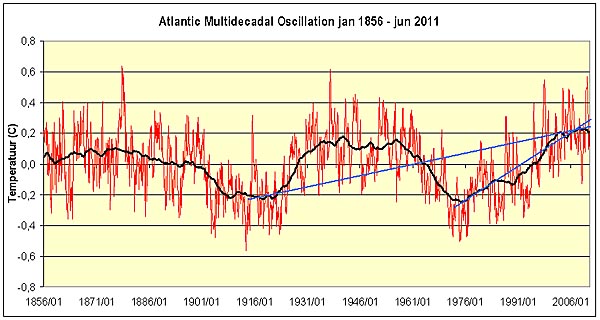

Het toont de golvende beweging in het signaal, zonder dat je ‘last’ hebt van de stijgende trend. Wat is nu de oorzaak van die golfbeweging? Al langer gaat de aandacht uit naar de AMO, de Atlantische Multidecadale Oscillatie. Die zijn we ook al eens tegengekomen in het verhaal over het natter worden van de Sahel (zie onder De Dogma’s: De Sahara groeit). De AMO is een lange serie van veranderingen in de temperatuur van het oceaanwater van de Atlantische Oceaan tussen de evenaar en Groenland. Deze in 1994 ontdekte oscillatie heeft een periodiciteit van gemiddeld 45 jaar. De temperatuurvariatie is niet groot, ongeveer 1°C.

De AMO wordt al ruim anderhalve eeuw gemeten, maar uit paleoklimatologische onderzoeken is bekend dat het verschijnsel al minstens 1000 jaar werkzaam is. Hieronder is het verloop van de AMO gedurende de afgelopen 1000 jaar weergegeven.

Bron: Lienke te Raa

De figuur komt uit de studie van Lianke te Raa (IMAU) uit 2006. Zij schrijft:

“De oceanen spelen een belangrijke rol in het klimaat. Door de grote warmtecapaciteit van water kunnen de oceanen enorme hoeveelheden warmte opslaan. Deze warmte wordt vervolgens over de hele aarde getransporteerd door de oceaanstromingen. Op andere plaatsen op aarde kan de warmte dan weer worden afgegeven aan de atmosfeer. Een voorbeeld is de Golfstroom, die voor de kust van Florida loopt en dan de Noord-Atlantische Oceaan oversteekt als de Noord-Atlantische Stroming. Het relatief warme water dat door deze stromingen richting West-Europa wordt gevoerd wordt gezien als een belangrijke oorzaak voor het relatief milde klimaat van Noordwest-Europa.

Ook in de diepzee (dieper dan ongeveer 1500 meter) stroomt het water, al zijn de snelheden daar extreem laag: een typische stroomsnelheid in de diepzee bedraagt enkele centimeters per seconde (tegen enkele tientallen centimeters per seconde tot maximaal 1 meter per seconde voor oppervlaktestromingen). Omdat het echter om zoveel water gaat, is dit transport wel degelijk van belang. Een schematische weergave van de oppervlakte- en diepzeestromingen in alle oceanen (figuur 1) laat zien dat in het noorden van de Noord-Atlantische Oceaan een bijzonder proces optreedt: de oppervlaktestroming ‘verandert’ hier in een diepzeestroming. Door de sterke afkoeling aan het oppervlak van het relatief zoute water dat door de Golfstroom wordt aangevoerd, treedt hier diepe convectie op. Hierbij wordt de hele waterkolom doorgemengd en ontstaat water met een hoge dichtheid, dat vervolgens aan een reis door de diepzee begint. Het koude, zware water stroomt in de diepzee naar de Zuid-Atlantische Oceaan en komt voor een groot deel in de Indische en Stille Oceaan terecht. In tegenstelling tot de atmosfeer komt zulke diepe convectie in de oceaan maar op enkele plaatsen ter wereld voor: naast de Labrador Zee en ten zuiden van Groenland zijn er nog slechts enkele belangrijke gebieden van zogenoemde diepwaterformatie rondom Antarctica.

Bron: R.Currie

Bron: R.Currie

Globale oceaanstromingen zoals geschetst in figuur 1 worden aangedreven door de wind aan het oppervlak en door verschillen in dichtheid van het zeewater. De dichtheid van zeewater wordt bepaald door de temperatuur en het zoutgehalte van het water. Over het algemeen is het (oppervlakte)water op lage breedtegraden warm en zout, terwijl het op hoge breedtegraden koud en zoet is. Temperatuur en zoutgehalte hebben een tegengesteld effect op de dichtheid: hoe warmer, hoe lichter en hoe zouter, hoe zwaarder. Meestal wint het effect van de temperatuur: het zeewater rondom de evenaar is lichter dan dat op hoge breedtegraden. Dit soort dichtheidsverschillen in de oceaan zorgen voor drukverschillen, die op hun beurt stromingen aandrijven. Terwijl het effect van de wind op de oceaancirculatie zich beperkt tot ongeveer de bovenste kilometer (van de gemiddeld zo’n vier kilometer diepe oceaan), spelen stromingen als gevolg van dichtheidsverschillen zich af zowel aan het oppervlak als in de diepzee. Het hier geschetste beeld van de oceaanstromingen is een gemiddelde. De werkelijke stromingen kunnen sterk variëren, met als gevolg dat ook het warmtetransport verandert, evenals de afgifte van warmte aan en opname van warmte vanuit de atmosfeer. Ook de plaatsen waar opname of afgifte van warmte optreedt zijn aan dit soort veranderingen onderhevig. ”

Over de exacte oorzaken van het ontstaan van de AMO is de Raa resoluut:

“Gemiddeld genomen is het zeewater in het noorden kouder dan in het zuiden, waardoor het zeeoppervlak in het noorden iets lager staat dan in het zuiden. De oppervlaktestroming is dan ook noordoostwaarts, terwijl de diepzeestroming vooral zuidwaarts is (zie ook figuur 1). Tijdens de fase waarin de AMO-index positief is, is de temperatuur in het noorden van de Noord-Atlantische Oceaan wat hoger dan gemiddeld. Hierdoor zet de waterkolom wat meer uit, en staat het zeeoppervlak wat minder laag dan gewoonlijk. Als we het verschil met de tijdsgemiddelde situatie bekijken, is er in het noorden dus een hogedrukgebied in de oceaan ontstaan, met een anticyclonale (afwijking van de gemiddelde) stroming als gevolg. De oost-west component van de stroming aan het oppervlak is minder sterk dan gewoonlijk: de afwijking van de tijdsgemiddelde oppervlaktestroming is westwaarts (figuur 5, linker schema).

Er gebeurt echter ook nog wat anders: omdat het zeewater, afgezien van de warme afwijking in het noorden, gemiddeld genomen steeds kouder wordt naar het noorden toe, zal de anticyclonale stromingsanomalie die ontstaat zorgen voor zuidwaarts transport van koud water in het noordoosten. In het noordwesten wordt juist warm water naar het noorden gebracht. Hierdoor schuift het gebied waarin het water abnormaal warm is, naar het westen toe. Dit is precies de westwaartse verplaatsing die we zagen in de computersimulaties.

Dit brengt ons een kwart periode verder (rechter schema in figuur 5), in de fase waarin de AMO-index overgaat van positief naar negatief. Nu is er met name een zeehoogteverschil in oost-west richting, en aan het oppervlak is er (gemiddeld over de oost-westrichting) een zuidwaartse stromingsanomalie. Omdat de gemiddelde stroming aan het oppervlak noordwaarts is, betekent dit dus een verzwakking van de noordwaartse stroming. Het uit fase zijn van de stroming in noord-zuid en oostwestrichting klopt ook met wat we in de computersimulaties gezien hebben. Weer een kwart periode later is de situatie precies omgekeerd als in het linker schema van figuur 5, met abnormaal koud water, en een cyclonale stromingsanomalie. Ook dit koude water beweegt zicht naar het westen voort, want de cyclonale stroming brengt dan koud water zuidwaarts in de noord-westhoek van het oceaanbekken. Zo kan dit proces blijven doorgaan. De periode van de Atlantische Multidecadale Oscillatie wordt dus bepaald door de snelheid waarmee de koude en warme gebieden in de oceaan westwaarts bewegen. Deze snelheid hangt op zijn beurt weer af van de sterkte van het noord-zuid temperatuurverschil, en van de tijdsgemiddelde stroming. ”

Kort samengevat: de AMO is het gevolg van een aantal natuurlijke processen, zoals verschillen in temperatuur met als gevolg verschillen in waterhoogte, windrichting en Corioliskracht. De gevolgen van de AMO zijn groot. We hebben al gezien dat de AMO het neerslagregime van de Sahel bepaalt, en de droogtes in Noord-Amerika. En het is bekend dat het invloed heeft op de temperatuur in Europa en Noord-Amerika. Maar strekt de invloed van de AMO zich nog verder uit? Kijk eens naar de figuur hieronder.

Hier zijn HadCrut3 en AMO + trend weergeven in 1 grafiek. Een verbazingwekkend goede correlatie, nietwaar? Maar liefst 62% van de variantie in de temperatuur wordt verklaard door de geringe lineaire stijging van 0,5°C per eeuw gecombineerd met de AMO. Kortom: de temperatuurvariatie op aarde wordt voor een flink deel bepaald door de temperatuur van het water van het noordelijk deel van de Atlantische Oceaan.

Een volgende keer kijken we naar de opwaartse trend en of de klimaatgevoeligheid er uit kan worden afgeleid.

Klimaatgevoeligheid

Nog even een opmerking over de misleidende grafiek uit het vierde rapport van het IPCC zoals getoond in de vorige bijdrage. Daarbij was duidelijk sprake van misleiding door gebruik te maken van de opwaartse trend in het AMO-signaal vanaf 1976. Jan Ruis wijst er terecht op dat hier sprake is van cherry picking, het selecteren van gegevens op een zodanige wijze dat een bepaalde stelling of hypothese ondersteund wordt. De trendlijnen van het IPCC beginnen namelijk alle in een ‘dal’ van de AMO-reeks en eindigen op de piek rond 2005.

Bij steeds korter wordende trendperiodes betekent dat automatisch dat de kortste (=jongste) periode de steilste trendlijn krijgt . Dat wijst op doelbewust geselecteerde trendlijnen. Als je in de AMO cyclus trendlijnen trekt van dal naar piek krijg je ook een artefact van versnelde opwarming die er natuurlijk niet is in de AMO want die vertoont geen trend. Zie de figuur hieronder.

En dan nu de klimaatgevoeligheid. In de vorige bijdrage is op basis van de temperatuurreeks van HadCRUT3 vastgesteld dat de stijging van de globale temperatuur tussen 1856 en 2011 0,048 ºC/ decade was, en dat die trendmatige stijging lineair was.

Nu we de lineaire trend van 0,048 ºC/ decade van de afgelopen anderhalve eeuw te pakken hebben, is het wellicht mogelijk om daaruit de klimaatgevoeligheid ( climate sensitivity) te destilleren. Onder klimaatgevoeligheid verstaan we de verandering van de globale temperatuur als gevolg van een verdubbeling van het C02-gehalte. Zie ook hier. Hieronder is de klimaatgevoeligheid weergegeven volgens het IPCC (modellen) en diverse onderzoekers.

De variatie van de klimaatgevoeligheid binnen de 20+ klimaatmodellen zoals gebruikt door het IPCC is groot, en loopt van 1,5 ºC tot meer dan 4 ºC. het IPCC gaat uit van een gevoeligheid van 3 ºC bij verdubbeling van CO2. Het wordt algemeen aanvaard dat – als alle andere factoren gelijk blijven – de klimaatgevoeligheid ~1,1 ºC is. Elke afwijking van deze waarde in de getoonde tabel is het gevolg van de werking van feeedbacks, met name van bewolking en waterdamp.

Alle door het IPCC gebruikte klimaatmodellen gaan uit van een positieve feedback van bewolking als gevolg temperatuurstijging. Zoals wel vaker hier en elders beschreven is het gedrag van wolken wellicht de minst begrepen factor in de stralingsbalans van de aarde. Maar ook de aanname dat bij een stijgende temperatuur de relatieve vochtigheid van de troposfeer gelijk blijft is aan kritiek onderhevig, zoals in de studie van Solomon e.a. uit 2010.

Miskolczi, Idso, Lindzen en Spencer komen allen veel lager uit dan de 3 ºC van het IPCC , en zelfs lager dan 1,1 ºC. Ze zijn dan ook niet populair bij IPCC-adepten. Alle in de tabel weergegeven waarden zijn op indirecte wijze verkregen. Ze zijn de uitkomst van een of meerdere runs van klimaatmodellen, of het resultaat van soms ingewikkelde wiskundige berekeningen, al of niet op basis van satellietgegevens.

Klimaatmodellen definiëren een klimaatgevoeligheid λ die de stralingsforcering ΔF vertaalt naar een verandering van de oppervlaktetemperatuur ΔT: ΔT= λ ΔF. De klimaatgevoeligheid λ is 0,8 ºC per Wm-2 stralingsforcering. Een verdubbeling van CO2 van het pre-industriële niveau van 280 ppm naar 560 ppm leidt dan volgens het IPCC tot +3,7 Wm-2 stralingsverandering. Dat leidt volgens het IPCC inclusief feedbacks tot de temperatuurstijging van 3 ºC .

De lineaire trend zoals we die hierboven hebben geëxtrapoleerd uit de HadCRUT3 temperatuurreeks kan ook gebruikt worden om de klimaatgevoeligheid te berekenen. Daarvoor moet eerst uitgerekend worden op welk moment de verdubbeling van het CO2-gehalte ten opzichte van de pre-industriële waarde plaats zal vinden. De langste betrouwbare tijdreeks van het atmosferisch CO2-gehalte is die van Mauna Loa op Hawaï, van 1958 tot 2011. De reeks stijgt exponentieel volgens y= 0,000086x^2 + 0,0066130x + 314,298300. Trekt men deze trend door in de tijd, dan komt die trendlijn fraai overeen met die van scenario A1B uit AR4 van het IPCC. In 2073 zou dan sprake zijn van verdubbeling van het CO2-gehalte ten opzichte van dat van het beginjaar van de AMO-reeks in 1856: 572 ppm vergeleken met 286 ppm uit 1856.

Het scenario A1B uit het IPCC rapport wordt gekarakteriseerd door de volgende kenmerken:

Snelle economische groei

Maximale wereldbevolking van 9 miljard in 2050, daarna afname

Snelle verspreiding van nieuwe technologieën

Toenemende sociale , economische en culturele globalisering

Gebruik van zowel fossiele als niet-fossiele energiedragers

Op onderstaande figuur uit het syntheserapport van het IPCC uit 2007 is te zien dat op basis van de gebruikte klimaatmodellen de temperatuur in 2090-2099 2,8 ºC zal zijn dan in de periode 1980-1999. Voor een vergelijking met de situatie van 1850-1899 komt men op een toename van 3,3 ºC. Dat komt overeen met een klimaatgevoeligheid van ongeveer 3 ºC.

Uitgaande van 2073 voor verdubbeling van het atmosferisch CO2-gehalte en een lineaire temperatuurtrend van 0,048 ºC/ decade kan men de klimaatgevoeligheid berekenen:

2073 – 1856 = 217 jaar = 21,7 decaden x 0,048 ºC = 1,0 ºC

Of:

ΔT = 1,0 x LOG (572/286) / LOG (2) = 1,0 ºC

In 2073 zou – als de lineaire trend zich voortzet – het dus op aarde gemiddeld 1 ºC warmer zijn dan in 1856. Bij een stijging van de wereldtemperatuur tussen 1856 en 2010 van ~0,7 ºC betekent dit dat vanaf 2010 tot 2073 er nog slechts 0,3 ºC bij komt.

Deze 1 ºC klimaatgevoeligheid is berekend op basis van de gemeten temperatuurwaarden van 1856 tot 2011, en is dus inclusief alle feedbacks! Als er tussentijds dus geen gekke dingen gebeuren (verandering in externe forcing bijvoorbeeld) dan is de klimaatgevoeligheid dus zo’n 2/3 lager dan het IPCC veronderstelt. En die door het IPCC voorspelde klimaatgevoeligheid van 3 ºC ( op basis van de gehanteerde klimaatmodellen) is óók inclusief feedbacks.

Zonder feedbacks leidt een verdubbeling van CO2 tot een temperatuurstijging van ~1,1 ºC. Dat betekent dat volgens de hier gepresenteerde klimaatgevoeligheid van 1 ºC de totale feedback 0 tot licht negatief moet zijn.

Er is een aantal recente publicaties dat ook op een veel lagere klimaatgevoeligheid uitkomt dan het IPCC. Levitus et al hebben in 2009 gepubliceerd over de warmteopslag in de bovenste 700 m van de oceanen (Ocean Heat Content) tussen 1955 en 2008. In de tabel hierboven is te zien dat de stijging van de OHC tussen 1969 en 2008 een temperatuurtoename heeft veroorzaakt van 0,168 ºC over 40 jaar. Dus 0,168/40 levert toename op van 0,042 ºC/decade, een beetje minder dan de berekende trend voor de wereldtemperatuur. Hieruit volgt een klimaatgevoeligheid van 0,9 ºC.

Zoals in de tabel te zien is, is met name de Tchange in het noordelijk deel van de Atlantische Oceaan zeer hoog vergeleken met de temperatuurstijging in de andere oceaanbekkens. In onderstaande figuur van Bob Tisdale is dat goed te zien.

Dat laatste is niet zo verwonderlijk als men bedenkt dat de metingen van het OHC beginnen in 1955, tijdens het stijgende been van de AMO. Daardoor wordt de trend van de wereld-OHC van 0,0073 GJm-2/jaar ook nog eens overschat. In de bijdrage van 3 augustus j.l. heb ik hier aandacht besteed aan de publicatie van Palmer e.a.. Die toonden aan dat de OHC sinds 2003 geen stijging meer vertoont. Het is dus niet onmogelijk dat de OHC als interne forcing de klimaatgevoeligheid verder zal doen dalen.

Roy Spencer vergeleek de uitkomsten van de Levitus-publicatie met die van 2 klimaatmodellen die door het IPCC worden gebruikt. IPSL-CM4 is een van de meest gevoelige modellen, NCAR PCM1 is een model met een lage klimaatgevoeligheid. Conclusie: de metingen (Levitus) wijzen op een veel kleinere klimaatgevoeligheid dan de door het IPCC gebruikte modellen hanteren.

Spencer en Braswell hebben onlangs een publicatie het daglicht doen zien over natuurlijke variaties in bewolking die de feedback van wolken maskeren. De hypothese is dat gedurende de El Niño en La Niña fasen van de ENSO veranderingen in de gekoppelde oceaan-atmosfeercirculatie de bewolking stuurt. In de reguliere klimaatmodellen gaat men er van uit dat bewolking het gevolg is van verandering in de stralingsbalans (als gevolg van een toegenomen CO2-gehalte). Over deze kwestie is een interessante polemiek gaande op http://www.climateaudit.org/ , whatsupwiththat.comen http://www.drroyspencer.com/ .

Richard Lindzen van het MIT en Choi van het EWU in Korea hebben dit jaar gepubliceerd over klimaatgevoeligheid. Hetonderzoek werd gedaan op basis van de SST-data (Sea Surface Temperature) en de TOA (Top Of Atmosphere) satellietdata van de ERBE en CERES instrumenten tussen 1985 en 2008. Lindzen en Choi komen op basis van deze meetdata uit op een klimaatgevoeligheid van 0,7 ºC.

Tot slot nog het volgende: de hier berekende klimaatgevoeligheid van 1 ºC is de resultante van alle forcings en feedbacks die de temperatuur aan het aardoppervlak bepalen. Professor Cees de Jager et al komen in een publicatie uit 2010 uit op een aandeel van de zon in de recente opwarming van 0,3 ºC. Die 0,7 ºC klimaatgevoeligheid op basis van CO2-verdubbeling van Lindzen en Choi lijkt dus zo gek nog niet.