De mondiale zeespiegelstijging, een inleiding (met dank aan Bert Amesz)

De huidige trend in de zeespiegelstijging vindt zijn oorsprong halverwege de negentiende eeuw. Ook is er gedurende de twintigste eeuw geen significante versnelling waarneembaar. Bovendien blijkt dat de zeespiegelstijging in Noord West Europa, door regionale factoren, achterblijft bij het wereldgemiddelde.

Aan het einde van de laatste grote ijstijd, zo’n 20.000 jaar geleden, stond de zeespiegel 120 meter lager dan nu. Vanaf die periode is hij in een soort ’S-curve’ omhoog gekomen tot ongeveer het huidige niveau. Zie figuur. Bij de aanvang van de huidige interglaciale periode (Holoceen) stond de zeespiegel nog 60 meter lager en steeg toen met 15 mm/jaar. Ongeveer 8.000 jaar geleden begon de stijging nadrukkelijk af te vlakken; het relatief warmere ‘atlanticum’ ging over in een iets koeler neoglaciaal tijdperk. Aan het begin van onze jaartelling stond de spiegel nog 1,5-2,5 meter lager dan nu.

Het huidige subatlantische tijdperk heeft overigens nog een aantal ‘recente rimpelingen’ gekend: een warme Middeleeuwse periode tussen de 10e en 14e eeuw, gevolgd door de ‘kleine ijstijd’ tussen de 15e en 19e eeuw. Gedurende deze periodes schommelde de zeespiegel mee.

Peilwaarnemingen (Ref: IPCC, PSMSL, etc) geven aan dat er gedurende de twintigste eeuw sprake was van een gemiddelde stijging van 1,5 tot 2,0 mm/jaar (Nederlandse kust: 1,7 mm/jaar). Echter, satellietmetingen vanaf 1993 (Topex/Poseidon, Jason) laten een veel snellere stijging zien: bijna 3,3 mm/jaar. Zie figuur.

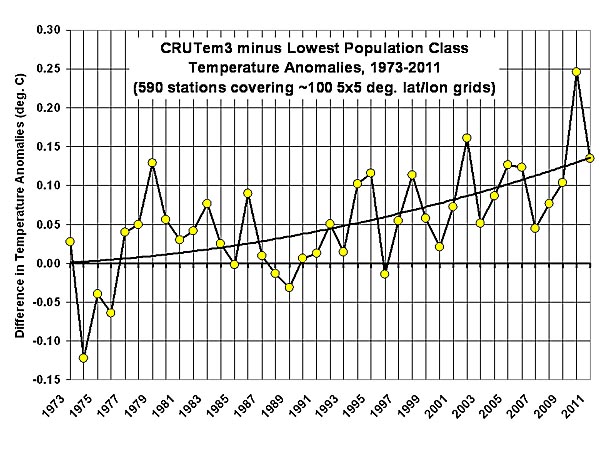

Hoe is die ogenschijnlijke versnelling te verklaren? IPCC wijst op het effect van de mondiale opwarming vanaf de jaren ’70 (zie temperatuurgrafiekje) en de gevolgen daarvan zoals thermische uitzetting, massaverlies Groenland, Antarctica, etc. Maar is dat wel zo?

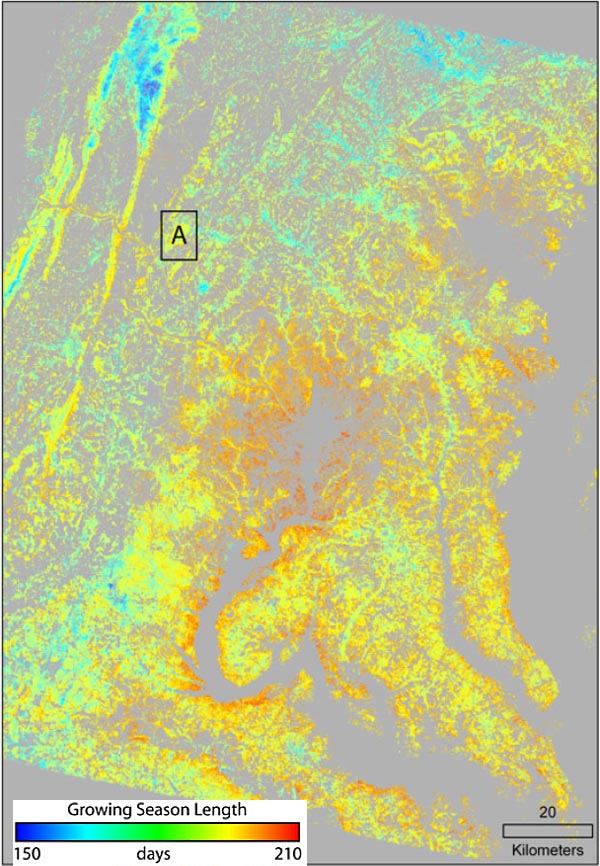

Want er is ook een andere verklaring denkbaar. Het grote voordeel van satellietwaarnemingen is immers dat ook regionale trends midden op de oceanen in beeld gebracht kunnen worden, bijvoorbeeld de sterke zeespiegelstijging (tot meer dan 10 mm/jaar) in het westelijke deel van de equatoriale Pacific. Zie kaartje. Dat deel van de oceaan wordt gekenmerkt door sterke periodieke fluctuaties als gevolg van de El Nino Southern Oscillation (ENSO).

Vanwege de schaalvervorming is de oranje/rode vlek in werkelijkheid veel groter dan het kaartje doet vermoeden. Duidelijk is dat dergelijke fenomenen niet worden waargenomen in de meetstations welke voor het overgrote deel gesitueerd zijn op het noordelijk halfrond (zie kaartje met PSMSL-meetstations met minstens 40 jaar waarnemingen).

De geconstateerde ‘versnelling’ vanaf ’90 zou dus veroorzaakt kunnen worden door het verschil in meetmethode (satelliet versus peilschalen). Uit deze constatering kunnen twee conclusies getrokken worden: (i) de wereldgemiddelde zeespiegelstijging gedurende de twintigste eeuw is groter dan tot nu toe gedacht werd en (ii) de zeespiegelstijging bij NW Europa is lager dan het wereldgemiddelde. Er is dus géén sprake van een versnelling als gevolg van de opwarming van de 70-er jaren zoals IPCC suggereert; die versnelling is overigens ook niet terug te vinden in de PSMSL-stations.

Vervolgens is het interessant te weten waar de door de kuststations gemeten stijging zijn oorsprong vindt. Uit de linkerfiguur (Ref: PSMSL) blijkt dat dat omstreeks 1850 was. Oude peilwaarnemingen bij Amsterdam (vanaf 1700!) en elders laten hetzelfde beeld zien. Ook reconstructies van o.a. CSIRO bevestigen dat. Het moment valt samen met de afloop van de Kleine IJstijd en het begin van de terugtrekking van de gletsjers (zie figuur rechts, IPCC), een terugtrekking die tot nu toe overigens vrijwel lineair verloopt. Opmerkelijk is dat in de meetstations gedurende de twintigste eeuw géén trendversnelling is waar te nemen; hetzelfde is van toepassing op de zeespiegelstijging bij de Nederlandse kust (zes meetstations, RIKZ) en diverse andere stations aan de Noordzee en de Atlantische kust van Europa. De mondiale opwarming gedurende de twintigste eeuw is niet of nauwelijks zichtbaar in de zeespiegelstanden.

Dat zou betekenen dat – ook indien de opwarming niet doorzet – de zeespiegel blijft stijgen. Dat lijkt reeds het geval te zijn vanaf het jaar 2000. Kennelijk trekt de ‘deep ocean thermal expansion’ zich op korte termijn weinig aan van temperatuurvariaties aan het oppervlak. Ook de bijdrage van gletsjers en kleine ijskappen lijkt redelijk constant in de tijd. Jaarlijkse schommelingen zullen ontstaan door de ‘near surface thermal expansion’ in de bovenste honderden meters, boven de thermocline: de laag waarboven uitwisseling met de atmosfeer en opwarming door de zon plaatsvindt.

Voor de Noordzee zijn enkele bijzondere effecten van kracht. Als gevolg van de afnemende zelfgravitatie bij Groenland en vanwege postglaciale elastische effecten verdeelt het smeltwater zich niet gelijkmatig over de oceanen. Voor de Noordzee bedraagt de stijging door de afsmelt van Groenland slechts 20-30% van het wereldgemiddelde; voor de gletsjers bedraagt dat percentage ongeveer 60-70%. Bovendien is er in NW Europa mogelijk sprake van een significant regionaal effect als gevolg van variaties in de Noord Atlantische Oscillatie (NAO) en de intensiteit van de Golfstroom (AMO-index).

Conclusies:

* De ogenschijnlijke versnelling (verdubbeling) van de zeespiegelstijging vanaf de jaren ’90 is voor een (belangrijk) deel toe te schrijven aan het verschil in meetmethode (satelliet versus peilschalen). Satellieten meten immers ook grootschalige regionale fenomenen die buiten het bereik van de kuststations vallen;

* Deze conclusie wordt bevestigd door het feit dat in de peilwaarnemingen een dergelijke versnelling vanaf de jaren ’90 niet waarneembaar is;

* Satellietwaarnemingen geven een representatiever beeld dan de traditionele kuststations;

* Waarschijnlijk was de wereldgemiddelde zeespiegelstijging gedurende de twintigste eeuw groter dan tot nu toe werd aangenomen;

* Echter, vanwege regionale factoren blijft de zeespiegelstijging op de Noordzee en langs de Atlantische kust van Europa achter bij het wereldgemiddelde;

* De ‘huidige’ trend van circa 1,5-2,0 mm/jaar (Noordzee, Europese Atlantische kust) vindt zijn oorsprong in 1850 en valt samen met de afloop van de Kleine IJstijd en het begin van de terugtrekking van gletsjers;

* Deze trend is kennelijk niet of nauwelijks beïnvloed door de opwarming gedurende de laatste eeuw;

* Mede vanwege de trage respons van de diepe oceaan zal de zeespiegel deze eeuw door blijven stijgen, zelfs in een situatie waarin de atmosfeer niet verder opwarmt of zelfs afkoelt.

De zeespiegel en Nederland

Het ‘klimaatbestendig’ maken van Nederland vergt deze eeuw een bedrag dat op kan lopen tot €140 miljard. Althans, dat concludeerde de Deltacommissie in 2008.

Hun advies is gebaseerd op klimaatscenario’s van KNMI (2006), de bevindingen van IPCC (2007) alsmede een aanvullend onderzoek naar bovengrensscenario’s (2008). De commissie adviseert rekening te houden met een (absolute) zeespiegelstijging van 0,55 tot 1,20 meter in het jaar 2100.

De maximumwaarde is daarmee aanzienlijk (factor twee!) hoger dan de door IPCC gehanteerde maximum bovengrens van 0,59 meter. Ook houdt de commissie rekening met een toenemende winterneerslag, resulterend in een hogere piekafvoer van Rijn en Maas. De zomerneerslag daarentegen zou juist afnemen, hetgeen consequenties heeft voor de zoetwatervoorziening in droge zomers. De commissie verwacht overigens geen verzwaring van de stormcondities voor de Nederlandse kust. De voorgestelde maatregelen betreffen o.a. dijkverzwaring, zandsuppletie voor de kust, rivierwerken en peilverhoging van het IJsselmeer, en zijn door V&W overgenomen in het Nationaal Waterplan. Het plan is inmiddels vastgesteld door het Kabinet en zal dit voorjaar in de Tweede Kamer behandeld worden.

Oorzaak en tempo van de zeespiegelstijging is voor Nederland van cruciaal belang

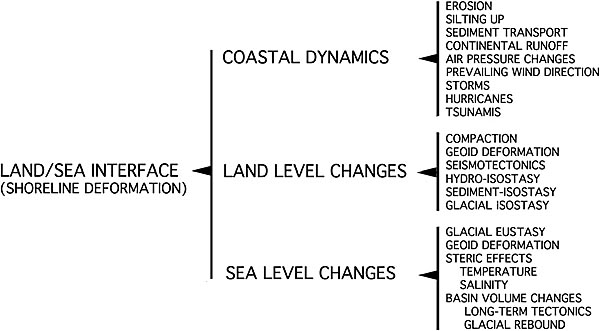

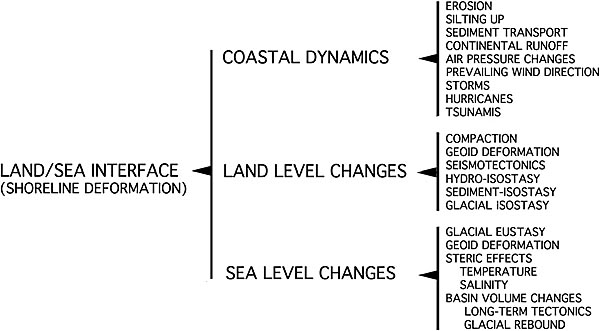

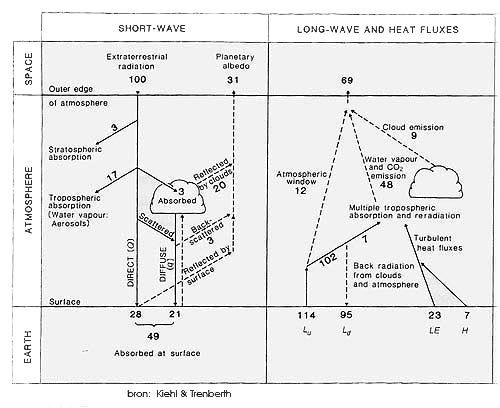

Zeespiegelstijging kan door verschillende factoren veroorzaakt worden. Direct aan de atmosferische opwarming gerelateerd zijn: de thermische uitzetting als gevolg van warmteopname in de oceanen en de massatoename als gevolg van smeltwater (minus aangroei) van ijskappen en gletsjers. Lokale verschillen kunnen optreden door variaties in oceaanstroming, dichtheidsverschillen, veranderend getij, verandering van het zwaartekrachtsveld op aarde, etc. Bovendien kan er lokaal sprake zijn van een (relatieve) zeespiegelstijging door bodemdaling. Dit laatste speelt bij de Nederlandse kust een belangrijke rol.

Eerst enkele gerapporteerde feiten en conclusies. IPCC constateert een mondiale zeespiegelstijging van ongeveer 18 cm gedurende de afgelopen 130 jaar, hetgeen overeenkomt met gemiddeld 1,4 mm/jaar. In de periode 1961-2003 zou de stijging 1,8 mm/jaar hebben bedragen. Ook suggereert IPCC dat er, op basis van satellietmetingen, sinds 1993 een versnelling is opgetreden tot 3,8 mm/jaar en stelt voorts dat de stijging ‘consistent is met de wereldwijde opwarming’. Deze stijging zou voor 57% veroorzaakt worden door thermische expansie en voor 28% door het afsmelten van ijskappen. De gemeten stijging bij de Nederlandse kust bedraagt sinds begin 20e eeuw ongeveer 17 cm (NB: volgens Deltacommissie en Planbureau voor de Leefomgeving 20 cm) oftewel 1,7 mm/jaar. Op het eerste gezicht lijkt dit in lijn te liggen met de wereldgemiddelde stijging die IPCC rapporteert. Deze getallen zinken overigens in het niet bij de natuurlijke variaties die we vroeger hebben gekend: zo stond de zeespiegel tegen het einde van de laatste grote ijstijd (20 duizend jaar geleden) zo’n 120 meter lager. Maar dat terzijde. Voor het jaar 2100 gaat IPCC in het – relatief ongunstige – emissiescenario A1F1 uit van een mondiale temperatuurstijging in 2100 van 4,0 °C (‘best estimate’) en een zeespiegelstijging van 0,26 tot 0,59 m. De bovengrens wordt voor ongeveer 70% (0,41 m) veroorzaakt door thermische uitzetting; 30% (0,18 m) is het saldo van afkalving en aangroei van gletsjers en de ijskappen op Groenland en Antarctica.

Bij de hierboven gerapporteerde feiten en conclusies kan onmiddellijk een aantal kanttekeningen geplaatst worden. In de eerste plaats worden de waterstanden in Nederland gemeten t.o.v. het referentievlak NAP. Maar dat referentievlak – gerelateerd aan de bovenkant Pleistocene zandlaag – daalt als gevolg van ‘postglaciale rebound’, tektoniek en compressie van diepe lagen. In west en noord Nederland bedraagt de daling van het referentievlak ongeveer 4 – 8 cm/eeuw. Niet duidelijk is of de metingen navenant zijn gecorrigeerd. Zo niet, dan zou de absolute zeespiegelstijging in de afgelopen eeuw maximaal slechts 9 – 13 cm hebben bedragen. Ook is het bekend dat de waterstanden langs de Nederlandse kust beïnvloed zijn door grote waterbouwkundige werken zoals de Afsluitdijk en Deltawerken. Om die reden maakt de Deltacommissie ook gebruik van metingen bij Norderney. Die laten overigens een stijging zien in dezelfde orde van grootte. Niet duidelijk is in hoeverre deze peilwaarnemingen (en de peilwaarnemingen waarop IPCC zich in algemene zin baseert) gecorrigeerd zijn voor een eventuele lokale daling van het betreffende referentievlak. Het is aannemelijk te stellen dat de gemeten (relatieve) zeespiegelstijging voor de Nederlandse kust voor een belangrijk deel veroorzaakt wordt door bodemdaling, daling van het referentievlak en verandering van het getij (hogere hoogwaters) en in mindere mate door de opwarming. Het is op zijn zachts gezegd merkwaardig dat op dit punt de Deltacommissie in zijn hoofdrapport voorbij gaat aan de conclusies van het in hun opdracht opgestelde ‘special report’.

Ten tweede is het opmerkelijk is dat in de trends bij de Nederlandse kust en bij Norderney géén sprake is van enige versnelling van de zeespiegelstijging zoals IPCC suggereert. Ook andere bronnen (o.a. University of Colorado) spreken dat tegen – die constateren juist een afvlakking gedurende de afgelopen vijf jaar. Dat beeld wordt bevestigd door de sinds 2005 gemeten vermindering van de warmteopname van de oceanen.

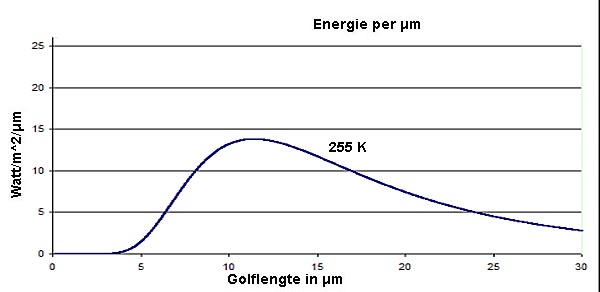

Ten derde moet onderkend worden dat de oceanen (ongeveer 70% van het aardoppervlak en een gemiddelde diepte van 3.800 meter) een immense warmtebuffer vormen en uitermate traag reageren op fluctuaties van de atmosferische temperatuur. Recente modelstudies laten zien dat atmosferische temperatuurstijging zeer langzaam doordringt in het diepere temperatuurprofiel van de oceanen. Bij thermische uitzetting is sprake van een ‘snelle’ (50 jaar) component die zich in de bovenste 300 meter afspeelt en een trage component (‘enkele honderden tot duizend jaar of meer’) op dieptes beneden 700 meter. De modelsimulatie laat zien dat de atmosferische temperatuurstijging van 0,8 °C sinds begin vorige eeuw een thermische uitzetting van slechts 4 cm teweeg zou hebben gebracht, aanzienlijk minder dan de conclusie van IPCC. Mogelijk hebben we ook nog te maken hebben met een naijleffect vanuit een ver verleden, bijvoorbeeld uit de kleine ijstijd . De ‘keerzijde’ is dat, indien de atmosferische temperatuur vanaf heden niet meer zou stijgen, de thermische uitzetting nog een tijdje doorgaat met nog eens 1,5 cm in 2100. Satellietmetingen over de periode 1993 – 2003 laten zien dat de zeespiegelvariatie grote regionale verschillen vertoont: in het oostelijke deel van de Pacific en het westelijke deel van de Indische Oceaan is sprake van een dalende trend; op het noordelijk deel van de Atlantic en de westelijke Pacific is juist sprake van een stijging (thermisch én totaal). De regionale verschillen worden mede veroorzaakt door ‘tijdelijke’ fenomenen zoals de 1997-1998 El Niňo.

Naast thermische uitzetting is er sprake van zeespiegelverandering als gevolg van het gedrag van gletsjers en ijskappen. Sinds de jaren ’40 is er bij de gletsjers sprake van een afname in de omvang die overeenkomt met een zeespiegelstijging van 2 tot 3 cm gedurende de periode 1940 tot 2000. De relatief snelle afname sinds de jaren ’70 lijkt consistent met de wereldwijde opwarming. In het laatste decennium van vorige eeuw is de afnamesnelheid verdubbeld tot een zeespiegelequivalent van 0,7 mm/jaar en lijkt daarna op dat niveau te stabiliseren. M.b.t. de ijskappen op Groenland en Antarctica is er sprake van ijsgroei op het centrale deel en van afkalving langs de randen. De vorige eeuw geeft voor Groenland een wisselend beeld in de massabalans, variërend (in zeespiegelequivalent) tussen een stijging met 0,07 mm/jaar tot een daling van 0,17 mm/jaar. Over de gehele eeuw gemeten, is de Groenlandse bijdrage aan de zeespiegel verwaarloosbaar klein. Sinds de jaren ’90 is er sprake van massaverlies, resulterend in een zeespiegelstijging van 0,3 tot 0,5 mm/jaar. De ijskap van Antarctica is de afgelopen eeuw gegroeid hetgeen heeft geresulteerd in een zeespiegeldaling van 2,0 cm. Na 2000 lijkt er sprake van een massaverlies dat overeenkomt met een zeespiegelstijging van 0,2 tot 0,5 mm/jaar. Geconcludeerd kan worden dat gedurende de vorige eeuw de afsmelt van Groenland en de kleinere gletsjers grotendeels is gecompenseerd door de ijsaanwas op Antarctica en er derhalve in geringe mate is bijgedragen aan de zeespiegelstijging. Echter, indien de trend van de jaren ‘90 (sterke mondiale opwarming) deze eeuw doorzet, zou dat leiden tot een stijging met ongeveer 20 cm. De sinds 2003 stabiliserende mondiale temperatuur geeft daar echter (vooralsnog) geen aanleiding toe.

Tenslotte is er een opmerkelijk verschil tussen de conclusies van IPCC (maximaal 0,59 meter) en de aanbevelingen van de Deltacommissie (maximaal 1,20 meter). Het verschil is onderbouwd in een aanvullend rapport naar bovengrensscenario’s, opgesteld door wetenschappers die ook bij IPCC betrokken zijn. Kleine verschillen (tot 10 cm) zijn er ten aanzien van de thermische uitzetting, de bijdrage van kleine gletsjers en terrestrische wateropslag. Het grote verschil zit in het gedrag van de Groenlandse en Antarctische ijskap: kans op extra ijsuitstroom vanwege snelle dynamische processen en de instorting van de Amundsen Sea Embayment op West Antartica. Beide fenomenen zijn echter, zo stelt de commissie, uitermate onzeker. In het bovengrensscenario is er desondanks wél rekening meegehouden.

Geconcludeerd moet worden dat de analyse van de zeespiegelstijging (relatief versus absoluut) voor de Nederlandse kust de nodige vraagtekens oproept. Het ziet er naar uit dat gedurende de 20e eeuw de zeespiegelstijging als gevolg van de opwarming aanzienlijk kleiner is dan verondersteld. Omdat de trend van de 20e eeuw semi-empirisch wordt door geëxtrapoleerd naar de 21e eeuw, is er sprake van overschatting van de problematiek. Bovendien is het gedrag van oceanen complex, met als gevolg dat een voorspelling – welke dan ook – uitermate onzeker is. Een troost is dat processen dermate traag verlopen dat er op korte termijn niet drastisch hoeft te worden ingegrepen. De conclusie van IPCC dat de zeespiegelstijging (volledig) consistent is met de opwarming van de aarde over dezelfde periode, lijkt voorbarig; de presentatie in één grafiek (IPCC Synthesis Report, blz 31) zet politieke besluitvormers op het verkeerde been. Hetzelfde is ook van toepassing op de voorbarige constatering van het Planbureau voor de Leefomgeving (VROM) en de Deltacommissie dat de zeespiegelstijging [ad 20 cm] voor de Nederlandse kust geheel door de opwarming zou zijn veroorzaakt.

Neerslag en afvoerregiem grote rivieren

Volgens IPCC manifesteert de klimaatverandering in NW Europa zich door een 10 – 20% hogere winterneerslag en een 10 – 20% lagere zomerneerslag. De hogere winterneerslag heeft consequenties voor de voorjaarsafvoer en hoogwaterstand van de grote rivieren. De Deltacommissie concludeert dat de piekafvoer van de Rijn met 6% – 38% kan toenemen in 2100. De maatregelen die Nederland moet nemen zijn mede afhankelijk van maatregelen die bovenstrooms (Duitsland) getroffen worden. De lagere zomerafvoer – in combinatie met het verhoogde risico van zoutintrusie door de hogere zeespiegel – heeft gevolgen voor de zoetwaterhuishouding in o.a. Zuid West Nederland. De commissie adviseert het IJsselmeerpeil met maximaal 1,5 meter te verhogen teneinde onder vrij verval op de (verhoogde) Waddenzee te kunnen blijven spuien én de zoetwatervoorraad te vergroten met het oog op langdurige droge zomers. Ook hier kunnen kanttekeningen geplaatst worden. De temperatuur in West Europa (waaronder in De Bilt) is gedurende de afgelopen eeuw sneller gestegen dan gemiddeld op het noordelijk halfrond. De totale jaarlijkse neerslagsom is ook gestegen, met name als gevolg van de (gemeten) hogere winterneerslag. Opmerkelijk is echter dat er – ondanks de opwarming – geen sprake is van een lagere zomerneerslag. Dit uit zich ook in de meerjarige afvoergemiddelden van Rijn en Maas: in vergelijking tot de eerste helft van de vorige eeuw zijn de winter/voorjaarsafvoeren in de tweede helft van die eeuw inderdaad toegenomen, maar is er niet of nauwelijks sprake van lagere zomer/najaarsafvoeren en dus de zoetwatervoorziening vooralsnog niet in het geding is.

Conclusies en aanbevelingen

De bescherming van ons land tegen hoogwater is iets waarmee niet lichtzinnig mag worden omgesprongen. Maar tegelijkertijd moet gewaakt worden voor overschatting van de problematiek. De indruk bestaat dat daar sprake van is. Want de maatregelen voor een klimaatbestendig Nederland zijn mede gebaseerd op onvolledige dan wel incorrecte historische analyse over de 20e eeuw en weinig rooskleurige toekomstprojecties van IPCC voor de 21e eeuw die – zoals al langer bekend – niet kamerbreed gedragen worden en die – zoals recentelijk is gebleken – niet altijd waardevrij zijn. De Deltacommissie heeft vervolgens de door IPCC gehanteerde projectie voor de maximum zeespiegelstijging met een factor twee verhoogd door een aantal onzekerheden om te zetten in aanvullende bovengrenswaarden. De resulterende maatregelen zoals opgenomen in het Nationaal Waterplan zijn niet alleen kostbaar maar vergen ook veel van onze schaarse ruimte. Terecht hanteert de commissie een ‘low probability/high impact’ filosofie. Maar gelukkig komt de klimaatverandering niet met tsunamisnelheid op ons af en zal in de toekomst, door verder wetenschappelijk onderzoek en monitoring, geleidelijk aan een beter zicht ontstaan op de werkelijke omvang van de ‘probability’ van klimaatverandering en de gevolgen daarvan voor onze zeespiegel en afvoerregimes van de grote rivieren. Voorkómen dient te worden dat er nu een tunnelvisie ontstaat waarin de voorgestelde maximum bovengrenswaarden kritiekloos geïnterpreteerd worden als een rigide toetsingsnorm voor bestaande en nieuwe grote waterbouwkundige werken. Beter ware het óók rekening te houden met scenario’s waarin de zeespiegel (in absolute zin) aanzienlijk minder snel stijgt dan de nu gehanteerde bovengrens. Tenslotte wordt aanbevolen dat politieke besluitvormers een beroep kunnen doen op een onafhankelijke (lees: los van IPCC en PBL), pragmatisch ingestelde, multidisciplinaire adviesgroep die in staat is het internationaal onderzoek naar de oorzaken en gevolgen van klimaatverandering te vertalen in adequate maatregelen voor Nederland.

De analyse inzake oorzaak en snelheid van de zeespiegelstijging in onze regio is nog omgeven is door vele vraagtekens. Nader onderzoek is op zijn plaats. Maar vooralsnog ziet het er niet naar uit dat we in de buurt gaan komen van de maximale bovengrenswaarde waar de Deltacommissie voor het jaar 2100 rekening mee houdt: 120 cm oftewel gemiddeld 12 mm/jaar!

De zeespiegel en het gravitatie-effect

Vanaf 1985 werkt men voor wat betreft de zeespiegelmetingen samen in een internationaal programma, GLOSS genaamd (Global Sea Level Observing System). Hierin werken een aantal zeemeetcentra samen, zoals PSMSL (Permanent Service for Mean Sea Level), BODC (British Oceanographic Data Centre) en UHSLC (University of Hawaii Sea Level Centre). Op onderstaand kaartje is de spreiding van de 290 meetstations van GLOSS te zien. De spreiding is erg ongelijkmatig, met – erfenis van het verleden – vooral veel kuststations. Maar GLOSS gebruikt tegenwoordig ook de satellietgegevens als aanvulling op de meetstations. ( Bron: GLOSS )

Het gemiddeld zeeniveau is een lastig begrip, omdat, anders dan men zou vermoeden, het water in zeeën en oceanen niet fraai op 1 niveau staat, zoals het water in een glas. Er zitten allerlei bulten en laagtes in, soms lokaal, soms zich uitstrekkend over een paar duizend kilometers, en soms zelfs over nog grotere gebieden. Een aantal van die bulten en dalen hebben een zekere periodiciteit, van enkele minuten tot een aantal jaren. De bekendste daarvan is de getijdenwerking als gevolg van de aantrekkingskracht van maan en zon. De rotatie van de aarde rond zijn as veroorzaakt ook een bult, de zogenaamde Chandler wobble. Maar ook allerlei andere zaken zorgen ervoor dat het zeeniveau lokaal of regionaal ongelijk is. Bekend is het ontstaan van tsunami’s als gevolg van aardbevingen, maar ook stormen, El Niño/La Niña, luchtdrukverschillen, neerslag en verdamping, periodiciteit in de dichtheid van water (temperatuur en zoutgehalte) en zaken als veranderende zeestromen kunnen het water doen opbollen of zakken. Kortom: het valt nog niet mee om het gemiddelde zeeniveau te bepalen. Kijk maar eens op het kaatje hieronder, dat het verschil in zeeniveau weergeeft tussen 1993 en 2008. De conclusie is duidelijk: er is geen uniforme zeespiegelstijging.

Bron: NASA/JLP

Bron: NASA/JLPDe in de grafiek weergegeven zeespiegelstijging is dus sterk afhankelijk van de positie op aarde. Op wit ingekleurde locaties steeg de zeespiegel 10 millimeter per jaar, in de paarse gebieden trad een zeespiegeldaling op van 5 millimeter per jaar. Stel nu eens dat alle bovengenoemde effecten uitgeschakeld zijn, dan gedraagt het water in de oceanen en zeeën zich nog steeds niet zoals in een glas. De oorzaken daarvan zijn isostasie, verticale bewegingen van de aardkorst als gevolg van bijvoorbeeld afsmelten van landijs of gebergtevorming, en het zogenaamde gravitatie-effect.

Wat isostasie doet kan men goed waarnemen in Scandinavië. Vanwege het afsmelten van het landijs na de Weichselijstijd (vanaf 10.000 jaar geleden) veert het – ontdaan van de loodzware last van het ijs – stevig op. Rond de Botnische golf liggen oude stranden die momenteel ver boven het huidige wateroppervlak uitsteken. De Höga Kusten/Kvarken rond de Botnische Golf is sinds de laatste ijstijd 285 m. omhoog gekomen ten opzichte van het huidige zeeniveau. En dan te bedenken dat het zeeniveau sindsdien zo’n 120 m gestegen is! Het laatste uur voor de Botnische Golf en de Oostzee is derhalve geslagen: door de isostatische opheffing zal de verbinding met de Noordzee tussen Denemarken en Zweden over niet al te lange tijd verlanden, en de Oostzee/Botnische Golf zullen meren worden. Datzelfde lot is vanwege dezelfde reden ook de Hudsonbaai in Oost-Canada beschoren, tenzij de volgende ijstijd snel aanbreekt. De isostatische uplift aan de zuidrand van de Hudsonbaai is zo’n 272 m. ten opzichte van het huidige zeeniveau. Hieronder een foto van de Höga Kusten. De toppen van de heuvels aan de overkant van de baai lagen 10.000 jaar geleden op zeeniveau.

Het gravitatie-effect is minstens zo spectaculair als isostasie. Daar waar grote massa’s aanwezig zijn wordt water aangetrokken, zoals de maan aan het zeewater trekt. Op onderstaande tekening is te zien hoe dat gaat.

Bron: Jerry Mitrovica & Natalya Gomez, University of Toronto

Bron: Jerry Mitrovica & Natalya Gomez, University of Toronto

Door het afsmelten van een grote landijskap veert de aardkorst enigszins terug als gevolg van isostasie. Door het verdwijnen van de grote massa landijs daalt het zeeniveau relatief gezien in de nabijheid van de vrogere ijsmassa, en stijgt het relatief op grotere afstand. Deze bewegingen zijn relatief, omdat uiteraard het afsmelten van een grote hoeveelheid landijs, zoals bijvoorbeeld het Groenlands ijs, per saldo het zeeniveau overal zal laten stijgen. Alleen de mate waarin hangt dus af van de afstand tot de ijsmassa. Over die afstanden waarop het zeeniveau relatief daalt of stijgt, is al veel bekend.

Op onderstaande tekening is te zien wat het verdwijnen van een landijsmassa inhoudt voor de zeespiegel. Geofysicus Bert Vermeersen van de TU Delft heeft berekend dat vanwege het gravitatie-effect bij afsmelten van landijs de zeespiegel tot op een afstand van 2200 km zal dalen. Tussen 2200 km en 6700 zal het niveau stijgen, maar minder dan op basis van het afgesmolten ijs zou mogen verwachten indien het water zich zou gedragen als in een glas water. Vanaf 6700 km zal het zeeniveau sterker stijgen dan verwacht. (Vermeersen, A.A.J., Effects of ice-melt induced gravity changes and solid earth deformation in the Netherlands, Netherlands Journal of Geosciences (Geologie en Mijnbouw), 87 (3), 215, September 2008.)

In de tekening is de rode lijn 1 het zeeniveau met ijskap, lijn 3 het zeeniveau met ijskap indien er geen gravitatie-effect ziu zijn, en lijn 2 het zeeniveau na het afsmelten van het landijs. De afstanden van 2200 km en 6700 km zijn vaste afstanden, en gelden ongeacht de hoeveelheid ijs dat afsmelt.

Wat betekent dit nu voor het zeeniveau als er bijvoorbeeld 1 mm landijs afsmelt? Onderstaande kaartjes geven een beeld van de zeespiegelstijging in mm die dan optreedt. Het bovenste kaartje toont de niveauverandering als er 1 mm ijs van Antarctica afsmelt, het onderste kaartje als er 1 mm ijs van Groenland afsmelt. Bron: Mitrova c.s. (Mitrova et al, Recent mass balance of polar ice sheets inferred from patterns of global sea-level change, Nature 409, 1026-1029 , 2001).

Wat betekent een en ander nu voor Nederland? Nederland bevindt zich ten opzichte van Groenland in de zone tussen 2200 en 6700 km. Als al het landijs op Groenland zou smelten dan zou dat een gemiddelde zeespiegelstijging van ongeveer 7m veroorzaken. Maar vanwege het gravitatie-effect blijft stijging aan de Nederlandse kust beperkt tot 2m . Nederland ligt immers in de zone tussen de 2200 km en 6700 km verwijderd van Groenland. Een lichte ophoging van de zeeweringen zou de zaak hier aardig onder controle houden. Maar van afsmelten van de Groenlandse ijskap is geen sprake. Op het kaartje hieronder (bron Mitrova et al, 2001) is te zien wat het relatieve effect is als al het landijs van Groenland zou smelten. Donkerblauw is de zone waarin het zeeniveau zal dalen, terwijl de sterkste stijgingen (donkerrood) op het Zuidelijk Halfrond te vinden zijn.

Een geheel ander verhaal wordt het als al het ijs van Antarctica zou smelten. Dan zou het zeeniveau in onze contreien tientallen meters stijgen. Gelukkig is er geen enkele aanwijzing dat dat staat te gebeuren. Net zomin trouwens als het afsmelten van de IJslandse gletsjers, want dat zou een zeeniveaudaling in onze omgeving veroorzaken!

De zeespiegel en het klimaat

In een recent artikel van Kemp et al wordt een reconstructie van het zeeniveau van de afgelopen 2100 jaar uitgevoerd op basis van proxies uit twee kustmoerassen in North Carolina. Vervolgens tonen de onderzoekers aan dat voor tenminste de afgelopen 1000 jaar de zeespiegelstijging correleert met het globale temperatuurverloop. Althans, dat is wat de auteurs beweren. In onderstaande grafieken is een en ander aanschouwelijk gemaakt.

Een van die auteurs is Michael Mann, bekend van de hockeystickgrafiek. Geen wonder dan ook dat de publicatie op extra belangstelling mocht rekenen van diegenen die het klimaat kritisch volgen. En kritiek kwam er, zowel op de reconstructie van het zeeniveau als op de gebruikte temperatuurdata.

Laten we eerst eens naar de reconstructie van het zeeniveau kijken. De auteurs concluderen op basis van de studie dat er een viertal periodes te onderscheiden zijn:

a) van 100 v. Chr. tot 950 n.Chr. een stabiele zeespiegel

b) van 950 n.Chr. tot 1350 n.Chr. een stijging met 0,6 mm/jaar

c) van 1350 n.Chr. tot ongeveer 1880 n.Chr. stabiel en licht dalend

d) van ongeveer 1880 tot heden 2,1 mm/jaar

Voor een inleiding in de materie leest men bijvoorbeeld deze site, hoofdstuk “De Feiten” en dan “Zeespiegelstijging”. Het is dan al snel duidelijk dat van ‘één zeespiegel’ geen sprake is. Allerlei factoren hebben invloed op de zeespiegel, zodat men beter van regionale zeespiegel kan spreken dan van een mondiale, zeker in een relatief korte tijdsspanne.

Onderhavige studie baseert de reconstructie van het zeeniveau op een aantal sedimentboringen op een tweetal plaatsen, vlak bij elkaar gelegen aan de oostkust van de USA. Tot voor kort, voordat de satelliet zijn intrede deed, was men uitsluitend aangewezen op onderzoek langs de kust. Dat juist dergelijk kustonderzoek voor extra complicaties zorgt is bekend. Mörner (2010) vat de problemen die kunnen ontstaan bij een reconstructie van het zeeniveau langs de kust bondig samen in onderstaande figuur.

Bron: Mörner

Bron: Mörner

Zoals op het kaartje goed te zien is, is de kust van North Carolina een sedimentatiekust, met strandwallen, en een achterliggend waddengebied, het haf. Eigenlijk is deze situatie heel goed vergelijkbaar met onze eigen kust in West en Noord Nederland. Net als in North Carolina is in ons haf op den duur veen ontstaan (Hollandveen). Dergelijke kusten zijn zeer dynamisch van aard (zie bovenstaand figuur) waardoor het zeer lastig is het zeeniveau te reconstrueren. Bovendien is het extra lastig op basis van de veenafzettingen dergelijk onderzoek te doen omdat veenafzettingen organisch van aard zijn, en te maken hebben met inklinken, mar ook met andere geochemische reacties.

De auteurs zeggen over de betrouwbaarheid van deze data: “Agreement of geological records with trends in regional and global tide-gauge data (Figs. 2B and 3) validates the salt-marsh proxy approach and justifies its application to older sediments. Despite differences in accumulation history and being more than 100 km apart, Sand Point and Tump Point recorded near identical RSL variations.”

Eschenbach heeft in een bijdrage voor WUWT uitgezocht of de salt-marsh proxy approach in de studie inderdaad gerechtvaardigd wordt door nabijgelegen getijdedata. In bovenstaande figuur zijn de 2 nabijgelegen getijdemeetpunten weergegegeven, namelijkHampton Roads en Wilmington.

Van de eerste gaan de data terug tot 1927, van de tweede tot 1935. Bovendien heeft Eschenbach de satellietgegevens van TOPEX

gebruikt die lopen vanaf 1992. In onderstaande figuur zijn alle data bijeengebracht om te zien of “global tide-gauge data (Figs. 2B and 3) validates the salt-marsh proxy approach and justifies its application to older sediments” zoals de auteurs beweren.

Opvallend is dat de gemiddelde zeespiegelstijging van Wilmington 2 mm/jaar is, terwijl die van Hampton Roads 4,5 mm/jaar is. Beide meetpunten liggen nog geen 300 km van elkaar. Overigens een prachtig bewijs dat Mörner gelijk heeft. Maar de grafiek laat tevens zien dat beide getijdedatareeksen zo ver uiteen lopen dat van een ‘valitation’ van de gebruikte aanpak geen sprake kan zijn. Zeker als men in daarbij de verschillen tussen de gekozen meetpunten Tump Point en Sand Point betrekt: de zeespiegelstijging van het eerste is bijna 50% groter dan van de laatste.

Eschenbach vat dit zo samen: ” We don’t have good observations to compare with their results, so virtually any reconstruction could be claimed to be “validated” by the nearby tidal gauges. In addition, since the Tump Point sea level rise is nearly 50% larger than the Sand Point rise, how can the two be described as “near identical” ?” . Overigens vertoont de recente satellietmeting van TOPEX een gemiddelde stijging vanaf 1992 van 0,5 mm/jaar.

Het tweede probleem betreft de gebruikte temperatuurreconstructie. Die stamt uit een publicatie uit 2008 van Michael Mann, een van de auteurs. En die reconstructie heeft behoorlijk wat kritiek gekregen sinds de publicatie. Een van de zwaarste punten van kritiek is dat Mann de proxies van Tiljander gespiegeld heeft gebruikt. Zie onder andere hier en hier. Amac gaf in 2009 al een uitgebreid overzicht over de discussies over de kwestie.

Een voorzichtige conclusie is dat de manier waarop Mann de 3 Tiljander datareeksen heeft gebruikt zeer omstreden is. Waarom de auteursploeg dan toch deze reconstructie heeft gebruikt in deze studie is de grote vraag. Dat is het zeker omdat een van de auteurs, Martin Vermeer, in een verhit debat op een klimaatblog een opmerkelijke uitspraak doet. Op een opmerking van Steve Mosher dat, indien het (volgens Vermeer) voor de resultaten niet uitmaakt of je de proxiedata van Tiljander al of niet omgekeerd gebruikt, het dan beter zou zijn om de grafiek met de juiste oriëntatie toe te passen, antwoordt Vermeer: “I would agree with you when starting from scratch. But for an existing paper you have to be reponsive to issues brought up by showing how they affect the reported results. If they completely undermine them, you have to retract; short of that, completely rewriting the paper is not usually an option. BTW I would have left out these questionable proxies. But it’s a judgment call, and Mann made this choice.”

Waarom Vermeer bij de publicatie van het recente artikel over de zeespiegel er niet op aangedrongen heeft de omstreden proxies niet te gebruiken, is onbekend. Misschien heeft hij dat wel gedaan, maar is Mann’s invloed van doorslaggevende invloed geweest. Van dat laatste is onderstaande figuur uit het bekende Wegman Report illustratief. De machtige positie van Michael Mann in het wereldje van de paleoklimatologen is in een klap duidelijk:

Bron: Wegman Report

Warmte-inhoud van oceanen zegt iets over klimaatgevoeligheid.

Oceanen nemen ruim 70% van de totale opppervlakte van de aarde voor hun rekening. Oceanen zijn vanwege hun fysische eigenschappen in staat om veel grotere hoeveelheden energie te bufferen dan de continenten en de biosfeer. Zie hier in kort bestek de ingrediënten voor een toenemende belangstelling voor oceanen in de discussie over ‘global warming’.

Natuurlijk wisten we al veel langer dat oceanen een belangrijke factor vormen in het klimaatsysteem van de aarde, maar de overdreven belangstelling voor broeikasgassen in de energiebalans van de aarde heeft lange tijd de aandacht vooral gefocused op de temperatuur aan het aardoppervlak. Daarbij speelde en speelt de SST (sea surface temperature) een belangrijke rol. De laatste jaren is er een toenemende belangstelling voor de temperatuur in dieper water dan de SST. Met name de ontwikkeling van de ARGO-programma heeft hiertoe een flinke stimulans geleverd. Lees hierover in de “Nulhypothese Clark” in het hoofdstuk “Nieuwe Inzichten”.

De (meeste) oceanen bestaan thermisch bezien uit 4 lagen. Bovenin een laag van ongeveer 50m dik waarbij de temperatuur sterk gekoppeld is aan de temperatuur van de onderste luchtlagen als gevolg van warmteoverdracht en menging. Daaronder een ‘spronglaag’ of thermocline : van 50 meter tot 200 meter diep, ontbrekend in de poolzeeën. Het is een menglaag met o.a. door de seizoenen sterke verschillen in temperatuur. Daaronder de laag van 200m tot 2 km diep met een relatief stabiele overgang van hogere temperaturen naar de stabiele lage temperaturen van de diepzee. En tenslotte de diepzee (dieper dan 2 km) met constante temperaturen rond 0° C.

Roy Spencer van de UAH heeft onlangs een interessant onderzoek gedaan naar de zogenaamde ‘heat content’ van de bovenste 700m van de oceanen . In het Nederlands is ‘heat content’ de warmte-inhoud. Dat is de totale hoeveelheid warmte die opgeslagen is in een bepaalde hoeveelheid water ((standaard 1 kg) bij een bepaalde temperatuur. De warmte-inhoud van water is het aantal graden x de soortelijke warmte (4,19 kJ/kg.K). Eén kg water van 20° C heeft dus een warmte-inhoud van 20 x 4,19 = 83,8 kJ.

In bovenstaande figuur is de warmte-inhoud-anomalie vanaf 1955 t/m 2008 weergeven, zoals berekend door Levitus e.a. (2009). De stijging ziet er fors uit, maar het gaat dan ook om een enorme hoeveelheid zeewater. We zien een stijging tussen begin jaren ’70 tot 2003, waarna er een stabilisatie optreedt. Stijging en daling in de warmte-inhoud vinden plaats als er een onbalans is tussen inkomende en uitgaande straling. De data die door Levitus werden gebruikt komen uit een aantal bronnen. Daarbinnen zijn de berekeningen van de SST erg belangrijk. Levitus heeft om zekerheid te hebben over de betrouwbaarheid van de berekende warmte-inhoud van de bovenste 700m een vergelijking gemaakt tussen de 3 databronnen voor de SST. (Levitus 2008)

Daarbij valt op dat de datareeksen van NCDC, Hadley Centre en WOD05 uitstekend overeenkomen. Spencer heeft op basis van bovenstaande tijdreeks uit de eerste figuur van Levitus berekend hoeveel extra energie er per jaar het systeem in dan wel uit gegaan is. Een relatief simpele rekensom als je de verandering van de warmte-inhoud weet en de totale oppervlakte van de oceanen. Hij komt uit op een toename van de inkomende straling van 0,2 W/m^2 voor de totale periode 1955-2010. Dat komt goed overeen met de berekening die Levitus e.a. ook maakten in hun publicatie uit 2009. Omgerekend betekent dit een temperatuurtoename van de bovenste 700m van 0,17° C voor de totale periode 1955-2008.

Het bijzondere aan die temperatuurstijging van 0,17° C is dat deze ver achter blijft bij de HadSST (SST door Hadley Centre) , die voor delfde periode een temperatuurtoename van 0,6° C claimt. Tot zover niet heel spectaculair, zou je zeggen. Maar dan gaat Spencer iets heel aardigs doen. Hij bekijkt van jaar tot jaar het verschil in warmte-inhoud, en berekent vervolgens hoeveel energie er nodig was om die jaarlijkse verschillen te veroorzaken. Hij vergelijkt dan zijn uitkomsten met enkele grafieken van de hand van James Hansen, kopstuk bij GISS/NASA. Hansen publiceerde die grafieken in 2007 in een studie genaamd: Dangerous human-made interference with climate: a GISS modelE study .

In de eerste grafiek is van een aantal forcings voor de periode 1880-2003 de invloed weergegeven op de stralingsbalans. De tweede grafiek is het netto resultaat van al die forcings. Omdat de grafieken van Hansen slechts t/m 2003 lopen heeft Spencer voor de laatste jaren van het afgelopen decennium alle forcings op een na onveranderd gehouden, alleen het CO2-gehalte heeft hij op basis van recente metingen laten stijgen.

Bron: www.drroyspencer.com

Bron: www.drroyspencer.com

Voor de periode 1955-2010 berekent Spencer op basis van de grafieken van Hansen een gemiddelde toename van de ‘radiative forcing’ van 0,8 W/m^2, terwijl in dezelfde periode de warmte-inhoud met ‘slechts’ 0,2 W/m^2 is toegenomen. Hoe kan dat ? Waar zijn die andere 0,6 W/m^2 gebleven? Spencers antwoord hierop is: feedback. Feedbacks in de vorm van verandering in bewolking, waterdamp en extra output van warmtestraling als gevolg van opwarming. Die extra output van warmtestraling noemt Spencer ‘THE main climate stabilizing influence’. Ik permitteer me de vrijheid om bij dat laatste eerder te denken aan extra latente energie en convectie als gevolg van opwarming dan aan extra stralingsenergie, hoewel dit laatste uiteraard ook zal plaatsvinden. Zie voor dit laatste ook de ideeën van Noor van Andel, Miskolczi en Clark in het hoofdstuk ‘Nieuwe Inzichten’. Conclusie: het klimaatsysteem van de aarde is veel minder gevoelig voor forcings zoals CO2-stijging dan gedacht door het IPCC.

Bron: www.drroyspencer.com

Bron: www.drroyspencer.com

Met behulp van een eenvoudig fysisch model tracht Spencer tenslotte de feedback-parameter λ zodanig te parameteriseren dat de ‘radiative imbalance’ zo goed mogelijk overeenkomt met de gemeten toename van de warmte-inhoud met 0,2 W/m^2. Zie bovenstaande figuur. Let op het feit dat in het model de sterke feedback de forcing grotendeels neutraliseert, zoals de toename van de warmte-inhoud met 0,2 W/m^2 reeds indiceerde. Daarbij komt hij uit op een grootte van de feedback parameter λ van 4 W/m^2K, resulterend in een klimaatgevoeligheid van slechts 1° C bij verdubbeling van het atmosferische CO2-gehalte. Veel lager dus dan de door het IPCC gehanteerde gemiddelde toename van de temperatuur met 3° C.

Van diverse zijden is commentaar geleverd op bovenstaande uitkomsten, met name op het feit dat Spencer ‘slechts’ de bovenste 700m van de oceaan heeft bekeken. In een update op bovenstaand onderzoek heeft hij daarom zijn forcing-feedback model opnieuw laten lopen met de volgende 2 aanpassingen:

1) een netto opwarming over 50 jaar van 0,06° C voor de 0-2000m bovenste laag

2) een opwarming over dezelfde periode van 0,6° C van de SST

Het resultaat is een netto feedback parameter van 3W/m^2k, corresponderend met een klimaatgevoeligheid van 1,3° C bij verdubbeling van CO2, nog steeds ruim onder de gemiddeld 3° C van het IPCC, en zelfs onder de onderste limiet van 1,5° C die het IPCC voor toekomstige opwarming hanteert.

Tot slot: In de grafiek van de warmte-inhoud is te zien dat vanaf 2003 er sprake is van een stagnatie in de toename ervan, een stagnatie die tot op de dag van vandaag stand houdt. Het is wellicht interessant om dat verschijnsel in de nabije toekomst eens nader onder het licht te houden.

Nogmaals de zeespiegel

In de bijdrage van 25 november j.l. is de zeespiegelstijging aan de orde geweest naar aanleiding van opmerkingen van meteoroloog van den Berg. Hij stelt in een brochure van het KNAG ter introductie van de lezing die hij op 8 december a.s. gaat houden: “Te midden van onzekerheden zijn er wel degelijk een paar grote zekerheden. De aarde warmt op, het ijs smelt steeds sneller, en de zeespiegel reageert als verwacht, en stijgt dus steeds sneller. “ . Over die steeds sneller stijging van de zeespiegel heb ik toen geschreven dat dat niet waar was. Interessant is natuurlijk ook de vraag of de reactie van de zeespiegel op een versnelde ijssmelt een versnelde stijging is.

De bekende Duitse klimatoloog Hans von Storch noemde een publicatie over de zeespiegel van de hand van een aantal Duitse onderzoekers als een van de voor hem 6 belangrijkste klimatologische publicaties van 2010 en 2011. Het gaat om publicaties van Thomas Wahl en zijn team.

Thomas Wahl et al hebben in 2010 inderdaad een interessante publicatie het licht laten zien over de zeespiegelstijging in de Duitse Bocht sinds 1840. In 2011 hebben ze in een nieuwe publicatie de data van hun eerdere publicatie uit 2010 verder verfijnd en verbeterd.

Wat ze gedaan hebben is het maken van een reconstructie van de zeespiegelstijging in de Duitse Bocht van 1843 tot 2008, een periode van 166 jaar. Nu gaat het hier niet om die grafiek van de zeespiegel in de Duitse Bocht, en ook niet om de overigens interessant techniek met behulp waarvan ze de reconstructie hebben gemaakt. Het gaat om onderstaande grafiek uit het tweede rapport.

De grafiek geeft niet de trend in de zeespiegelhoogte weer, maar de jaarlijkse veranderingen. Kijk eens goed naar de rode lijn, die de SLR (Sea Level Rise) in mm/jaar weergeeft. Er zijn 3 periodes waar te nemen waarin sprake is van een versnelling van de zeespiegelstijging. De eerste is een stijging tussen 1855 en 1880, waarin de SLR toeneemt van 0 mm/jaar tot bijna 3 mm/jaar. De tweede acceleratieperiode loopt van 1925 tot 1947; de stijging ging toen van 0,5 mm/jaar tot 3,4 mm/jaar. De laatste acceleratiefase begint 1970 en eindigt in 1996 , de SLR stijgt dan van 0,8 mm/jaar tot 3,6 mm/jaar. Na elke acceleratiefase volgt een periode van deceleratie en daalt de SLR naar waarden tussen 0 en 1 mm/jaar. Als we de Hadcrut globale temperatuurreeks er bijhalen, dan zien we een opvallende correlatie tussen het verloop van de gemiddelde wereldtemperatuur en de SLR.

Bron: HadCrut

Als er sprake is van een acceleratie van de luchttemperatuur aan het aardoppervlak, dan volgt met een lichte vertraging ook een acceleratie van de SLR.

In de bijdrage van 6-9-2011 is de sterke correlatie tussen de globale temperatuurreeks van HadCRut en de watertemperatuurreeks van het noordelijk deel van de Atlantische Oceaan aan de orde geweest. De vraag was toen welke van de twee domeinen, oceaan of atmosfeer, de sturende kracht is binnen deze correlatie. Nienke te Raa (IMAU 2006) schreef in het blad Meteorologica hierover: “…wat veroorzaakt deze Atlantische Multidecadale Oscillatie? Eerder onderzoek heeft uitgewezen dat veranderingen in de atmosfeer waarschijnlijk niet de oorzaak zijn van de AMO, maar het gevolg. Onze hypothese was dan ook dat dit verschijnsel het gevolg is van interne wisselwerkingen in de oceaan. ”. Zie voor verdere details hierover de bijdragen uit augustus en september 2011.

Conclusie: er is weliswaar sprake van een acceleratie van de SLR tussen 1970 en 1996, maar een vergelijkbare stijging deed zich ook voor tussen 1855 en 1880, en tussen 1925 en 1947. De meest recente acceleratie van de SLR koppelen aan versnelde afsmelt van ijs is derhalve mijns inziens puur speculatief. Van beide eerste acceleratieperiodes is niets bekend over een versnelde afsmelt van landijs, en gletsjers die korter worden kennen we al vanaf 1800.

De koppeling tussen de zeespiegel en het afsmelten van ijs is veel complexer is dan van den Berg suggereert. In 2010 publiceerde Kahn et al een studie naar de massabalans van het Groenlandse ijs met behulp van satellietgegevens van GRACE en GPS tussen 2002 en 2010. De conclusie was dat het landijs in Z. Groenland vanaf eind 2003 en vanaf eind 2005 ook in NW Groenland versneld aan het afsmelten is.

Bekijken we de meest recente data van de zeespiegel van de universiteit van Colorado in de figuur hier boven, dan is van die versnelling van afsmelt in Groenland in het verloop van de zeehoogte niets te merken. De stijging van het gemiddeld zeeniveau vlakt zelfs sinds 2005 af. Waaruit maar eens blijkt hoe ingewikkeld het oceaan-atmosfeersysteem in elkaar zit. Het kan natuurlijk ook wat te maken hebben met de methode die Kahn et al hebben gebruikt. Misschien daar later meer over.

Professor Pier Vellinga door de bocht

Dat Pier Vellinga van de Universiteit Wageningen het soms niet zo nauw neemt met meetgegevens is hier al eens eerder onderwerp van bespreking geweest. Vellinga heeft een boodschap te verkondigen, en dan heiligt het doel klaarblijkelijk de middelen.

Gisteren was het weer zo ver. In de aardige televisiereeks over de Waddenzee mocht Vellinga iets vertellen over de zeespiegelstijging en uiteraard de gevaren daarvan in het kader van de door hem gevreesde opwarming. Die uitzending kan hier bekeken worden.

Bron: NCRV uitzending gemist

Op het screenshot hierboven geeft Vellinga aan hoe groot de zeespiegelstijging is geweest in de Waddenzee vanaf de oplevering van de Afsluitdijk in 1932. Ik schat de afstand tussen zijn handen op ongeveer 60 cm. Dat leek met wat overdreven.

In Den Helder wordt al sinds jaar en dag de hoogte van de zeespiegel bijgehouden. Op de site van Rijkswaterstaat is via de webapplicatie Waterbase deze meetreeks van jaar tot jaar tot in detail te volgen.

Op onderstaande grafiek is zijn de maandelijkse gemiddelde zeehoogten in Den Helder weergegeven van 1865 tot 2000. In die periode is de relatieve zeespiegelstijging 14,4 cm/eeuw. Ongeveer 5 cm van deze stijging komt voor rekening van bodemdaling in Noord Nederland als gevolg van het opveren van Scandinavië na de laatste ijstijd. Dat betekent dat de eustatische zeespiegelstijging in Den Helder tussen 1865 en 2000 neerkomt op ongeveer 9 cm/eeuw. Voor een periode van 80 jaar (de leeftijd van de Afsluitdijk) is de relatieve zeespiegelstijging ongeveer 11,5 cm.

Uit een rapport van Shell uit 2006 betreffende gaswinning in de Waddenzee komt de volgende grafiek. Het betreft de gemiddelde zeespiegelhoogte in Den Helder van 1870 tot 2005. Shell komt op een relatieve zeespiegelstijging van 22,4 cm/eeuw inclusief een waargenomen versnelling gedurende de laatste decennia. De oranje lijn zou de mondiale zeespiegelstijging weergeven. Voor een periode van 80 jaar betekent dit een stijging van ongeveer 18 cm.

Conclusie: Vellinga neemt het hier niet zo nauw met de waarheid: hij overdrijft de zeespiegelstijging de afgelopen 80 jaar met een factor 3 tot meer dan 5, afhankelijk van de gebruikte meetreeks. Dat is wel een hele ruime marge voor een wetenschapper.

” Opwarming van het klimaat zorgt de komende eeuwen voor een significante stijging van de zeespiegel. Zelfs bij een succesvol klimaatbeleid met een opwarming van minder dan 2 graden Celsius stijgt de zeespiegel deze eeuw 75 tot 80 centimeter ten opzichte van 2000. Rond 2300 is een verdere stijging tussen de 1,5 en 4,0 meter te verwachten, met als meest waarschijnlijke stijging 2,7 meter. Dat schrijven internationale klimaatonderzoekers, waaronder van Wageningen University, in het wetenschappelijk tijdschrift Nature Climate Change van 24 juni. Zij doen die uitspraken op basis van zeer uitvoerige berekeningen van de zeespiegelstijging in de afgelopen duizend jaar en beleidsscenario’s rond de uitstoot van broeikasgassen in de komende eeuwen.

Met een gericht klimaatbeleid kan de uitstoot van CO2 verder worden teruggebracht en daarmee de opwarming op max. 1,5 graad Celsius uitkomen. In die omstandigheden valt volgens de onderzoekers de meest waarschijnlijke stijging in 2300 lager uit, maar die is dan naar schatting nog altijd ruwweg 1,5 meter. Als de klimaatopwarming in de komende eeuwen uitkomt op 3 graden, dan is een stijging tussen 2 en 5 meter te verwachten, met een meest waarschijnlijke stijging van 3,5 meter.”

Aan de aanhalingstekens en de cursieve letter is al te zien dat dit een citaat is en dat dit niet uit eigen koker komt. Het is een deel van een persbericht dat de WUR gepubliceerd heeft naar aanleiding van een nieuwe publicatie van Michiel Schaeffer, William Hare, Stefan Rahmstorf en Martin Vermeer, Long-term sea-level rise implied by 1.5°C and 2°C warming levels, in Nature Climate Change van 24 juni 2012.

Nu waren we al wat gewend na het rapport van de Deltacommissie onder leiding van Cees Veerman. De commissie bestond uit 10 mensen, van wie er zeggen en schrijven 3 iets hebben gestudeerd dat met het onderwerp zeespiegel te maken heeft. Conclusie van de commissie: rond 2100 is de zeespiegel tussen 65 en 130 cm gestegen. Hoon was hun deel, toen bleek dat die 130 cm bij elkaar gerommeld was. Wat dat betreft vallen die 75 tot 80 cm in het jaar 2100 van het rapport van Schaeffer et al best wel mee. Maar is het reëel?

Schaeffer et al zeggen dit:

“Projecting sea level into the future is still associated with large uncertainties. Physics-based models attempting to predict the combined contributions from thermal expansion, glaciers and ice sheets are not yet mature and underestimate the SLR observed in past decades. One of the largest uncertainties at present is the response of the Greenland and Antarctic ice sheets, where process-based models do not capture the full response so far observed1, nor the timescales of response seen in the palaeorecord.

Voorzichtigheid dus ook bij de auteurs, maar desalniettemin een voorspelling van een forse zeespiegelstijging voor de komende 90 jaar. Laat ik daarom eens enkele aspecten van de publicatie onder de loep nemen. In de publicatie “Long-term sea-level rise implied by 1.5°C and 2°C warming levels” maken de auteurs gebruik van een zogenaamd semi-empirisch model om toekomstige zeespiegelstijging te voorspellen. Voor het gebruik van dit model is een record van zeespiegeldata een voorwaarde. De publicatie “Long-term sea-level rise implied by 1.5°C and 2°C warming levels” leunt daarom sterk op een publicatie van Kemp et al uit 2011, getiteld “Climate related sea-level variations over the past two millennia”.While these models are further developed, semi-empirical models have emerged as a complementary approach and have shown their ability to reproduce sea-level evolution over the past millennium and the modern tide-gauge record well, leading to projections that are robust against different choices of input data and statistical approach. It remains open, however, how far the close link between global sea level and temperature found for the past will carry on into the future.

Despite this caveat, the results presented here provide at least plausible estimates for sea-level evolution in the coming centuries and a number of robust insights into how it can be affected by mitigation measures. A key aspect of this, irrespective of the exact numbers, is the long response time of sea level that is physically expected from the slow response of large ice sheets and the deep ocean to climate change, and also found in palaeoclimate data2. This slow response means that about half of the twenty-first century SLR is already committed from past emissions. ”.

Deze publicatie voorziet de onderzoekers van zeedata over de afgelopen 2 millennia. Zoals te zien is zijn ook hier Rahmstorf en Vermeer leading authors. Pikant is dat Michael (hockeystick) Mann co-auteur is. Michael Mann was nodig om de auteurs te voorzien van cijfers over de temperatuur van de afgelopen 2000 jaar. Die komen uit zijn publicatie uit 2008, getiteld “Proxy-based reconstructions of hemispheric and global surface temperature variations over the past two millennia”.

Dus de opzet ziet er als volgt uit:

1) De publicatie van Schaeffer et al doet een voorspelling over de toekomstige zeespiegel in 2012

2) Daarvoor is een reconstructie nodig van de zeespiegel over de afgelopen 2000 jaar, die wordt geleverd door Kemp et al in 2011

3) De reconstructie van de zeespiegel gedurende de afgelopen 2000 jaar kan niet zonder een reconstructie van de globale temperatuur van de afgelopen 2000 jaar, en die wordt geleverd door Mann et al in 2008

In deze paragraaf zal ik me richten op de locatie van het onderzoek en de problemen en onzekerheden die daarmee samenhangen. Daarover heb ik a eerder op deze site geschreven. In een volgende bijdrage zal ik aandacht besteden aan het model dat de onderzoekers gebruikt hebben.

In het artikel van Kemp et al wordt een reconstructie van het zeeniveau van de afgelopen 2100 jaar uitgevoerd op basis van proxies uit twee kustmoerassen in North Carolina. Vervolgens tonen de onderzoekers aan dat voor tenminste de afgelopen 1000 jaar de zeespiegelstijging correleert met het globale temperatuurverloop. Althans, dat is wat de auteurs beweren. In onderstaande grafieken is een en ander aanschouwelijk gemaakt.

Een van die auteurs is Michael Mann, bekend van de hockeystickgrafiek. Geen wonder dan ook dat de publicatie op extra belangstelling mocht rekenen van diegenen die het klimaat kritisch volgen. En kritiek kwam er, zowel op de reconstructie van het zeeniveau als op de gebruikte temperatuurdata.

Laten we eerst eens naar de reconstructie van het zeeniveau kijken. De auteurs concluderen op basis van de studie dat er een viertal periodes te onderscheiden zijn:

a) van 100 v. Chr. tot 950 n.Chr. een stabiele zeespiegel

b) van 950 n.Chr. tot 1350 n.Chr. een stijging met 0,6 mm/jaar

c) van 1350 n.Chr. tot ongeveer 1880 n.Chr. stabiel en licht dalend

d) van ongeveer 1880 tot heden 2,1 mm/jaar

Voor een inleiding in de materie leest men bijvoorbeeld deze site, hoofdstuk “De Feiten” en dan “Zeespiegelstijging”. Het is dan al snel duidelijk dat van ‘één zeespiegel’ geen sprake is. Allerlei factoren hebben invloed op de zeespiegel, zodat men beter van regionale zeespiegel kan spreken dan van een mondiale, zeker in een relatief korte tijdsspanne.

Onderhavige studie baseert de reconstructie van het zeeniveau op een aantal sedimentboringen op een tweetal plaatsen, vlak bij elkaar gelegen aan de oostkust van de USA. Tot voor kort, voordat de satelliet zijn intrede deed, was men uitsluitend aangewezen op onderzoek langs de kust. Dat juist dergelijk kustonderzoek voor extra complicaties zorgt is bekend. Mörner (2010) vat de problemen die kunnen ontstaan bij een reconstructie van het zeeniveau langs de kust bondig samen in onderstaande figuur.

Bron: Mörner

Bron: Mörner

Zoals op het kaartje goed te zien is, is de kust van North Carolina een sedimentatiekust, met strandwallen, en een achterliggend waddengebied, het haf. Eigenlijk is deze situatie heel goed vergelijkbaar met onze eigen kust in West en Noord Nederland. Net als in North Carolina is in ons haf op den duur veen ontstaan (Hollandveen). Dergelijke kusten zijn zeer dynamisch van aard (zie bovenstaand figuur) waardoor het zeer lastig is het zeeniveau te reconstrueren. Bovendien is het extra lastig op basis van de veenafzettingen dergelijk onderzoek te doen omdat veenafzettingen organisch van aard zijn, en te maken hebben met inklinken, mar ook met andere geochemische reacties.

De auteurs zeggen over de betrouwbaarheid van deze data: “Agreement of geological records with trends in regional and global tide-gauge data (Figs. 2B and 3) validates the salt-marsh proxy approach and justifies its application to older sediments. Despite differences in accumulation history and being more than 100 km apart, Sand Point and Tump Point recorded near identical RSL variations.”

Bron: WUWT

Bron: WUWT

Eschenbach heeft in een bijdrage voor WUWT uitgezocht of de salt-marsh proxy approach in de studie inderdaad gerechtvaardigd wordt door nabijgelegen getijdedata. In bovenstaande figuur zijn de 2 nabijgelegen getijdemeetpunten weergegegeven, namelijkHampton Roads en Wilmington.

Van de eerste gaan de data terug tot 1927, van de tweede tot 1935. Bovendien heeft Eschenbach de satellietgegevens van TOPEX

gebruikt die lopen vanaf 1992. In onderstaande figuur zijn alle data bijeengebracht om te zien of “global tide-gauge data (Figs. 2B and 3) validates the salt-marsh proxy approach and justifies its application to older sediments” zoals de auteurs beweren.

Bron: WUWT

Bron: WUWT

Opvallend is dat de gemiddelde zeespiegelstijging van Wilmington 2 mm/jaar is, terwijl die van Hampton Roads 4,5 mm/jaar is. Beide meetpunten liggen nog geen 300 km van elkaar. Overigens een prachtig bewijs dat Mörner gelijk heeft. Maar de grafiek laat tevens zien dat beide getijdedatareeksen zo ver uiteen lopen dat van een ‘valitation’ van de gebruikte aanpak geen sprake kan zijn. Zeker als men in daarbij de verschillen tussen de gekozen meetpunten Tump Point en Sand Point betrekt: de zeespiegelstijging van het eerste is bijna 50% groter dan van de laatste.

Eschenbach vat dit zo samen: ” We don’t have good observations to compare with their results, so virtually any reconstruction could be claimed to be “validated” by the nearby tidal gauges. In addition, since the Tump Point sea level rise is nearly 50% larger than the Sand Point rise, how can the two be described as “near identical” ?” . Overigens vertoont de recente satellietmeting van TOPEX een gemiddelde stijging vanaf 1992 van 0,5 mm/jaar.

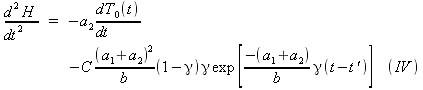

In deze paragraaf ga ik in op het door Kemp et al gebruikte wiskundige model om met behulp van de gereconstrueerde zeespiegeldata van de afgelopen 2000 jaar een voorspelling te doen voor de komende eeuwen. Tom Moriarty heeft in zijn weblog climatesanity het gebruikte model aan een nadere inspectie onderworpen. Moriarty is fysicus en Senior Scientist bij de US Department of Energy’s National Renewable Energy Laboratory. Moriarty ploos het gebruikte wiskundige model van Kemp et al uit en gebruikte daarvoor ook de modellen die de auteurs in voorafgaande publicaties gebruikten. Zie hiervoor zijn bijdragen. KMVR2011 is de bovengenoemde publicatie van Kemp:

“ Here is the KMVR2011 model:

where

Where H is the sea level, T(t) is the global temperature, Too, a1, a2, b and τ are all constants and To(t) is a to-be-determined time varying function related to T(t) as defined by equation Ia.

Now, consider the following temperature evolution. It is nearly the same as equation II from my previous post, but has an additional unitless constant, γ (a.k.a. “gamma”), in the exponential…

If equation II is inserted into equation I, then…

Rearranging terms in equation III gives…

H is the sea level. dH/dt, the derivative of the sea level, is the sea level rise rate. d2H/dt2, the second derivative of the sea level, is the rate at which the sea level rise rate changes. That is, d2H/dt2, is the acceleration. If d2H/dt2, is positive, the sea level rise rate is increasing. Conversely, if d2H/dt2, is negative, then the sea level rise rate is decreasing. Taking the time derivative of equation IIIa gives…

Let’s also consider the difference in the sea level rise rates at some time, t, for different values of γ. We can do this by analyzing the derivative of dH/dt (equation IIIa) with respect to γ.

What does the math tell us? KMVR2011 does not conclude with specific values for their model constants and their time varying T0(t). Instead, they present probability density distributions for some constants, or combination of constants. However, there are some definite constraints that can be noted about the variables and their relationships to each other. These constraints are key to my conclusions.

Constraints:

*) a1 + a2 = a, where a1 and a2 are defined in KMVR2011 (see equation I, above) and a is defined in VR2009. VR2009 found a = 5.6 mm/yr/K.

*) a1 > 0 mm/yr/K and a2 > 0 mm/yr/K. KMVR20011 states that the distribution of a1 for their Bayesian analysis varied between 0.01 and 0.51 mm/yr/K. Needless to say, if either of these terms were less than zero the KMVR2011 model would make even less sense that it does now. That would be a road that the KMVR2011 authors do not want to travel.

*) b < 0 . VR2009 found b = -49 mm/K. KMVR2011 varied b about -49 mm/K with σ2 = (10 mm/K)2 for their Bayesian analysis.

( VR2009 is de publicatie van Vermeer en Rahmstorf , 2009 PNAS paper, “Global sea level linked to global temperature“ ( Rob de Vos))

*) C > 0. C is a unitless constant that I introduced, and for the purposes of this post I am constraining C to be greater than zero.

*) γ > 0. γ is a unitless constant that I introduced, and for the purposes of this post I am constraining γ to be greater than zero.

*) Time, t, is restricted to about 1900 and later for my hypothetical temperature (equation II). This insures that T(t) > T0(t), which in turn insures that dT0(t)/dt > 0.

The equations above, coupled with the listed constraints guarantee the signs of the derivatives shown in table 1, below.

Table 1. Derivatives of temperatures and second derivatives of sea level.

Green “up arrows” indicate increasing values and red “down arrows” indicate decreasing values.

As you can see from table 1, it gets little confusing for 0<γ<1. When a1, a2, b, C, and γ conform to the listed constraints, the signs of the various derivatives are known with certainty as long as…

But when …

at some point in time t- t’ will become large enough that d2H/dγdt will become positive. When that time occurs depends on the choices of a1, a2, b and γ. If we choose a1, a2 and b to agree with VR2009 (recall a1 +a2 = a = 5.6 mm/yr/K, and b = -49 mm/K) and γ = 0.8, then d2H/dγdt will continue to be negative until t – t’ = 44 years. “.

De conclusie van Moriarty uit bovenstaande exercitie in hogere wiskunde is nogal absurd: Het model van Kemp et al levert bij hogere temperatuurstijgingen geen stijging van het zeeniveau op maar een daling ervan! Deze grafiek geeft de temperatuurstijging weer bij verschillende scenario’s:

En dit zij de gevolgen voor de zeespiegel als men het model van Kemp et al hanteert:

Conclusie: het gehanteerde model voorspelt zeespiegeldalingen bij temperatuurstijgingen. Volgens Kemp is dit een gevolg van het feit dat de constante b een negatief teken heeft.

Stefan Rahmstorf zei over Moriarty: “ Science progresses by peer-reviewed publications, not blogs. We are well advanced in preparing a paper that includes the latest sea level data and groundwater pumping estimates, as well as looking at a number of other factors. That will be up for discussion once it appears in the peer-reviewed literature. (Without giving away too much, I can probably already say that we come to different conclusions from what you claim.) ”.

Dit commentaar van Rahmstorf deed hij vóór de laatste publicatie. Misschien zou het voor de wetenschap goed zijn als Rahmstorf zijn academische arrogantie eens opzij zou zetten. Moriarty is niet de eerste ‘leek’ die buiten het formele circuit van publicaties om laat zien dat hij verstand van zaken heeft. Maar helaas wordt hij , net als McIntyre, gezien als een gevaarlijke buitenstaander. Dat dit tot verhitte debatten en ferme uitspraken leidt leest men in deze blog.

Zeespiegel Den Helder stijgt al 146 jaar constant

De zeespiegel bij Den Helder wordt al vanaf 1865 meerdere malen per dag gemeten. De gegevns zijn van PSMSL, de instantie die de meetgegevens van vrijwel alle getijdemetingen bijhoudt. Met behulp van deze gegevens berekent men dagelijkse, maandelijkse en jaarlijkse gemiddelden. In bovenstaande figuur heb ik de jaarlijkse gemiddelden uitgezet in een grafiek. Tevens heb ik een lineaire trendlijn door Excel laten berekenen en tekenen. Dat is de zwarte lijn. Zoals u ziet is er geen versnelling in de zeespiegelstijging te bekennen. De verticale schaal is gebaseerd op de zogenaamde RLR, Revised Local Reference, de standaardisatie die PSMSL toepast op de meetgegegevens.

Waarom is het feit dat er geen versnelling te constateren valt bijzonder? Omdat het IPCC in haar rapport uit 2007 stelde: “ Satellite altimetry… shows that since 1993, sea level has been rising at a rate of around 3 mm/yr, significantly higher than the average during the previous half century. Coastal tide gauge measurements confirm this observation.”. Dat had het IPCC natuurlijk niet zelf verzonnen, maar gehaald uit een toen recente publicatie van Church en White uit 2006, A 20th century acceleration in global sea-level rise. Natuurlijk kan men tegenwerpen dat Den Helder niet de wereld is, maar ik zal een volgend keer laten zien dat het verloop van de zeespiegelstijging in Den Helder eerder regel dan uitzondering is op aarde.

De jaarlijkse schommelingen zijn tamelijk groot, zodat de R-kwadraat van de lineaire trendlijn niet groter is dan 0,7625. De blauwe lijn lijkt heel fraai de lineaire trendlijn te volgen. Om te zien of er in de data toch geen sprake is van een versnelling in de zeespiegelstijging zoals het IPCC en Church en White beweren, heb ik hieronder voor dezelfde date een exponentiele trendlijn ingetekend. Zoals te zien is, is deze vrijwel kaarsrecht, hetgeen ook bevestigd wordt door r2= 0,7624. Een afwijking van de r2 van de lineaire trendlijn van slechts 1/1000 !

Dat alarmisten ons graag willen laten geloven dat de zeespiegel vanwege AGW veel harder stijgt dan vroeger heb ik hier al vaker aan de kaak gesteld. Ik denk bijvoorbeeld aan professor Pier Vellinga uit Wageningen die op de televisie de zeespiegelstijging van de afgelopen 80 jaar met een factor 7 (!) overdreef .

De Deltacommissie onder leiding van Cees Veerman ( de man die overal verstand van heeft) voorspelt een maximale zeespiegelstijging van maar liefst 135 cm voor het eind van de eeuw. De zeespiegelstijging in Den Helder is de afgelopen 100 Jaar niet meer dan 15 cm gestegen. Dat betreft de relatieve zeespiegelstijging, dus inclusief de bodemdaling ter plaatse van ongeveer 5 cm/eeuw. En van een versnelling is nog steeds geen sprake. De zee moet dus voortmaken!

Zeespiegel in de rest van de wereld

Conclusie is dat de zeespiegelstijging in Den Helder tussen 1865 en 2012 geen enkele versnelling laat zien.

De data waarop de grafiek van Den Helder gebaseerd is komt van PSMSL in Groot Brittannië en NOAA in de USA.

PSMSL en NOAA baseren hun reeksen op data die komen van diverse organisatie in veel landen. Zo levert Rijkswaterstaat de data van Den Helder. Hieronder ziet u een lijst van meetstations die PSMSL gebruikt, inclusief zeeniveautrends:

Het betreft 194 meetstations. Om beter zicht te krijgen op de trends in zeespiegelstijging heb ik de data van de stations in Excel ingevoerd. Daarvoor heb ik alleen die stations gebruikt waarvan de data doorlopen tot na 2005. Er blijven dan 147 stations over. Dit zijn de resultaten:

De meeste trendwaarden liggen ergens tussen 0 en 4. Opmerkelijk is dat er vrij veel stations zijn die over de gemeten periode een negatieve stijging vertonen, en relatieve zeespiegeldaling dus. Vooral aan het begin van de grafiek is een dergelijke cluster te zien. Dat zijn alle meetstations in Scandinavië. Scandinavië veert sinds het einde van de laatste ijstijd (10.000 jaar geleden) op als gevolg van het afsmelten van de Scandinavische ijskap. Dat effect, glacio-isostasie genoemd, is zo sterk dat het stijgen van het land sneller gaat dan de absolute zeespiegelstijging.

Ook sommige Candese meetstations vertonen dit beeld als gevolg van het afsmelten van de Canadese ijskap. Verder is er nog een aantal meetstations dat vanwege subductie een sterke stijging van het land vertoont en derhalve een negatieve zeespiegelstijging.

Voorbeelden daarvan zijn te o.a. vinden in Japan. Aan de bovenkant van de grafiek zijn ook uitschieters te zien. Deze meetstations tonen een opvallend grote relatieve zeespiegelstijging. Deze meetstations ondervinden een sterke daling van het land als gevolg van subductie, of als gevolg van sterke sedimentatie.

Probleem blijft dat alle meetstations op een of andere wijze beïnvloed worden door bodemdalingen en –stijgingen. Gemiddeld over de gehele aarde zou de bodemdaling theoretisch de 0 moeten naderen. Als we uitgaan van een perfect gelijkmatige geografische en geologische spreiding van alle meetstations dan zou de eerste grafiek bruikbaar zijn om de gemiddelde absolute zeespiegelstijging te berekenen. Die zou in dat geval 0,68 zijn, dus 6,8 cm/eeuw. Maar de meetstations liggen niet perfect gelijkmatig verspreid: er zijn relatief veel stations in Europa en Noord-Amerika, en relatief weinig in Afrika. Men kan er dus van uit gaan dat de ongelijkmatige spreiding de grafiek beïnvloedt.

Opvallend blijft dat de meeste stations een trend aangeven tussen 0 en 4. Ik vermoed daarom dat ergens in deze wolk de gemiddelde absolute zeespiegelstijging verborgen ligt. Daarom ga ik de extreem afwijkende stations buiten beschouwing laten. Ik heb alle stations met een negatieve waarde verwijderd, alsmede alle stations met een trend van > 4 . Dit is volkomen arbitrair en wetenschappelijk onverantwoord, daar ben ik me van bewust. Maar wil een beeld krijgen van de globale zeespiegeltrend. Het resultaat is dit:

De rode lijn is de gemiddelde waarde van de trends van de overgebleven 102 meetstations: 1,56. Ik schat dat dit nog aan de hoge kant is.

De afwezigheid van enige versnelling in de zeespiegelstijging is niet in lijn met de opvatting dat de het globale zeeniveau gerelateerd is aan de globale temperatuur. Vermeer en Rahmstorf schreven in 2009: “ When applied to observed data of sea level and temperature for 1880–2000, and taking into account known anthropogenic hydrologic contributions to sea level, the correlation is >0.99, explaining 98% of the variance. For future global temperature scenarios of the Intergovernmental Panel on Climate Change’s Fourth Assessment Report, the relationship projects a sea-level rise ranging from 75 to 190 cm for the period 1990–2100. ”

Bovenstaande figuur uit de publicatie van Vermeer en Rahmstorf , “Global sea level linked to global temperature” (PNAS, 2009) ,

toont met de rode lijn de gemeten zeespiegelstijging en –versnelling vanaf 1880. Er zijn twee periodes te herkennen met versnelling van de stijging: tussen 1930 en 1950, en vanaf 1980.

Ook Church en White herkennen in hun studie een versnelling rond 1930, de tweede versnelling vindt plaats na 1990. Zie hier en hier.

Omdat er in de relatieve zeespiegelstijging van Den Helder geen enkele versnelling te bespeuren valt, was ik benieuwd of dat elders op aarde anders zou zijn. Immers, de perioden van versnelling van de zeespiegel zouden ergens in de tide-gauge-data toch merkbaar moeten zijn? Ik wilde daarvoor gebruik maken van meetstations die over de afgelopen 100 jaar een continue meetreeks produceerden. Daarvoor maakte ik wederom gebruik van de databank PSMSL.

Om een indicatie te krijgen van de geografische spreiding van de gezochte data maakte ik gebruik van bovenstaande figuur uit de publicatie van Church en White uit 2011. Duidelijk is te zien dat er aan het begin van de 20e eeuw slechts een beperkt aantal meetstations was, met een sterke concentratie in Nederland, Duitsland, Denemarken, Japan en de USA. Ik ben alle aangegeven locaties in de databank nagegaan en heb naast Den Helder nog 7 andere meetstations gevonden met een min of meer continue meetreeks vanaf 1910 tot 2010 :

Victoria, Canada

San Francisco, USA

New York, USA

Honolulu, USA

Balboa, Panama

Fremantle, Australië

North Shields, GB

Er zijn nog enkele meetstations met een meetreeks van (meer dan) een eeuw, maar die liggen dicht bij een van bovenstaande stations en leverden geen relevante meetgegevens op. Omdat ik niet in staat ben om sterke verticale bewegingen in de aardkorst statistisch te elimineren heb ik afgezien van meetstations die in sterke mate onderhevig zijn aan epirogenetische en tektogenetische bewegingen, zoals in Scandinavië en Japan. Omwille van de eenvoud ben ik ervan uitgegaan dat voor de overgebleven meetstations geldt dat bodembewegingen gedurende de afgelopen eeuw constant waren. Ik ben immers alleen geïnteresseerd in een eventuele versnelling van de zeespiegel. Dit zijn de resultaten:

Het beeld is in alle gevallen duidelijk: van een versnelling van de zeespiegelstijging is geen sprake. Omdat in alle grafieken te controleren heb ik behalve de lineaire trendlijn (zwart) ook de exponentiele trendlijn (rood) in elke grafiek weergegeven. Beide lijnen vallen in alle grafieken vrijwel geheel samen. Van beide trendlijnen zijn de R2 –waarden in de grafieken weergegeven. Om te laten zien wat de lineaire trendlijn en exponentiele trendlijn doen als er in een meetreeks sprake is van een versnelling heb ik een eenvoudige lineaire meetreeks gemaakt, met tussen de horizontale waarden 9 en 13 een versnelling in de reeks . Het resultaat ziet u hier onder:

Comclusie: in bovenstaande meetreeksen van tide-gauge-metingen over de gehele aarde zijn geen versnellingen in de zeespiegelstijging waar te nemen. Dat staat dus haaks op de gegevens van Church en White, Vermeer en Rahmstorf en falsifieert de hypothese dat het globale zeeniveau sterk gerelateerd is aan de globale temperatuur. De zeespiegelstijging lijkt zich niets aan te trekken van relatief korte ( enkele decennia) perioden van temperatuurstijging zoals die waargenomen zijn in de afgelopen eeuw.

Bron: Wallace & Hobbs, Atmospheric Science

Bron: Wallace & Hobbs, Atmospheric Science